導讀:文字分類是NLP領域一項基礎工作,在工業界擁有大量且豐富的應用場景。傳統的文字分類需要依賴很多詞法、句法相關的human-extracted feature,自2012年深度學習技術快速發展之後,尤其是迴圈神經網路RNN、摺積神經網路CNN在NLP領域逐漸獲得廣泛應用,使得傳統的文字分類任務變得更加容易,準確率也不斷提升,本文主要內容整理自網路,彙集了2014年以來,DL在文字分類領域相關的6篇論文,主要從CNN、RNN、Attention、RNN+CNN,或Word-level、Character-level角度出發,提升文字分類準確率。

文字附論文及原始碼下載地址。

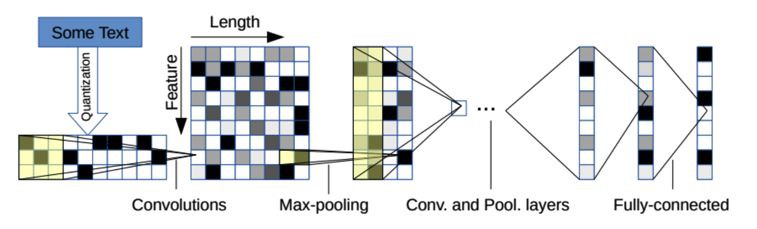

Convolutional Neural Networks for Sentence Classification

主要內容:基於預先訓練好的word embedding,採用摺積神經網路( CNN )訓練了一個word-level的句子分類器,併進行了一些列的實驗來驗證分類效果。實驗證明,一個簡單的CNN模型,只需要調整少量超引數和word embedding,在多個標準資料集上都取得了很好的效果。根據特定的任務對word embedding進一步fine-tuning,可以進一步提高分類效果。此外,還提出了一些對模型結構的進行簡單修改的建議,以允許模型同時使用task-specific embedding和預先訓練好的static embedding。

Character-level Convolutional Networks for Text Classification Very Deep Convolutional Networks for Text Classification

主要內容:本文主要研究字元級(character-level)摺積網路( ConvNets )在文字分類中的應用。構建了幾個大規模資料集,以證明字元級的摺積網路可以獲得更好的分類結果。並與傳統模型(如bag-of-words、n – gram及TFIDF變體)和深度學習模型(如基於單詞的ConvNets和遞迴神經網路)進行了比較。

Very Deep Convolutional Networks for Text Classification

主要內容:本文是首次將非常深度摺積網路應用於文字處理。NLP領域使用最多的DL模型有遞迴神經網路,特別是LSTMs和摺積神經網路。但與計算機視覺領域的深層摺積網路(Google InceptionNet,ResNet)相比,NLP常用的深度學習模型深度還是比較淺。本文提出了一種新的,character-level的文字處理架構( VDCNN ),只使用小的摺積和池化操作。實驗證明,模型的效能隨著深度的增加而增加:最後達到29個摺積層,併在多個文字分類任務上的取得了最優的成績。

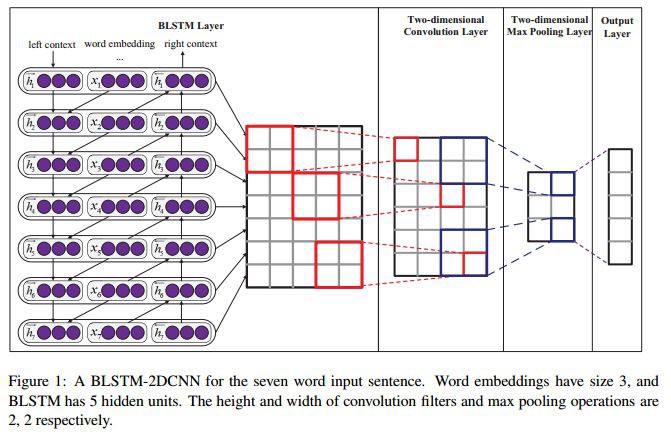

Text Classification Improved by Integrating Bidirectional LSTM with Two-dimensional Max Pooling

主要內容:遞迴神經網路( RNN )是自然語言處理( NLP )任務中最常用的網路結構之一,因為它的遞迴結構非常適合處理不同長度的文字。RNN可以基於word的embedding,把整個句文字抽取成一個矩陣。這個矩陣包括兩個維度:時間步長維度和特徵向量維度。現有的大多數模型通常只在時間步長維度上透過一維( 1D )max-pooling操作或基於註意力的操作來把整個整個句子轉換成一個固定長度的向量。但這就存在一個問題:特徵向量維上的特徵向量之間並不是相互獨立的,簡單地在時間步長維度上單獨應用1D的max-pooling可能破壞特徵表示的結構。相反,在二維上應用二維( 2D )pooling操作可以獲得更多對序列建模任更有意義的特徵。為了整合矩陣的兩個維度上的特徵,本文提出使用2D max-pooling操作來獲得文字的固定長度表示。本文還利用二維摺積對矩陣中更有意義的資訊進行了取樣。對情感分析、問題分類、主觀性分類和新聞組分類6個文字分類任務進行了實驗。與現有模型相比,所提出的模型在6個任務中的4個任務上取得了最優的結果。

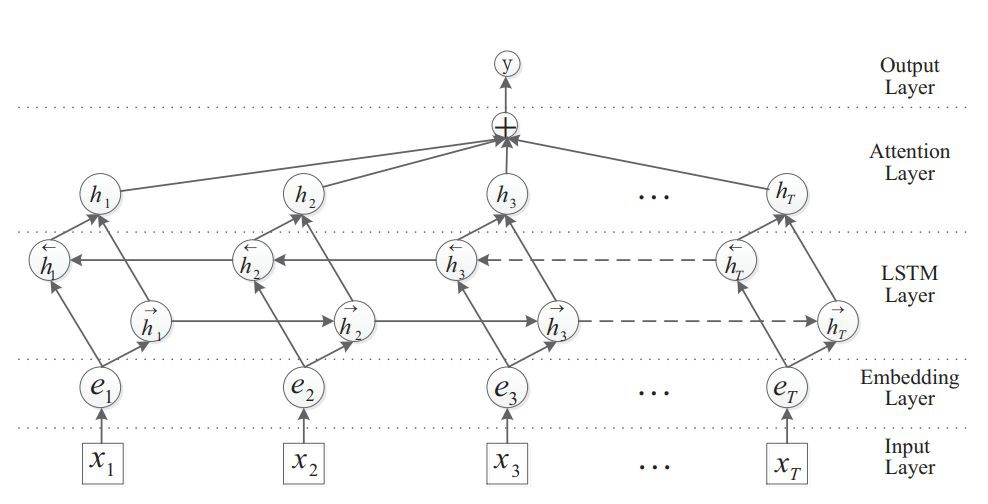

Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification

主要內容:關係分類是自然語言處理領域的一項重要語意處理任務。但存在兩個問題:1、即使是最先進的系統仍然需要依賴一些lexical resources(如WordNet )或NLP系統(如依賴與句法分析和命名物體識別)來獲得高階特徵。2、重要資訊會出現在句子的任何位置。針對這些問題,本文提出了基於註意力機制的雙向長短期記憶網路( Att-BLSTM )來捕捉句子中最重要的語意資訊。在SemEval – 2010關係分類任務上的進行試驗,結果證明該方法優於現有的大多數方法。

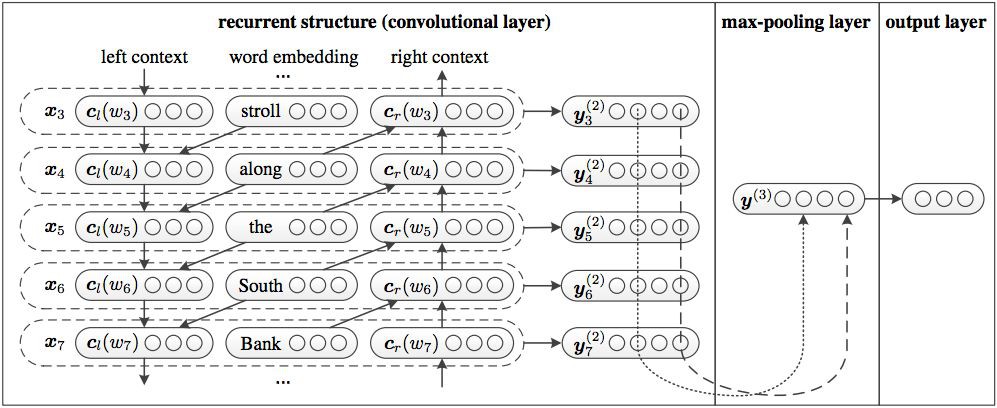

Recurrent Convolutional Neural Networks for Text Classification

主要內容:文字分類是許多NLP應用中的基礎任務。傳統的文字分類器往往依賴於許多人為設計的特徵,如字典、知識庫和特殊的樹結構。與傳統的文字分類方法相比,本文將摺積神經網路和迴圈神經網路相結合,提出了一種無需人為feature的遞迴摺積神經網路。在模型結構中中,採用一種遞迴結構來盡可能地捕獲背景關係資訊,學習word的表示,這與傳統的基於視窗的神經網路相比,引入更少的噪聲。還採用了一個max – pooling層,自動判斷哪些詞在文字分類中起著關鍵作用,以捕獲文字中的關鍵資訊。在四個常用資料集上進行了實驗,實驗結果表明,在多個資料集上,特別是在檔案級資料集上,該方法的效能優於現有的方法。

論文及原始碼下載地址

原始碼下載地址:https://github.com/dongjun-Lee/text-classification-models-tf

論文下載地址:

連結: https://pan.baidu.com/s/1mB0YzlWiU2m0ryu3zWAUyQ

密碼: 4xh7

往期精彩內容推薦

一文告訴你Adam、AdamW、Amsgrad區別和聯絡,助你實現Super-convergence的終極標的

AI教父-深度學習之父-Geffery Hinton個人簡介

李宏毅-深度學習與生成對抗學習基礎-2018年(春)課程分享

DeepLearning_NLP

深度學習與NLP

商務合作請聯絡微訊號:lqfarmerlq

知識星球

知識星球