近些年來,隨著深度學習在眾多實際應用中取得成功,在越來越多的科學領域內,研究人員開始嘗試利用深度學習來解決各自領域的傳統難題。和深度學習已獲得成功的問題(比如影象分類)相比,許多科學領域內的問題往往有完全不同的特性。

因此,理解深度學習的適用性,即其能做什麼尤其是不能做什麼,是一個極為重要的問題。比如設計演演算法的時候,它可以幫助我們考慮是完全用深度學習來代替傳統演演算法,還是僅在這個問題中的某些步驟用深度學習。

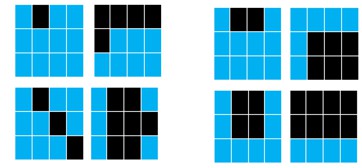

為了探討這個問題,我們首先來看下麵這個例子。在下麵兩組圖中,左組中的每張圖和右組有什麼差別呢?

答案是左組的每張圖中黑塊數都是奇數,而右組都是偶數。這種按奇偶區分的函式數學上叫做 parity function: 。其函式值由“-1”的個數決定,如果為偶數,結果為 1,否則為 -1。

。其函式值由“-1”的個數決定,如果為偶數,結果為 1,否則為 -1。

對於該函式,如果取所有可能對映的一個子集進行訓練,深度神經網路能夠很好地擬合訓練資料,但對那些未見過的測試資料,深度學習幾乎沒有預測(泛化)能力。而對於人來說,只要能從訓練資料集中學到數“-1”個數這個規則,就很容易對未見過的資料進行準確分類。

對於很多問題,如影象識別,深度學習通常能取得較好的效果(泛化能力)。為了敘述方便,我們將這些深度學習能處理好的問題稱為第一類問題,同時將深度學習處理不好(難以泛化)的問題稱為第二類問題。

那麼這兩類問題有什麼本質差別呢?深度學習模型為什麼對這兩類問題有截然相反的效果?

目前為止,大部分實驗研究和理論研究集中於研究為什麼深度學習能取得好的效果(泛化能力)。少部分的研究開始關註哪些問題深度學習難以處理。

在我們的研究中,我們希望能找到一個統一的機制,可以同時解釋深度學習在兩類問題中不同的效果。我們發現的機制可以用一句話概括:深度學習傾向於優先使用低頻來擬合標的函式。我們將這個機制稱為 F-Principle(頻率原則)。

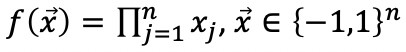

我們先用一個簡單的例子來理解 F-Principle。用一個深度神經網路(DNN)去擬合如下的紅色實線函式。訓練完後,該曲線能被深度網路(藍色點)很好地擬合。

我們感興趣的是 DNN 的訓練過程。如下圖動畫所示(紅色為標的函式的 FT(傅裡葉變換),藍色為網路輸出的 FT,每一幀表示一個訓練步,橫坐標是頻率,縱坐標是振幅),我們發現,在訓練過程中,DNN 表示的函式的演化在頻域空間有一個清晰的規律,即頻率從低到高依次收斂。

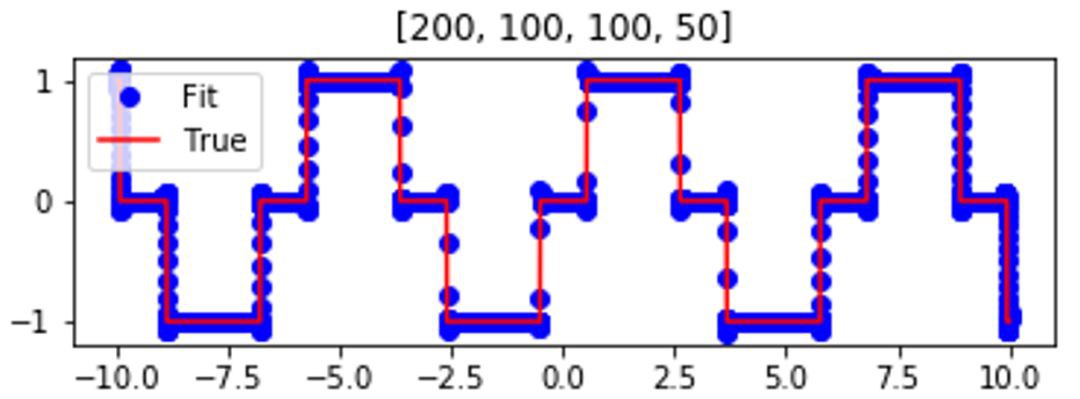

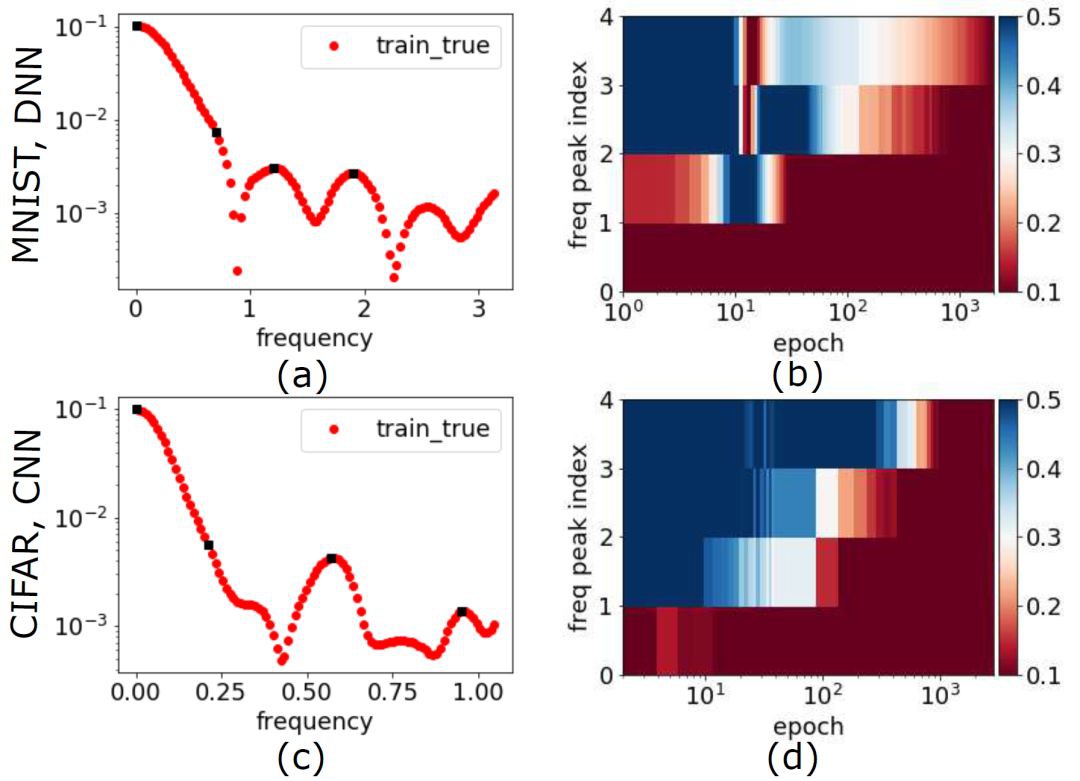

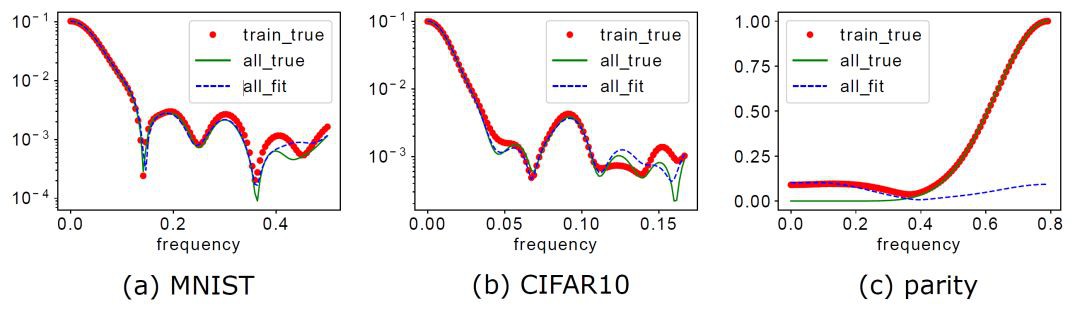

對於真實資料,如 MNIST 和 CIFAR10,對於不同的網路結構,如全連線和摺積神經網路(CNN),對於不同的啟用函式,如 tanh 和 ReLU,我們都可以觀察到 F-Principle(如下圖所示)。

▲ 左邊:資料集/DNN的Fourier變換在一個特定高維頻率方向的變化曲線,右圖:左圖中黑色頻率點處的相對誤差與訓練步數的關係,紅色表示相對誤差小。第一行是MNIST資料集的結果,使用全連線tanh網路。第二行是CIFAR10資料集的結果,使用ReLU-CNN網路。

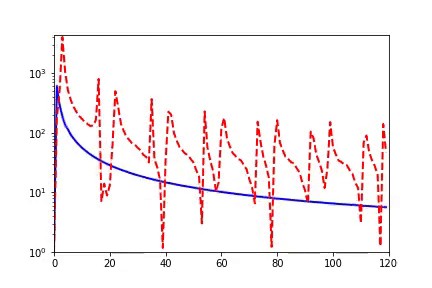

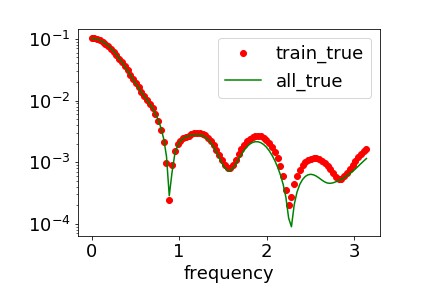

接下來,我們可以用 F-Principle 來理解為什麼 DNN 在上述兩類問題的處理中有巨大的差異。從頻譜的角度,我們發現 MNIST 和 CIFAR10 資料集都有低頻佔優的特性。實驗結果顯示,全資料集(包含訓練集和測試集)在頻域空間與測試資料集在低頻部分吻合地很好,如下圖展示 MNIST 的情況。

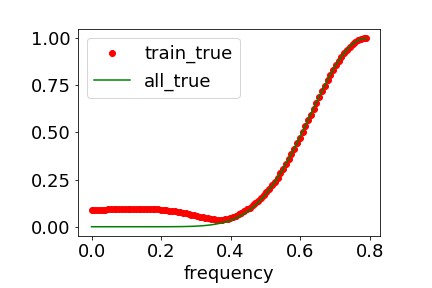

parity 函式則不同,它是高頻佔優的。

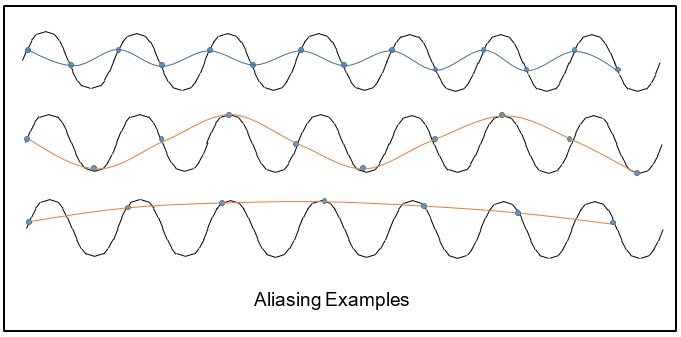

由於 aliasing 效應,相比真實的頻譜,訓練集的頻譜在低頻處有顯著的虛假成分(見上圖)。下圖展示了一個 aliasing 的例子。

因此,對於我們舉的例子,這兩類問題在 Fourier 空間可以看到本質的差別。前者低頻佔優,後者高頻佔優。在訓練過程中,基於 F-Principle 低頻優先的機制,DNN 會傾向於用一個低頻成分較多的函式去擬合訓練資料。

對於 MNIST 和 CIFAR10,一方面由於高頻成分較小,aliasing 帶來的虛假低頻微不足道,另一方面由於 DNN 訓練中低頻優先的傾向與標的函式本身的低頻佔優的特性相一致,所以 DNN 能準確抓取標的函式的關鍵成分(下圖藍色為 DNN 學習到的函式在全資料集上的傅裡葉變換在一個特定高維頻率方向的曲線),從而擁有良好的泛化能力。

而對於 parity 函式,由於高頻成分極為顯著,aliasing 帶來的虛假低頻很嚴重,同時 F-principle 低頻優先的傾向與標的函式本身高頻佔優的特性不匹配,所以 DNN 最終輸出函式相比於標的函式低頻顯著偏大而高頻顯著偏小。顯然,這種顯著的差異會導致較差的泛化能力。

▲ 紅色:訓練資料集的傅裡葉變換;綠色:全資料集的傅裡葉變換;藍色:網路輸出在全資料集輸入點的傅裡葉變換

我們利用 F-Principle 對深度學習能做什麼與不能做什麼做了初步的探索,理解了具有低頻優先特性的深度學習對於具有不同頻譜特性的問題的適用性。如果標的函式具有低頻佔優的特性,那麼深度學習比較容易取很好的效果,反之則不然。

進一步,我們可以利用深度學習這一特性更好地處理具體問題中的低頻成分。比如傳統演演算法(如 Jacobi 迭代)在解 Poisson 方程時,一般低頻收斂慢,而高頻收斂快。我們將在下一篇文章中介紹如何利用 F-Principle 機制設計基於 DNN 的 Poisson 方程求解方法。

參考文獻

Xu, Zhi-Qin John, Zhang, Yaoyu, Luo, Tao, Xiao, Yanyang & Ma, Zheng (2019), ‘Frequency principle: Fourier analysis sheds light on deep neural networks’, arXiv preprint arXiv:1901.06523 .

知識星球

知識星球