精選 6 篇來自 EMNLP 2018、ISWC 2018、NAACL 2018、ACL 2018 和 IJCAI 2018 的知識圖譜相關工作,帶你快速瞭解知識圖譜領域最新研究進展。

本期內容選編自微信公眾號「開放知識圖譜」。

■ 論文解讀 | 康矯健,浙江大學碩士,研究方向為知識圖譜、自然語言處理

論文動機

當前知識庫補全的方法主要是將物體和關係嵌入到一個低維的向量空間,但是卻只利用了知識庫中的三元組結構 () 資料,而忽略了知識庫中大量存在的文字,圖片和數值資訊。

本文將三元組以及多模態資料一起嵌入到向量空間,不僅能夠使連結預測更加準確,而且還能產生知識庫中物體缺失的多模態資料。

論文亮點如下:

-

透過不同的 encoders,將多模態資料嵌入成低維向量做連結預測;

-

透過不同的 decoders,能夠產生物體缺失的多模態資料。

模型

多模態資料的嵌入

1. 結構化資料:對於知識庫中的物體,將他們的 one-hot 編碼透過一個 denselayer 得到它們的 embedding;

2. 文字:對於那些很短的文字,比如名字和標題,利用雙向的 GRUs 編碼字元;對於那些相對長的文字,透過 CNN 在詞向量上摺積和池化得到最終編碼;

3. 圖片:利用在 ImageNet 上預訓練好的 VGG 網路,得到圖片的 embedding;

4. 數值資訊:全連線網路,即透過一個從的對映,獲得數值的 embedding;

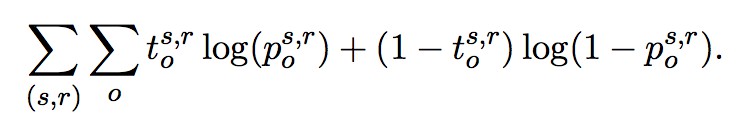

5. 訓練:標的函式(cross-entropy):

其中:![]() 是一個 one-hot 向量。如果知識庫中存在

是一個 one-hot 向量。如果知識庫中存在 這個三元組,值為 1,否則![]()

![]() 值為 0。

值為 0。![]() 是

是 模型預測出來的這個三元組成立的機率,它的值介於 0 到 1 之間。

解碼多模態資料

1. 數值和類別資訊:利用一個全連線網路,輸入是已經訓練好的向量,輸出是數值和類別,損失函式是 RMSE(數值)或者 cross-entropy(類別);

2. 文字:利用 ARAE 模型,輸入是訓練好的連續向量,輸出是文字;

3. 圖片:利用 GAN 模型來產生圖片。

實驗

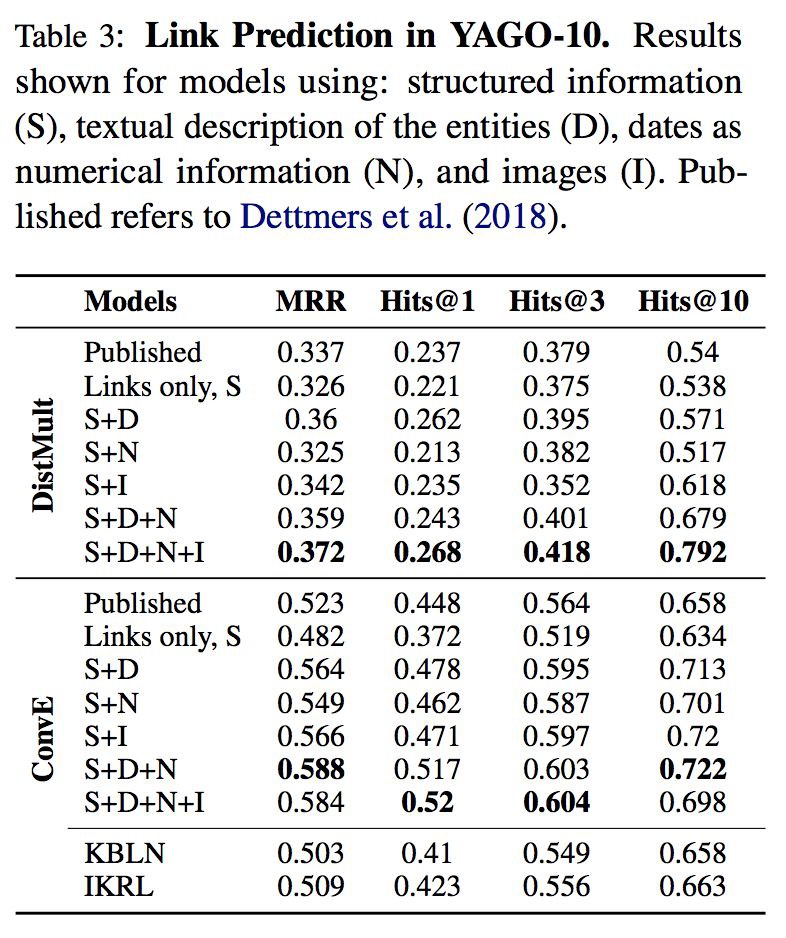

本文作者在 MovieLens-100k 和 YAGO-10 兩個資料集上面引入了多模態資料,其中 MovieLens-100k 引入了使用者資訊文字,電影資訊文字,電影海報;YAGO-10 也為物體引進了圖片,文字,數值等資訊。

連結預測

可以看到在引入了物體文字描述,圖片和數值之後,利用之前的嵌入模型,達到了 SOTA 的效果。

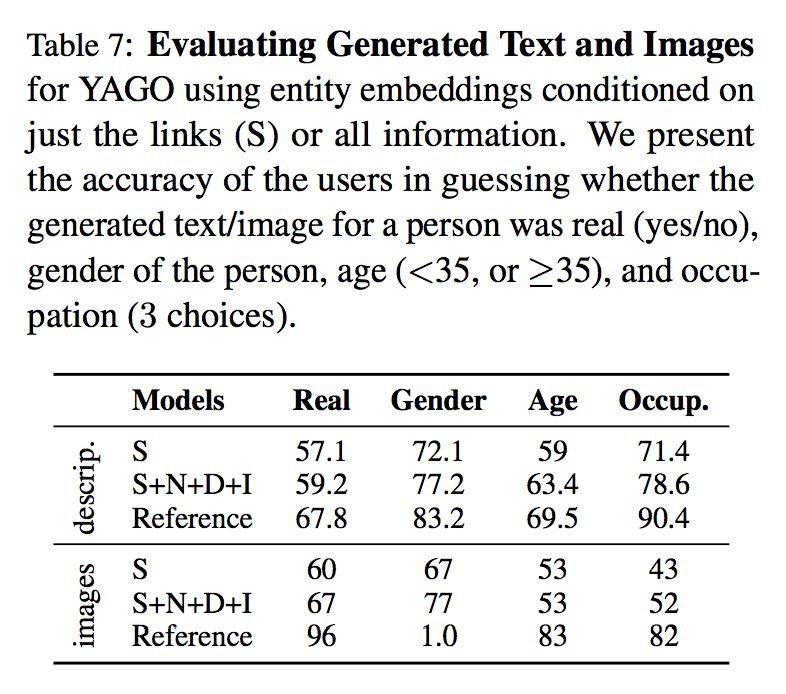

生成多模態資料

可以看到,引入了多模態資料之後,產生出來的文字和圖片的質量比起僅僅依靠知識庫原本就存在的三元組資訊產生的文字和圖片的質量要高。

總結

本文的創新點是引入了多模態資料來做知識庫中的連結預測和生成物體缺失的多模態資料。但是不足之處在於不知道到底引入的哪一部分多模態資料對最終的連結預測產生提升,以及產生的多模態資料質量不是很理想。這有待於後續工作的改進。

■ 論文解讀 | 曹二梅,南京大學碩士,研究方向為知識圖譜、知識融合

資訊抽取通常關註於抽取可辨識物體之間的關係,例如 <Monterey, locatedIn,California>。但是,除了說明具體物體之間的關係,文字中也經常含有計數資訊,表明與某個物體有特定關係的物件的數量,而未提及具體物件本身,例如“California is divided into 58 counties”。這種計數量詞可用於諸如查詢應答,知識庫管理等任務,但被先前的工作忽略了。

本文開發了第一個完整的從文字中提取計數資訊的系統 CINEX,將知識庫中的事實計數作為訓練種子,採用遠端監督的方法抽取文字中的計數資訊。實驗表明,在人工評估的 5 個關係上,CINEX 的平均抽取精度達到了 60%。在大規模實驗上,對於 Wikidata 的 110 種不同關係,CINEX 能夠斷言 250 萬事實的存在,比這些關係現有的 Wikidata 事實多 28%。

概念

本文用 SPO 形式的計數陳述句(Counting Statement)來描述知識庫中的計數資訊,主要關註對於一個給定的 SP 對,引數 O 的數量。

計數陳述句的形式化表示為 <S, P, ∃n>,其中,S 是 subject,P 是 predicate,n 是一個自然數(包括 0)。例如,陳述句 “President Garfield has 7 children” 將表示成 <Garfield, hasChild,∃7>。在 OWL 描述邏輯中,上述陳述句的形式化描述如下:

方法

CINEX 的標的是解決文字中計數量詞的抽取問題,問題定義如下:

CINEX 將知識庫中已有的事實計數作為種子,採用遠端監督的方法抽取文字中的技術資訊。遠端監督作為知識庫資訊抽取的主要方法,也是解決本文問題的一種相當自然的方法。

不過,用遠端監督解決計數資訊抽取,需要解決以下幾點挑戰:

1. 種子質量:與通常意義下的 SPO 事實抽取不同,本場景下知識庫的不完備不僅會導致訓練種子數量的減少,還會導致系統地低估實際事實的數量。例如:知識庫只知道特朗普的 3 個孩子,而實際上特朗普有5個,這會導致系統獎勵 “owns three golf resorts” 這樣的樣式,而懲罰 “his five children”。

2. 資料的稀疏性:對於很多關係,文字表達計數資訊的方式相當稀疏且高度傾斜。例如,一般人的 children 很少被提及;對於音樂家來說,贏得的第一個格萊美獎通常比之後的獲獎更多被提及,因此對“他/她的第一個獎項”的樣式會被給予過度的重視。還有,音樂樂隊的成員數量通常約為 4,這使得很難學習到樂隊成員數量非常大或非常小的樣式。

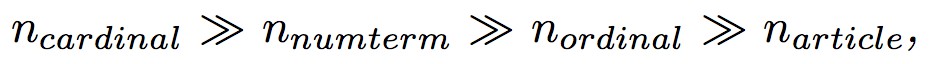

3. 語言多樣性:計數資訊可以用各種語言形式表達,如冠詞(“has a child”),基數詞(“has five children”),序數詞(“her third husband”),表數量的名詞短語(‘twins’,‘quartet’),表存在與否的副詞(‘never’,‘without’)。

CINEX 針對上述挑戰給出了對應的解決方法:

對於挑戰 1,CINEX 透過將數量的匹配條件放寬到比知識庫事實計數更高的值,同時將訓練種子限制於知識庫中資訊更完備的流行物體來處理。對於挑戰 2,CINEX 使用資訊熵來度量 numbers,過濾掉不提供資訊的 numbers。對於挑戰3,CINEX 透過仔細整合中間結果來處理。

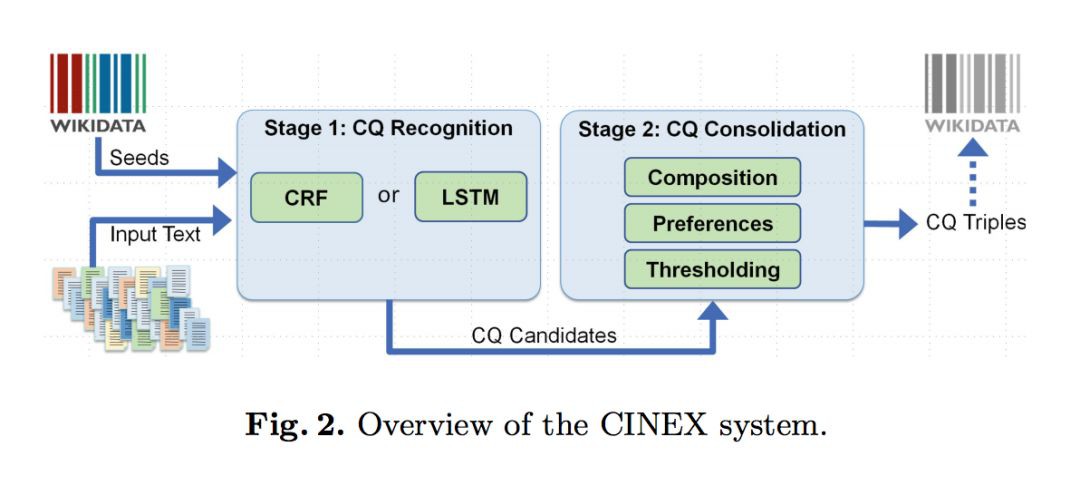

Fig.2 給出了 CINEX 系統的框架,系統將整體任務分為兩個階段:

1. 計數量詞的識別

CINEX 將其建模為序列標註問題,對每一個句子操作並且針對每一個謂詞P單獨學習。首先透過檢測文字中指示計數資訊的術語(基數,序數和數值項等)預處理輸入的句子,再用 CRF++ 模型以及 bidirectional LSTM-CRF 模型為每個感興趣的謂詞 P 學習一個序列標註模型,用於計數量詞的識別。

2. 計數量詞的合併

將第一階段識別出的多個表示計數或者組合資訊的中間結果,合併為物件數量的單個預測。

整合演演算法如下:

-

對需要組合的計數資訊求和,可信度得分設為被組合資訊中最高的值;

-

選擇每一種計數資訊的預測結果。對於基數詞和數值項,選擇高於設定閾值的計數資訊中可信度得分最高的;對於序數詞,不論可信度得分如何,總是選擇可信度得分最高的;

-

根據計數資訊型別排序,根據如下順序選擇最終結果。

實體

計數量詞的識別

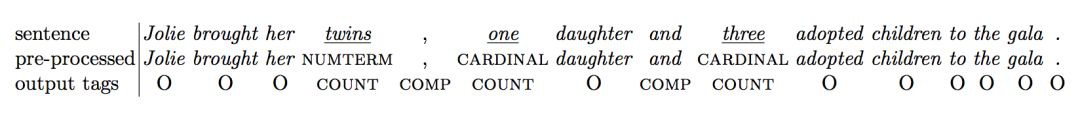

給定句子“Jolie brought her twins , one daughter and three adoptedchildren to the gala”,計數量詞識別階段預處理以及序列標註的結果如下:

計數量詞的合併

給定 SP 對 <AngelinaJolie, hasChild>,計數量詞的識別結果如下:

整合演演算法第 1 步會合併句子中的計數資訊 0.3 和 0.5,將其相加得到 0.5,句子中的計數資訊 0.1 和 0.2 將相加得到 0.2。第 2 步 0.5 被選為可信度得分最高的基數詞,0.8 被選為可信度得分最高的數值項,0.5 被選為排序最高的序數詞。第 3 步,根據排序偏好以及設定的可信度閾值,基數詞 0.5 或 0.8 將被作為最終預測結果。

實驗

資料集:Wikidata(知識庫),Wikipedia(文字)。

實驗結果

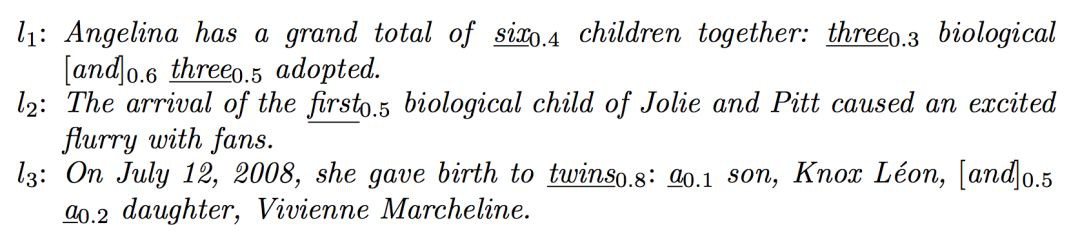

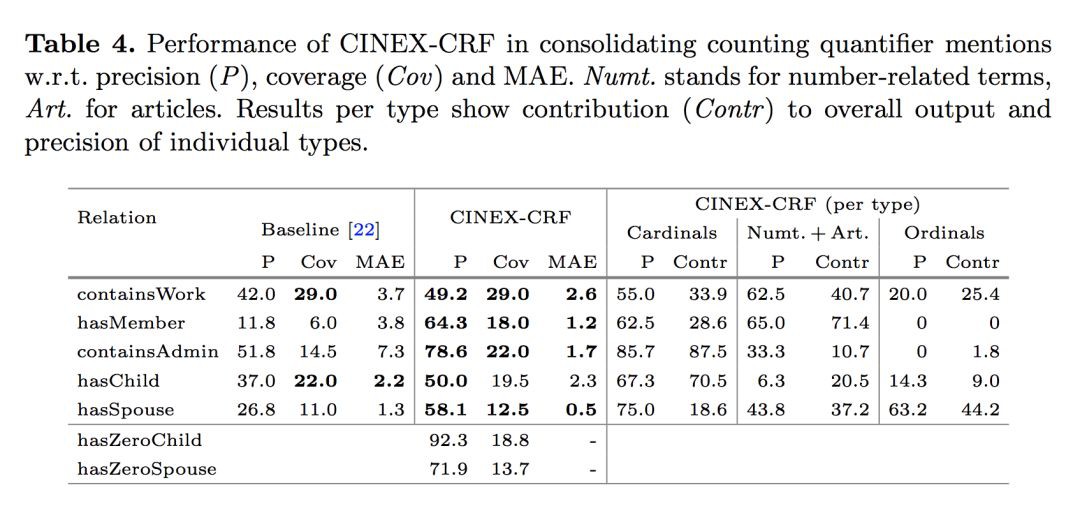

從 Table 2. 可知,計數量詞的識別基於特徵的 CRF 模型效果最好,神經網路模型容易過擬合。同時,CINEX-CRF 也是在整合和端到端任務中識別計數資訊效能最佳的系統。

對於各種型別的計數術語,由 Table 4. 的實驗結果可知,考慮數值項和冠詞有利於改善改寫率,考慮組合計數資訊以及除基數詞之外的其它型別術語,有利於提高準確性和改寫率。

對於 Wikidata 的 110 種關係,CINEX 抽取了 851K 計數量詞事實,斷言了 250 萬事實的存在,比這些關係現有的 Wikidata 事實多了 28.3%。

■ 論文解讀 | 譚亦鳴,東南大學博士,研究方向為知識庫問答、自然語言處理

論文動機

作者思考,如果一個人懂多個語言,那麼只要他知道某一語言的某個事實,就能以它作為另一語言問題的答案,同時希望證明計算機是否也能做到這一點,並完成混合語言的簡單問題知識問答任務(Code-Mix Simple Questions KBQA)。

所謂 Code-Mix 即是指 QA 中的問題不是由單一語言構成,以中英雙語舉例: “我怎麼知道本文提出的 model 是否 work 呢?”

方法

作者將提出的 CMQA 模型分為兩個步驟:1)候選生成;2)候選重排序。

候選生成

這裡的候選指的是 KB 中與問題相關的三元組,作者提出的思路是利用檢索樣式,縮小候選三元組的搜尋空間。透過使用 Solr(一個開源的倒排索引查詢系統),將 Freebase 中所有三元組編入索引,而後將 Question 作為檢索的 Query 得到 top-k 個候選三元組,檢索的排序打分參考 BM25。

註意:在這裡檢索僅支援英文,故混合語言問題中其他非英語成分對檢索沒有貢獻,那麼如果問題的 entity 是非英語的話,是否可能引入大量與問題無關的三元組呢。

候選重排序

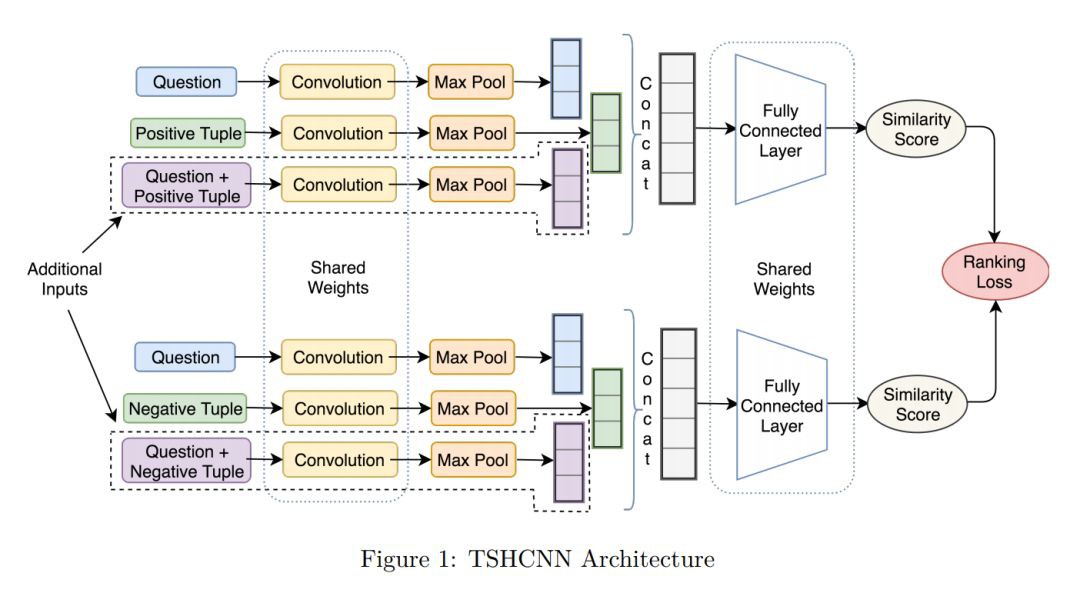

本文的主要工作就是設計了一個重排序模型 Triplet-Siamese-Hybrid CNN (TSHCNN),採用 CNN(摺積網路)學習輸入文字的語意表示。考慮到不同語言的詞序差異性,作者認為 CNN 可以學習到輸入文字中的詞彙順序特徵以及短語順序特徵。

對於排序過程,文章將其抽象為一個多分類問題,即每個答案都是一個潛在類別,且對應的問題數量可能很小甚至為0,這裡主要透過匹配標的物體和謂詞來做答案篩選。直觀思路是透過構建一個問題-答案間的相似度打分作為參照指標用於排序,作者在這裡引入 Siamese Networks 方法完成上述目的。

整體模型框架如圖:

模型由兩個通道組成,分別用於學習正例與負例,每一通道有三個輸入:1)問題;2)正(負)例樣本;3)由正(負)例樣本與問題聯合構成的附加輸入。

網路結構由摺積層->池化層->向量關聯->全連線層 構成,兩個通道中對應位置的網路共享權重引數。

語言轉換

處理多語言問題還是繞不開語意鴻溝,為了將兩種語言關聯起來,作者採用了雙語詞嵌入+K 近鄰組合的策略,構建通用跨語言詞嵌入空間,將雙語詞彙投影到該空間中,再引入 K 近鄰方法構建雙語詞彙關聯。

實驗

資料:SimpleQuestions (Bordes et al., 2015) dataset,75.9k/10.8k/21.7k training/validation/test。

詞嵌入預訓練:English,Hindi Fasttext (Bojanowski et al., 2016),English-Hindi bilingual Smith et al.(2017) to obtain。

自建資料集:Hindi-English混合語言問句,規模:250,簡單問題,每句對應一個 Freebase 三元組。

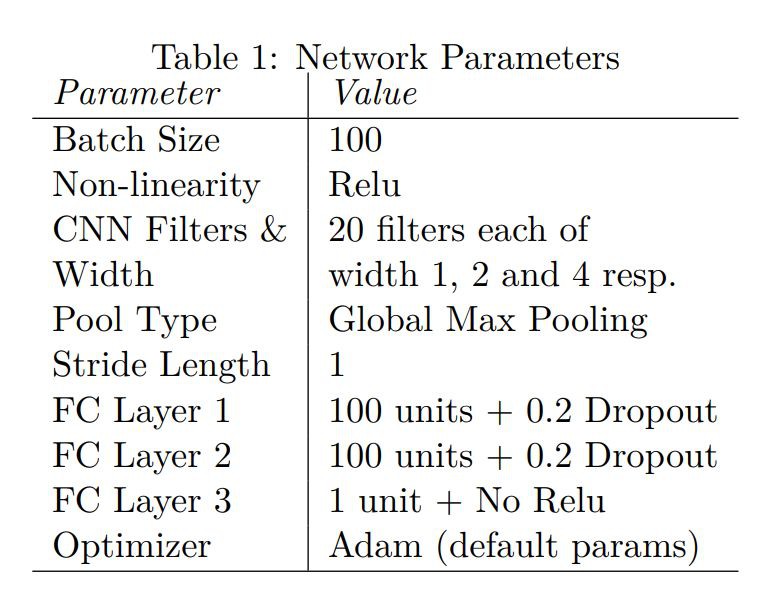

神經網路的超引數設定如圖:

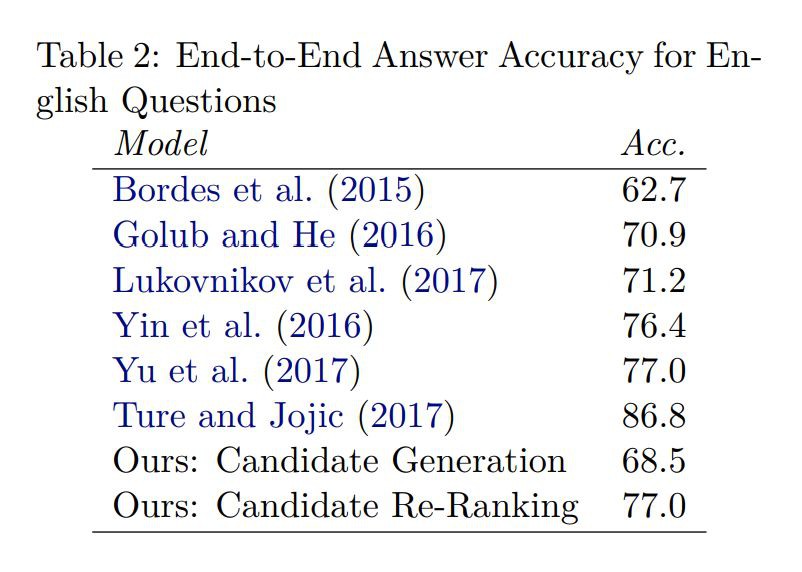

簡單知識問答實驗結果:

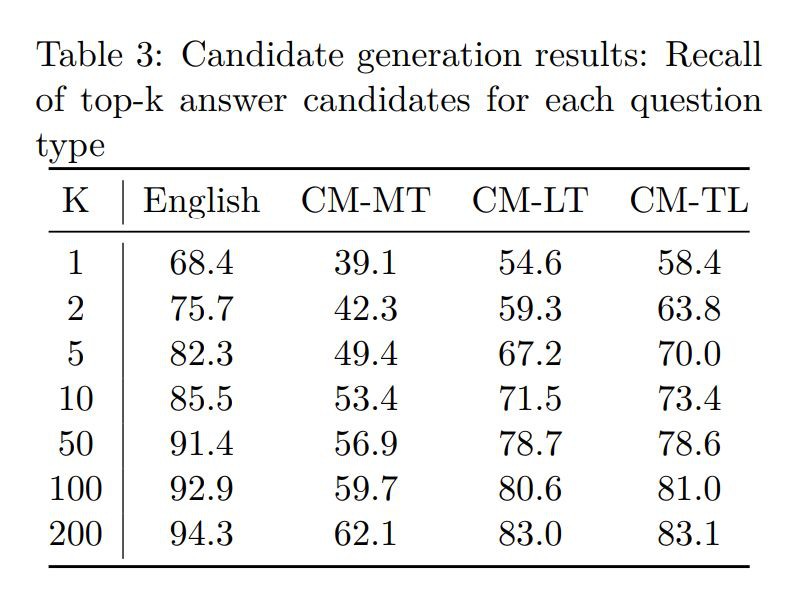

候選三元組生成實驗結果:

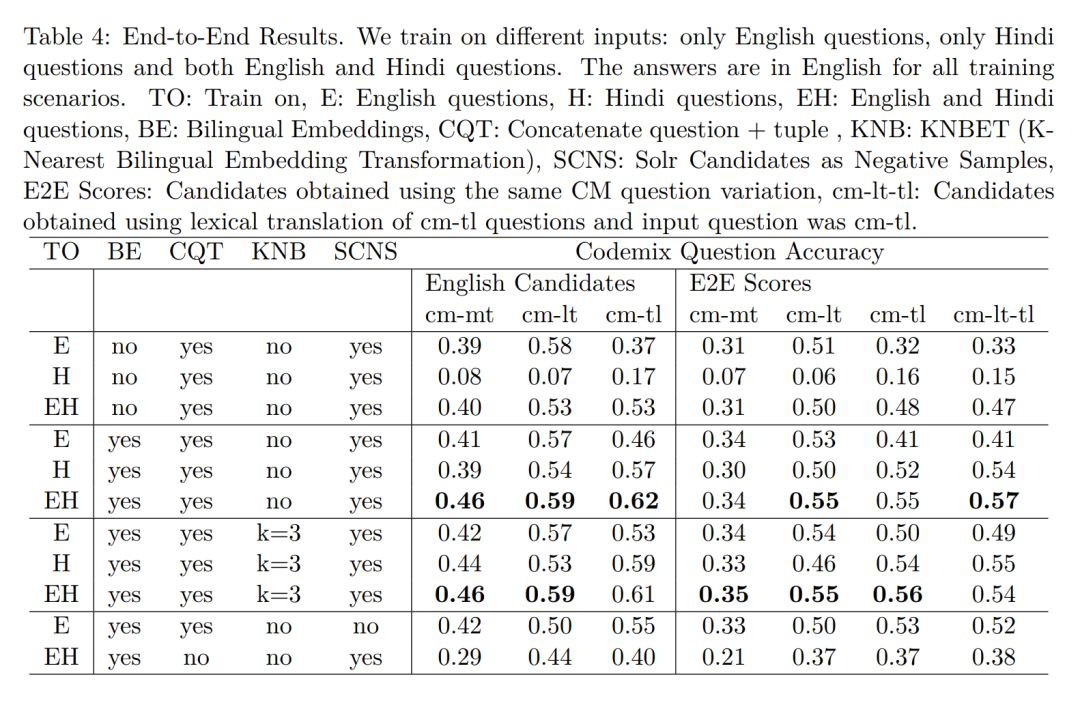

雙語端到端問答實驗結果:

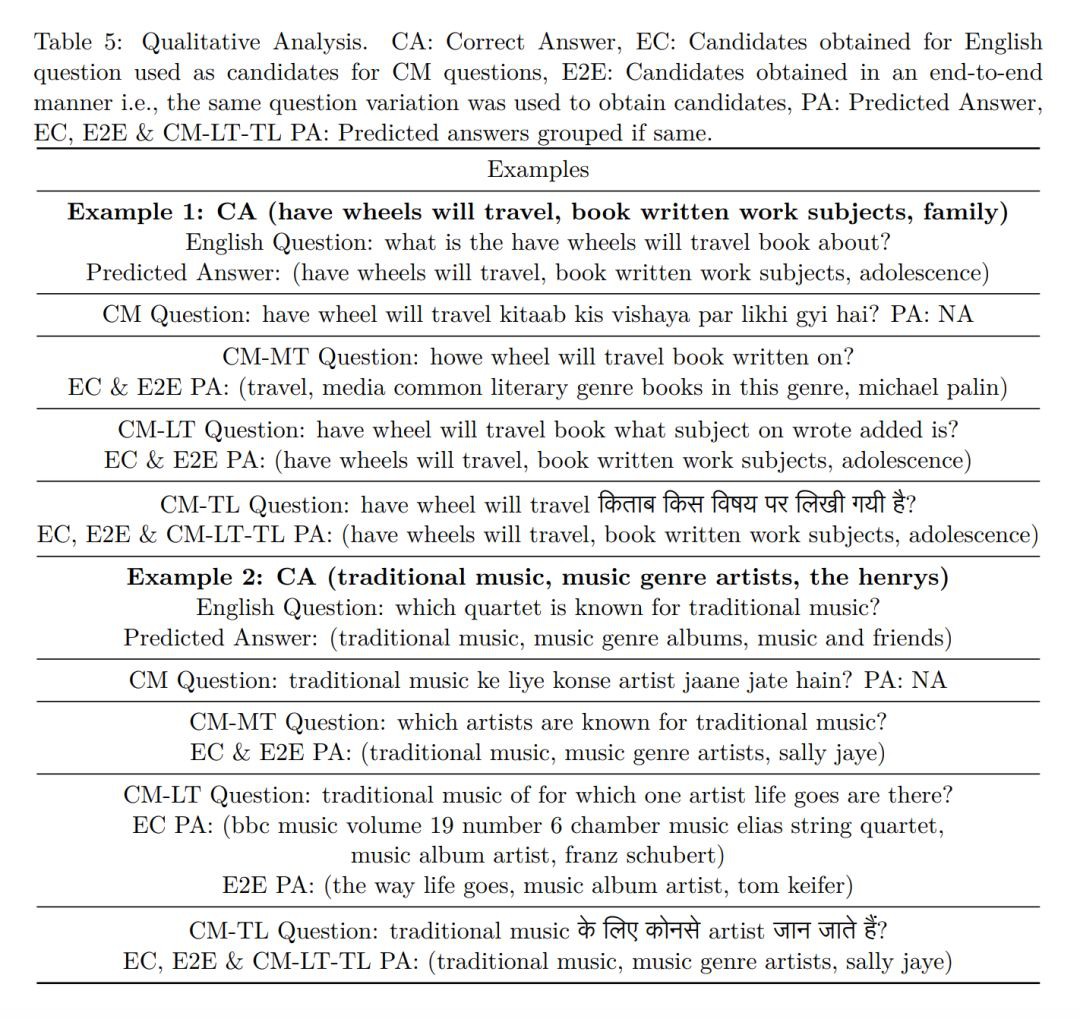

部分問答效果示例:

總結

作者認為本文的貢獻包括:

1. 在基於“英語語料,有噪聲的海地語監督,和不完美的雙語詞嵌入”情況下,成功回答了混合語言問題;

2. 提出 TSHCNN 模型用於聯合學習候選重排序;

3. 構建了一組 250 規模的海地語-英語混合語言問題資料集,並且這個資料集的答案來源於 SimpleQuestion 資料集,且可以對映到 Freebase 知識庫上;

4. 本方法是作者所知目前第一個端到端的混合語言知識問答方法。

■ 解讀 | 李娟,浙江大學直博生,研究方向為表示學習

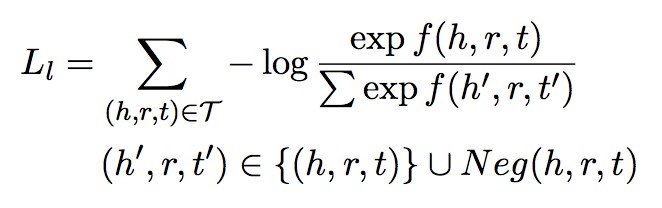

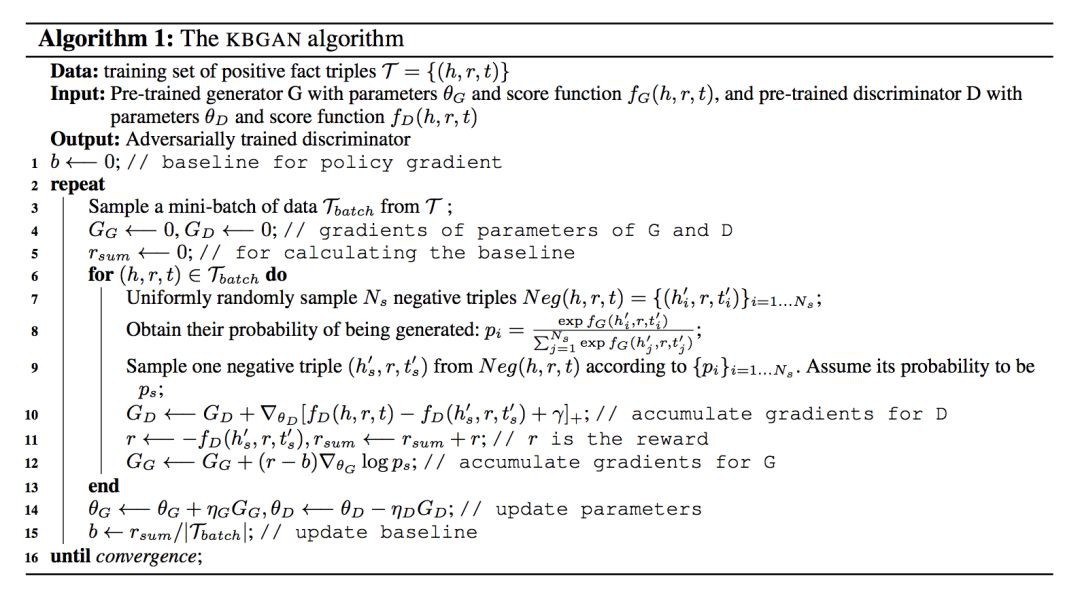

本文針對在生成負樣本時有大部分負樣本可以很好地和正樣本區分開,對訓練的影響不大,提出了使用生成對抗網路(GANs)的方法,解決生成的負樣本不夠好的問題。它是第一個考慮用對抗學習生成負樣本的工作。

方法

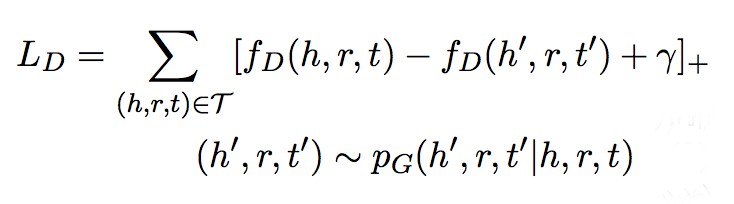

設計模型時,本文把基於機率的 log 損失的表示學習模型作為生成器得到更好的負樣本質量;使用基於距離的邊緣損失的表示學習模型作為判別器得到表示學習的最終結果。

由於生成器的步驟離散導致不能直接運用梯度反向傳播,對此作者使用了一步強化學習設定,使用一個降低方差的強化方法實現這個標的。

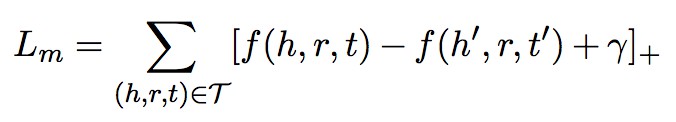

方法上本文先列舉了兩種損失函式:

1. Margin loss function

2. Log-softmax loss function

再透過分析均勻負取樣的缺陷:等機率替換會使容易區分的負樣本對學習的貢獻較小,會讓模型學到一些簡單的特徵,而不是盡可能去理解語意,對此作者認為使用 log 損失函式從替換物體得到的所有負樣本中篩選出更有用的負樣本很有必要。

最後透過模型圖我們發現論文使用 softmax 機率模型為生成器 G,透過機率分佈進行取樣;判別器部分 D 接收生成的負樣本和 ground truth triple 並計算分數;G 透過梯度策略最小化生成的負三元組的分數,D 透過梯度下降最小化正樣本和負樣本的邊緣損失。

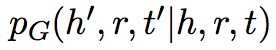

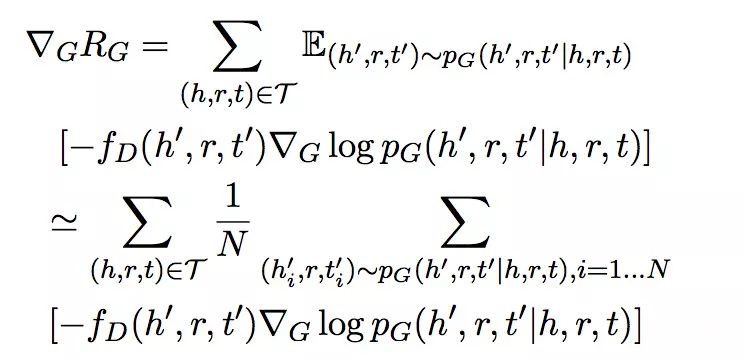

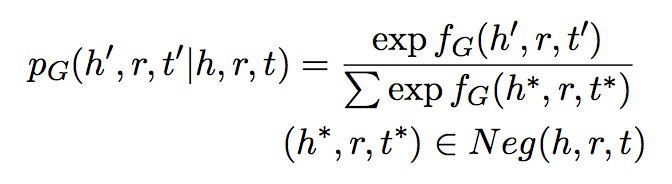

假設生成器得到的負樣本機率分佈為 。

。

那麼判別器的 score function 為:

生成器的標的是最大化負距離的期望為:

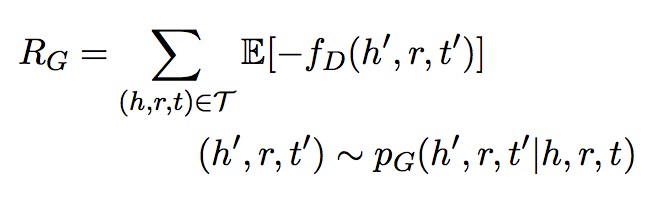

由於 RG 是一個離散取樣步驟得不到梯度,本文借鑒了其他論文提到的梯度策略理論獲取梯度進行最佳化。

這一部分論文把這個過程對標到強化學習,認為生成器是 agent,判別器是 environment, (h, r, t) 是 state,負樣本機率分佈 PG 是 policy,(h’, r, t’) 是 action,-f_D(h’, r, t’) 是 reward,認為是 one-step RL 是在每個 epoch,actions 不會影響 state,但每個 action 後會重新從一個不相關的 state 開始;為減小演演算法方差而不引入新引數,作者從 reward 減掉一個常量。

機率分佈的計算使用以下公式,fG(h, r, t) 為生成器的 score function:

演演算法偽程式碼如下:

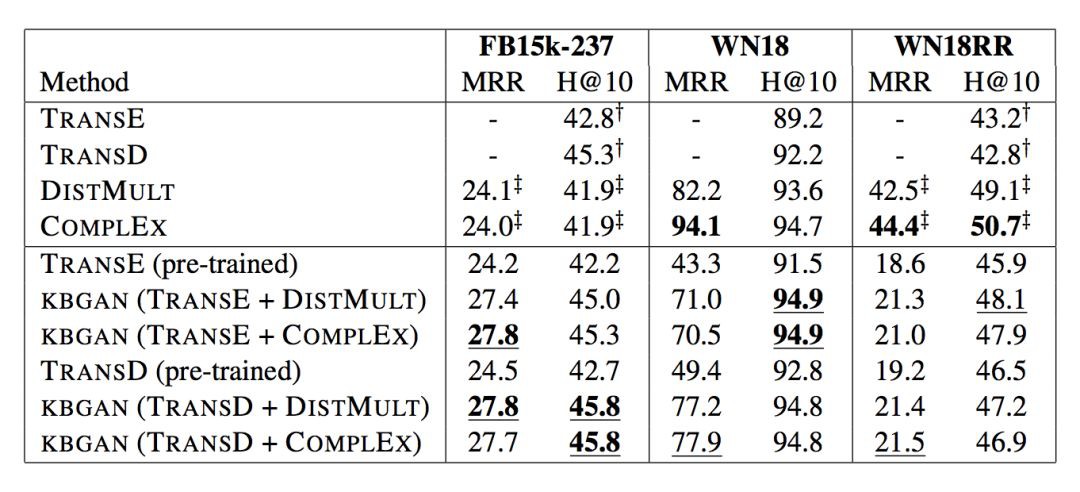

實驗

論文選用的資料集有 FB15K-237, WN18, WN18RR,結果發現使用 DISMULT 或 COMPLEX 作為生成器都不會對效能有較大影響,且 TransD, TransE 在 KBGAN 中很明顯優於它們的 baseline。

■ 論文解讀 | 張清恆,南京大學碩士,研究方向為知識圖譜

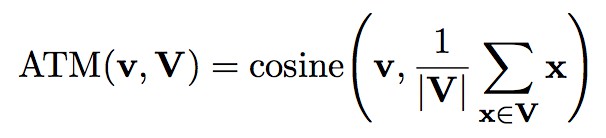

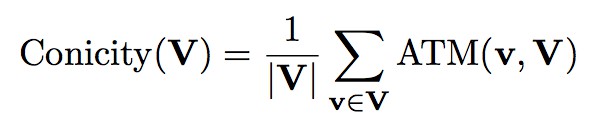

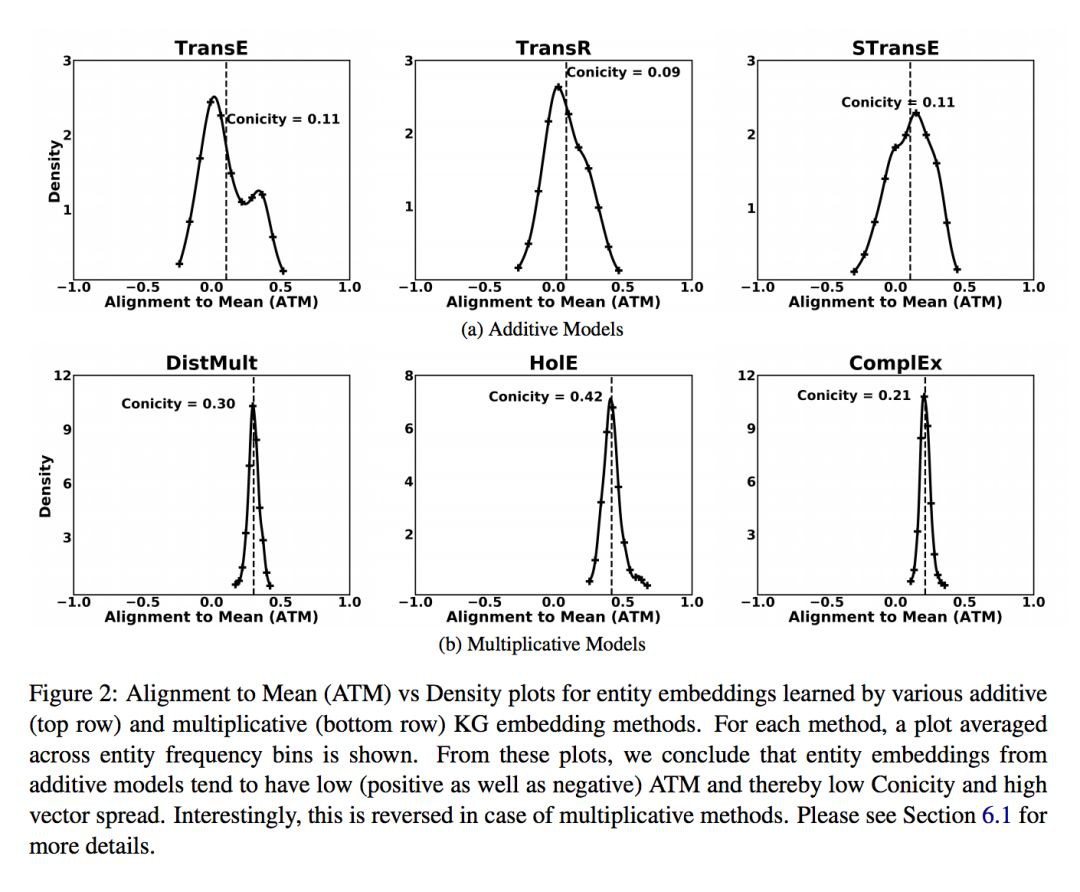

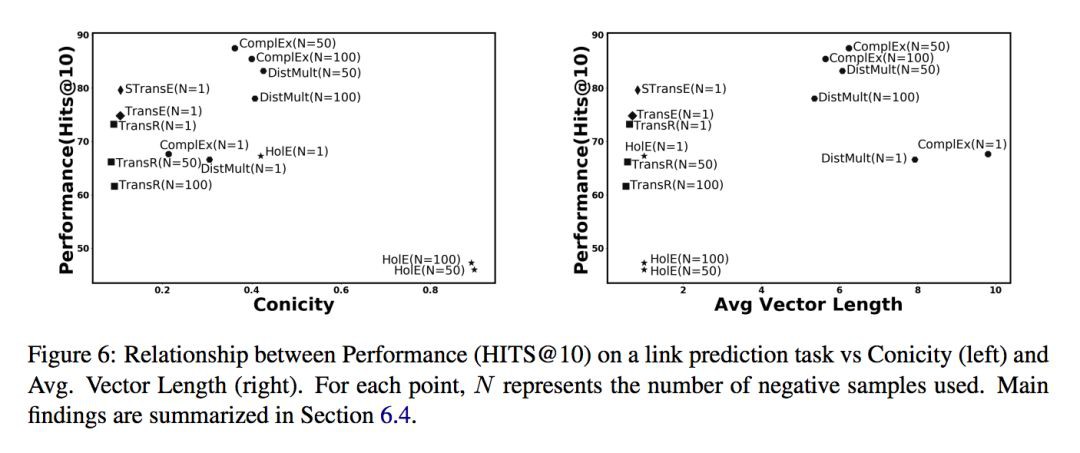

知識圖譜的嵌入表示在近幾年已經成為一個非常活躍的研究領域,眾多相關方法相繼被提出,這些嵌入方法是將知識圖譜中的物體和關係表示成同一向量空間中的向量。雖然知識圖譜的嵌入表示在各種任務中被廣泛應用,但是對嵌入表示的幾何理解尚未被探索,本文旨在填補這項空白。 本文深入分析知識圖譜嵌入表示的幾何形狀,並分析其與任務效能和其他超引數之間的關聯。透過在真實資料集上進行廣泛的實驗,本文發現了一些值得註意的現象,例如不同類別的嵌入方法學習到的嵌入表示在幾何形狀上存在明顯差異。 ATM ATM(alignment to mean)是指向量集合 V 中的一個向量 v 與平均向量的餘弦相似度。 Conicity Conicity 是指向量集合 V 中所有向量 ATM 的平均值。 VS VS(vector spread)是指向量集合 V 中所有向量 ATM 的方差。 圖 1 給出了一個實體來幫助理解這幾個指標,圖中是一個三維坐標系(展示的點是隨機生成的),左圖表示的是高錐度(conicity)和低向量分散度(VS)的情形,而右圖表示的是低錐度和高向量分散度的情形。 AVL AVL(average vector length)是指向量集合 V 中所有向量的平均長度( L2 範數)。

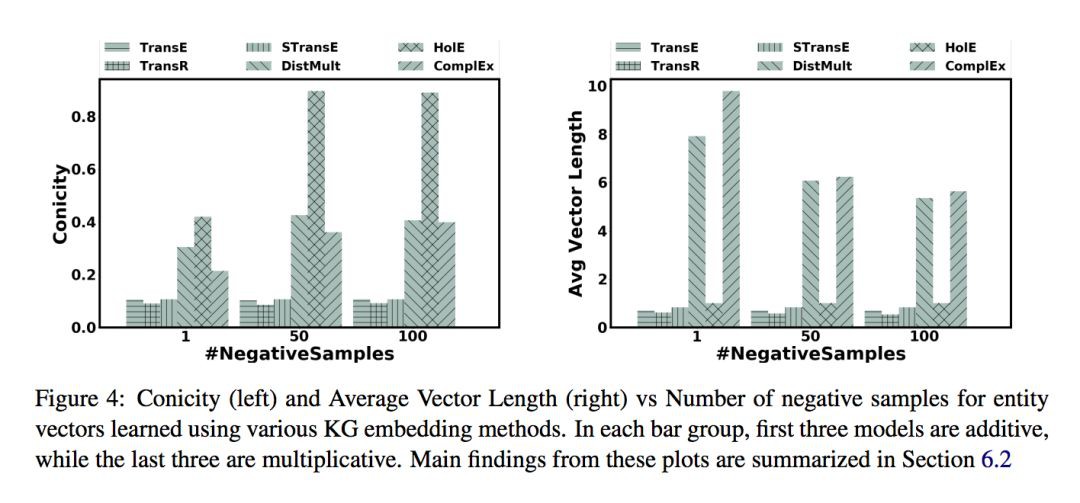

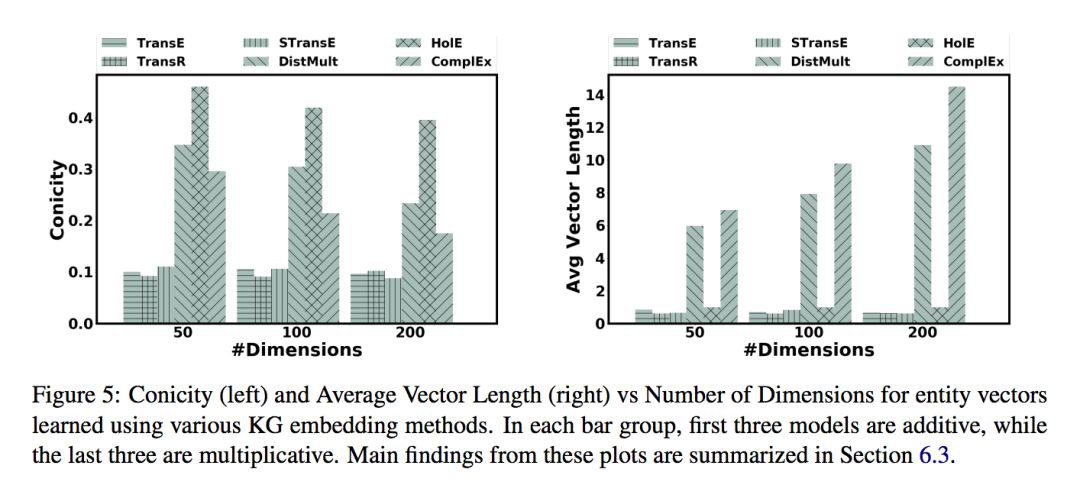

本文主要考慮 6 個知識圖譜的嵌入表示模型,並把 6 個方法分為兩類。一類是加法(additive)模型,有 TransE [2]、TransR [3] 和 STransE [4];另一類是乘法(multiplicative)模型,有 DistMult[5]、HolE[6] 和 ComplEx[7]。同時,本文采用了兩個常見資料集 FB15K 和 WN18。 本文主要從以下 4 個發現展開實驗分析: 1. 模型型別對幾何形狀的影響 不同模型在物體向量的幾何形狀上存在明顯差異。乘法模型的 ATM 值均為正值且向量分散度較低。加法模型此形成鮮明對比,加法模型的 ATM 值正負皆有且分佈較為均衡,同時向量分散度較高。 這說明乘法模型得到的嵌入向量不是均勻的分散在向量空間中,而加法模型得到的嵌入向量則是均勻的分散在向量空間中。 2. 反例數量對幾何形狀的影響 乘法模型的錐度(conicity)隨著反例數量的增加而增大,而加法模型的錐度對反例數量不敏感。在平均向量長度(AVL)方面,乘法模型中的 DistMult 和 ComplEx 隨著反例數量的增加而減小,HolE 則幾乎沒有變化,這是因為 HolE 把物體向量限制在了單位球內。所有加法模型的 AVL 也對反例數量不敏感,而它們也有和 HolE 類似的限制。 3. 向量維數對幾何形狀的影響 隨著向量維數的增加,乘法模型的錐度呈現出下降的趨勢,而平均向量長度則呈現出上升趨勢。加法模型的錐度和平均向量長度則對向量維數不敏感。 4. 幾何形狀與效能的聯絡 本實驗以連結預測任務為例,採用與 TransE 相同的實驗設定。當反例數量相同時,錐度小的乘法模型的效能更優;當反例數量增加時,乘法模型表現更好。加法模型的效能與錐度並無太大關係。 在平均向量長度方面,對於除 HolE 之外的乘法模型而言,當反例數量一定時,平均向量長度越大效能越好;而對於加法模型和 HolE 而言,平均向量長度與效能的關係並不顯著,這個現象是由於這些方法使用單位向量長度來限制嵌入向量所導致的。

[1] Chandrahas, Aditya Sharma, Partha Talukdar: Towards Understanding the Geometry of Knowledge Graph Embeddings. ACL 2018: 122-131. [2] Antoine Bordes, Nicolas Usunier, Alberto Garciaduran, Jason Weston, Oksana Yakhnenko: Translating Embeddings for Modeling Multi-relational Data. NIPS 2013: 2787-2795. [3] Yankai Lin, Zhiyuan Liu, Maosong Sun, Yang Liu, Xuan Zhu: Learning entity and relation embeddings for knowledge graph completion. AAAI 2015: 2181-2187. [4] Dat Quoc Nguyen, Kairit Sirts, Lizhen Qu, Mark Johnson: STransE: anovel embedding model of entities and relationships in knowledge bases.NAACL-HLT 2016: 460-466. [5] Bishan Yang, Wentau Yih, Xiaodong He, Jianfeng Gao, Li Deng: Embedding Entities and Relations for Learning and Inference in Knowledge Bases. ICLR2015. [6] Maximilian Nickel, Lorenzo Rosasco, Tomaso Poggio: Holographic embeddings of knowledge graphs. AAAI 2016: 1955-1961. [7] Theo Trouillon, Johannes Welbl, Sebastian Riedel, Eric Gaussier, Guillaume Bouchard: Complex embeddings for simple link prediction. ICML 2016: 2071-2080.

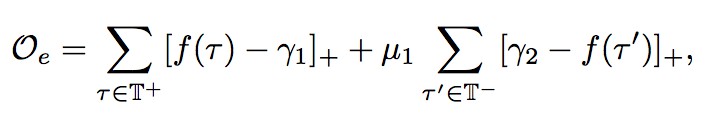

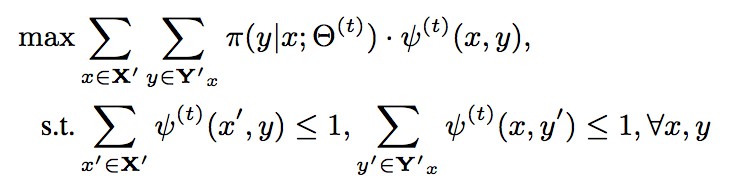

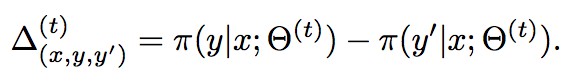

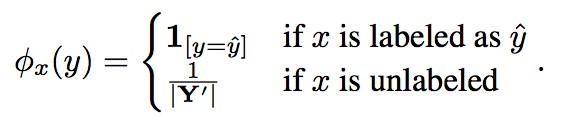

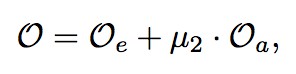

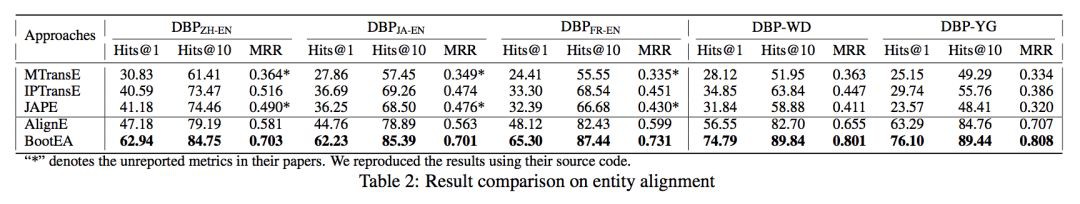

■ 論文解讀 | 譚亦鳴,東南大學博士,研究方向為知識庫問答、自然語言處理 本文關註基於知識圖譜嵌入(後文全部簡稱為知識嵌入)的物體對齊工作,針對知識嵌入訓練資料有限這一情況,作者提出一種 Bootstrapping 策略,迭代標註出可能的物體對齊,生成新資料加入知識嵌入模型的訓練中。 但是,當模型生產了錯誤的物體對齊時,這種錯誤將會隨著迭代次數的增加而累積的越來越多。為了控制錯誤累積,作者設計了一種對齊樣本編輯方法,對每次迭代生成的對齊資料加以約束。 目前面向知識庫的物體對齊研究中,基於知識嵌入的方法取得了比傳統策略更好的實驗效果。但是對於知識嵌入的物體對齊,仍然存在著一些挑戰。 其一:雖然近年單知識庫知識嵌入研究成果頗豐,但面向知識對齊的嵌入工作仍有很多待研究的空間。 其二:基於知識嵌入的物體對齊往往依賴已有對齊作為訓練資料,雖然有研究表示僅需少量對齊樣本即可完成模型訓練 [Chen et al. 2017],但有限的訓練資料依然會影響知識嵌入的質量以及物體對齊準確性。 對齊引導的知識嵌入 作者將物體對齊視為分類問題,標的就是從基於知識嵌入的物體表示中(包括有標註對齊物體,及無標註物體),找到最有可能的物體對齊(最大對齊似然)。 對於知識嵌入,在 translation-based 的基礎上,針對對齊問題,作者對標的函式做出如下改進: 由基本知識嵌入標的函式 其中 [f(x)]+表示 max(f(x), 0),γ1, γ2>0 是兩個超參,μ1 是個平衡引數,這裡使用的負例透過隨機替換正例中的部分得到。 Bootstrpping物體對齊方法 本方法的目的是最大化對齊似然,並符合 1 對 1 的對齊約束,在這種設定下,對於一組物體對齊 (x, y),y 被視為是 x 的標簽(我個人是這樣理解的)。故該問題建模為以下形式: 其中 考慮到新生成的對齊樣本可能引起矛盾,這裡作者使用的策略是對比出現矛盾的對齊物體,取對齊似然更高的樣本保留,計算形式為: 結果大於 0 時保留 (x, y) ,反之選擇 (x, y’ )。 利用全域性資訊 這裡的全域性資訊指全部物體樣本存在對齊(有標註)的機率分佈情況,作者將其定義為以下表示: 以此為基礎,作者構建了一個負對數似然函式,用於強化原始樣本中對齊物體對知識嵌入的最佳化。 新增全域性資訊函式後,整體標的函式擴充為以下形式:

作者列出了自己的實驗配置,並開原始碼供讀者研究使用。 資料方面使用 DBP15K 和 DWY100K 兩個資料集。 最後,綜合實驗結果看來,這確實是目前最好的對齊模型。

論文動機

度量標準

實驗分析

參考文獻

論文動機

方法

引入正負例樣本集T+與T-,將標的函式改寫為:

引入正負例樣本集T+與T-,將標的函式改寫為:

![]() 表示第 t 次迭代得到的物體嵌入,Y’ 表示對於 x 存在的候選對齊樣本集合。

表示第 t 次迭代得到的物體嵌入,Y’ 表示對於 x 存在的候選對齊樣本集合。![]() 是一個標記函式,當 (x, y) 構成一組對齊的時候其函式值為 1,否則為 0。當得到新的對齊物體時,將其作為增量新增到訓練集中用於下一次迭代。

是一個標記函式,當 (x, y) 構成一組對齊的時候其函式值為 1,否則為 0。當得到新的對齊物體時,將其作為增量新增到訓練集中用於下一次迭代。

實驗

知識星球

知識星球