小編邀請您,先思考:

1 隨機森林演演算法的原理?

2 隨機森林演演算法的應用?

前言: 隨機森林是一個非常靈活的機器學習方法,從市場營銷到醫療保險有著眾多的應用。它可以用於市場營銷對客戶獲取和存留建模或預測病人的疾病風險和易感性。

隨機森林能夠用於分類和回歸問題,可以處理大量特徵,並能夠幫助估計用於建模資料變數的重要性。

這篇文章是關於如何使用Python構建隨機森林模型。

什麼是隨機森林

隨機森林可以用於幾乎任何一種預測問題(包括非線性問題)。它是一個相對較新的機器學習策略(90年代誕生於貝爾實驗室)可以用在任何方面。它屬於機器學習中的整合學習這一大類。

1.1 整合學習

整合學習是將多個模型進行組合來解決單一的預測問題。它的原理是生成多個分類器模型,各自獨立地學習並作出預測。這些預測最後結合起來得到預測結果,因此和單獨分類器的結果相比,結果一樣或更好。

隨機森林是整合學習的一個分支,因為它依靠於決策樹的整合。更多關於python實現整合學習的檔案: Scikit-Learn 檔案。

1.2 隨機決策樹

我們知道隨機森林是將其他的模型進行聚合, 但具體是哪種模型呢?從其名稱也可以看出,隨機森林聚合的是分類(或回歸) 樹。一顆決策樹是由一系列的決策組合而成的,可用於資料集的觀測值進行分類 。

1.3 隨機森林

引入的隨機森林演演算法將自動建立隨機決策樹群。由於這些樹是隨機生成的,大部分的樹(甚至 99.9%)對解決你的分類或回歸問題是沒有有意義。

1.4 投票

那麼,生成甚至上萬的糟糕的模型有什麼好處呢?好吧,這確實沒有。但有用的是,少數非常好的決策樹也隨之一起生成了。

當你要做預測的時候,新的觀察值隨著決策樹自上而下走下來並被賦予一個預測值或標簽。一旦森林中的每棵樹都給有了預測值或標簽,所有的預測結果將被歸總到一起,所有樹的投票傳回做為最終的預測結果。

簡單來說,99.9%不相關的樹做出的預測結果涵蓋所有的情況,這些預測結果將會彼此抵消。少數優秀的樹的預測結果將會脫穎而出,從而得到一個好的預測結果。

隨機森林是機器學習方法中的Leatherman(多功能摺疊刀)。你幾乎可以把任何東西扔給它。它在估計推斷對映方面做的特別好,從而不需要類似SVM醫一樣過多的調參(這點對時間緊迫的朋友非常好)。

2.1 一個對映的例子

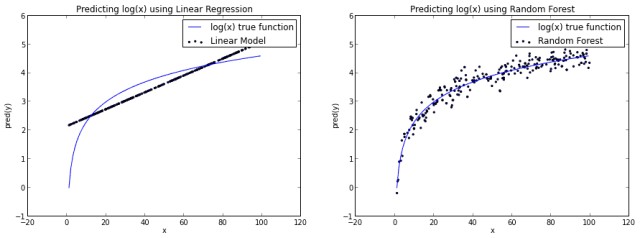

隨機森林可以在未經特意手工進行資料變換的情況下學習。以函式f(x)=log(x)為例。

我們將在Yhat自己的互動環境Rodeo中利用Python生成分析資料,你可以在here下載Rodeo的Mac,Windows和Linux的安裝檔案。

首先,我們先生成一下資料並新增噪聲。

import numpy as np

import pylab as pl

x = np.random.uniform(1, 100, 1000)

y = np.log(x) + np.random.normal(0, .3, 1000)

pl.scatter(x, y, s=1, label="log(x) with noise")

pl.plot(np.arange(1, 100), np.log(np.arange(1, 100)), c="b", label="log(x) true function")

pl.xlabel("x")

pl.ylabel("f(x) = log(x)")

pl.legend(loc="best")

pl.title("A Basic Log Function")

pl.show()得到如下結果:

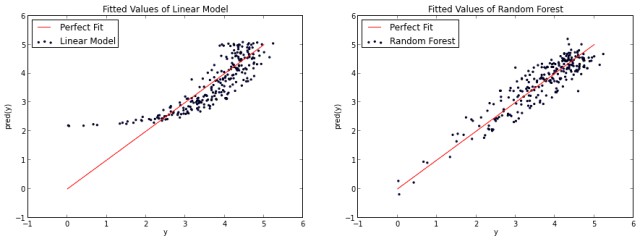

如果我們建立了一個基本的線性模型透過使用x來預測y,我們需要作一條直線,一定成都市算是平分log(x)函式。而如果我們使用隨機森林演演算法,它可以更好的逼近log(x)曲線從而使得它看起來更像實際的函式。

當然,你也可以說隨機森林對log(x)函式有點過擬合。不管怎麼樣,這說明瞭隨機森林並不限於線性問題。

使用方法

3.1 特徵選擇

隨機森林的一個最好用例是特徵選擇。嘗試很多個決策樹變數的一個副產品就是,你可以檢查變數在每棵樹中表現的是最佳還是最糟糕。

當一些樹使用一個變數,而其他的不使用這個變數,你就可以對比資訊的丟失或增加。實現的比較好的隨機森林工具能夠為你做這些事情,所以你需要做的僅僅是去檢視那個方法或引數。

在下述的例子中,我們嘗試弄明白區分紅酒或白酒時,哪些變數是最重要的。

3.2 分類

隨機森林也很善長分類問題。它可以被用於為多個可能標的類別做預測,它也可以在調整後輸出機率。你需要註意的一件事情是過擬合。

隨機森林容易產生過擬合,特別是在資料集相對小的時候。當你的模型對於測試集合做出“太好”的預測的時候就應該懷疑一下了。避免過擬合的一個方法是在模型中只使用有相關性的特徵,比如使用之前提到的特徵選擇。

3.3 回歸

隨機森林也可以用於回歸問題。

我發現,不像其他的方法,隨機森林非常擅長於分類變數或分類變數與連續變數混合的情況。

一個簡單的Python示

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

import pandas as pd

import numpy as np

iris = load_iris()

df = pd.DataFrame(iris.data, columns=iris.feature_names)

df['is_train'] = np.random.uniform(0, 1, len(df)) <= .75 df['species'] = pd.Categorical.from_codes(iris.target, iris.target_names)

df.head()

train, test = df[df['is_train']==True], df[df['is_train']==False]

features = df.columns[:4]

clf = RandomForestClassifier(n_jobs=2)y, _ = pd.factorize(train['species'])

clf.fit(train[features], y)

preds = iris.target_names[clf.predict(test[features])]

pd.crosstab(test['species'], preds, rownames=['actual'], colnames=['preds'])下麵就是你應該看到的結果了。由於我們隨機選擇資料,所以實際結果每次都會不一樣。

結語

隨機森林相當起來非常容易。不過和其他任何建模方法一樣要註意過擬合問題。如果你有興趣用R語言使用隨機森林,可以檢視randomForest包。

來源: 時空Drei

segmentfault.com/a/1190000007463203

親愛的讀者朋友們,您們有什麼想法,請點選【寫留言】按鈕,寫下您的留言。

資料人網(http://shujuren.org)誠邀各位資料人來平臺分享和傳播優質資料知識。

公眾號推薦:

好又樂書屋,專註分享有思想的人物,身心健康,自我教育,閱讀寫作和有趣味的生活等內容,傳播正能量。

閱讀原文,更多精彩!

分享是收穫,傳播是價值!

知識星球

知識星球