近年來,Python已成為資料科學家的主要工具之一。本文概述了資料科學家及工程師們最常用的Python庫。

Numerical Python的簡稱,包含Python多維陣列及矩陣操作方面的大量實用功能,用於向量化陣列運算,顯著提高了執行速度,改善了效能。

科學及工程軟體庫,包含線性代數、最佳化、整合、統計等功能。它的主要功能基於Numpy庫,因此其中陣列操作大量應用了Numpy庫。

包含Series及DataFrame兩種特殊的資料結構,用於快捷的資料處理、聚合和視覺化,尤其可以靈活處理缺失資料及資料分組。

Python中最常用的視覺化庫,由此可與MatLab、Mathematica等科學工具相提並論。它可以進行多種基本圖形的視覺化操作,並且包含標簽、網格、圖例等多種進行物體格式化的工具。

Seaborn主要用於統計模型的視覺化,比如熱力圖等,可以對資料進行概述的同時描繪整體分佈。Seaborn基於Matplotlib實現,並高度依賴於後者。

Bokeh庫旨在進行互動式視覺化,並且不依賴於Matplotlib,主要透過瀏覽器以“資料驅動檔案”(Data-Driven Documents,d3.js)的形式演示。

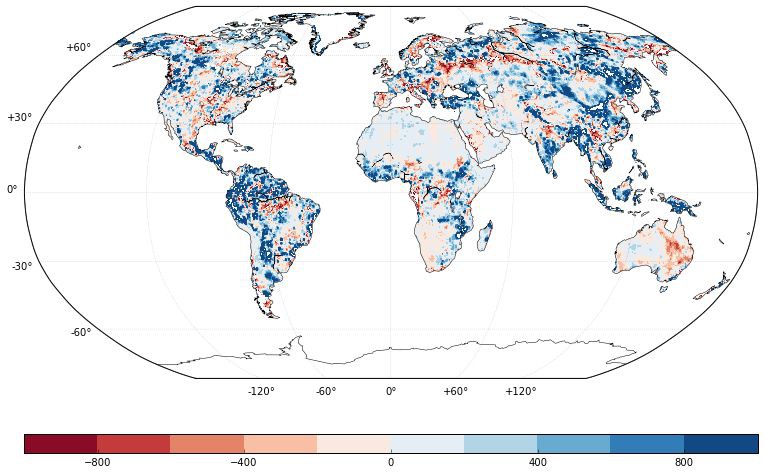

Basemap庫透過使用Matplotlib中的坐標,為Matplotlib提供了簡易地圖的支援。Folium庫在Basemap的基礎上構建,可以製作互動式的Web地圖,這類似於使用Bokeh建立的JavaScript小部件。

Poltly庫是一個基於Web、用於資料視覺化的工具集,透過一系列API介面用於Python等程式語言的實現。plot.ly網站上展示了許多強大的圖形。

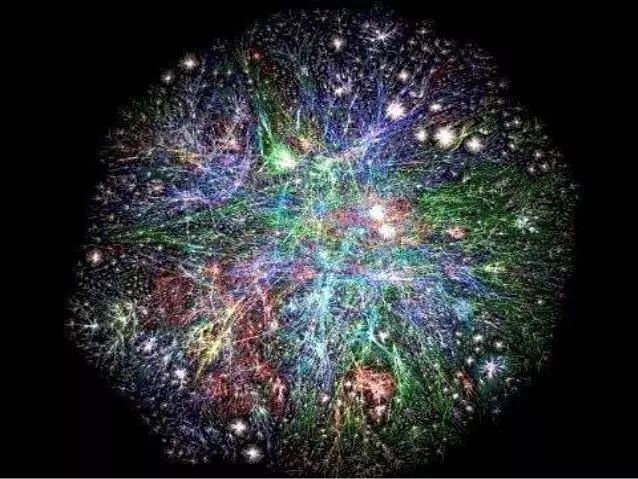

NetworkX庫用於複雜社會網路的分析。它可以處理標準資料格式及非標準資料格式,這使其具備高效性和可擴充套件性。

SciKit-Learn為常見的機器學習演演算法提供了簡潔而一致的介面,使得機器學習更容易應用於生產系統。它結合了高質量的程式碼和應用檔案,具備易用性和高效能,事實上已成為使用Python進行機器學習的行業標準。

TensorFlow庫由谷歌工作人員開發,是一個資料流圖計算的開源庫,在機器學習方面的應用表現優越。主要特點是多層節點系統,可以在大型資料集上快速訓練人工神經網路。這使得谷歌的語音識別和影象識別成為可能。

Theano庫主要用於機器學習的需要,它定義了類似於Numpy的多維陣列,以及資料操作和表達,在低階別操作上與Numpy結合緊密。Theano庫經過了編譯,優化了GPU和CPU的使用,在資料密集型計算方面效能更高,結果也更精確。

Keras庫是用Python編寫、用於高階介面中神經網路構建的開源庫,具有可擴充套件性和高度模組化。它使用Theano或TensorFlow作為後端,目前微軟正努力將CNTK(微軟的認知工具包)作為新的後端。它設計簡約,旨在透過構建緊湊型系統進行快速簡單的實驗。它的基本思想是基於層次的,其他一切都是圍繞它們建立的。資料準備為張量形式,第一層負責張量輸入,最後一層負責輸出,模型置於兩者之間。

Natural Language Toolkit的簡稱,用於符號和統計自然語言處理等一般任務。NLTK包括許多功能,比如文字標記、分類、名稱物體標識、建立顯示句子間及句子間依賴性的語料樹、詞乾、語意推理等。所有的構建塊允許為不同的任務構建複雜的研究系統,比如情感分析、自動彙總等。

Gensim是一個Python的開源庫,為更高效地處理大文字資料而設計,實現了向量空間建模和主題建模。Gensim主要用於原始的、非結構化的數字文字處理,實現了層次Dirichlet過程(HDP)、潛在語意分析(LSA)、隱含Dirichlet分佈(LDA)以及tf-idf、隨機投影、word2vec、document2vec等演演算法,以分析語料集中重覆文字出現的樣式。所有演演算法都是無監督的,只需要輸入語料庫。

Scrapy是用於製作抓取程式的庫,也被稱為蜘蛛機器人,可用於網路中檢索結構化資料,比如關聯資訊或URL。它的介面設計遵循著名的“不要重覆自己”原則——它提示使用者編寫可重用的通用程式碼,以便構建和擴充套件大型爬蟲。Scrapy的結構圍繞Spider類構建,其內部封裝了爬蟲所遵循的指令集。

Pattern庫將Scrapy庫和NLTK庫的功能結合在一個大型庫中,被設計為用於Web挖掘、自然語言處理、機器學習和網路分析的解決方案。其內部工具有網路爬蟲;用於谷歌、推特和維基百科的API;解析樹、情感分析等文字分析演演算法。

Statsmodels庫主要用於統計分析,透過應用統計模型估計方法進行資料探索,併進行推斷分析。它使用的模型包括線性回歸模型、廣義線性模型、離散選擇模型、時間序列分析模型等,還提供了大量統計分析方面的繪圖功能。

END

參考文獻:

-

https://activewizards.com/blog/top-15-libraries-for-data-science-in-python/

-

https://www.datasciencelearner.com/machine-learning-library-python/

-

https://www.business2community.com/brandviews/upwork/15-python-libraries-data-science-01584664

註:圖片源於網路。

END

版權宣告:本號內容部分來自網際網路,轉載請註明原文連結和作者,如有侵權或出處有誤請和我們聯絡。

關聯閱讀:

原創系列文章:

資料運營 關聯文章閱讀:

資料分析、資料產品 關聯文章閱讀:

知識星球

知識星球