導讀:近日,美國對中興發起一張長達七年的禁令,在這期間,美國公司將禁止向中興出售任何元器件。有分析認為,美國禁令直擊中國軟肋,簡直扎“芯”。那麼在AI領域,國內外晶片的現狀如何?

如果說2016年3月份AlphaGo與李世石的那場人機大戰只在科技界和圍棋界產生較大影響的話,那麼2017年5月其與排名第一的世界圍棋冠軍柯潔的對戰則將人工智慧技術推向了公眾視野。阿爾法狗(AlphaGo)是第一個擊敗人類職業圍棋選手、第一個戰勝圍棋世界冠軍的人工智慧程式,由谷歌(Google)旗下DeepMind公司戴密斯·哈薩比斯領銜的團隊開發,其主要工作原理是“深度學習”。

其實早在2012年,深度學習技術就已經在學術界引起了廣泛地討論。在這一年的ImageNet大規模視覺識別挑戰賽ILSVRC中,採用5個摺積層和3個全連線層的神經網路結構AlexNet,取得了top-5(15.3%)的歷史最佳錯誤率,而第二名的成績僅為26.2%。從此以後,就出現了層數更多、結構更為複雜的神經網路結構,如ResNet、GoogleNet、VGGNet和MaskRCNN等,還有去年比較火的生成式對抗網路GAN。

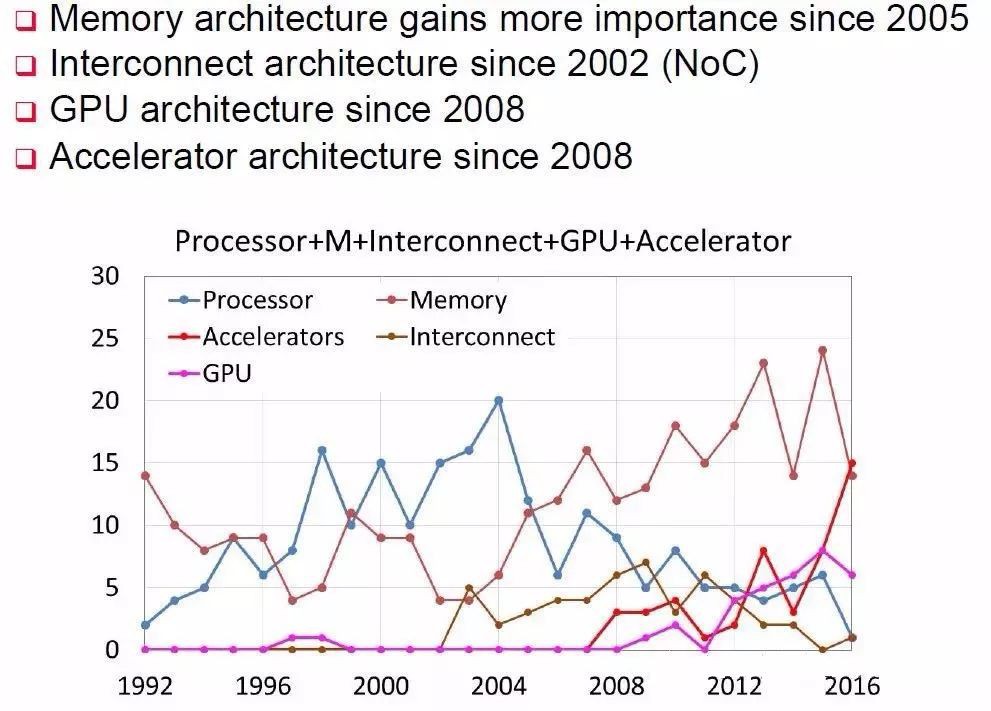

不論是贏得視覺識別挑戰賽的AlexNet,還是擊敗圍棋冠軍柯潔的AlphaGo,它們的實現都離不開現代資訊科技的核心——處理器,不論這個處理器是傳統的CPU,還是GPU,還是新興的專用加速部件NNPU(NNPU是Neural Network Processing Unit的簡稱)。在計算機體系結構國際頂級會議ISCA2016上有個關於體系結構2030的小型研討會,名人堂成員UCSB的謝源教授就對1991年以來在ISCA收錄的論文進行了總結,專用加速部件相關的論文收錄是在2008年開始,而在2016年達到了頂峰,超過了處理器、儲存器以及互聯結構等三大傳統領域。而在這一年,來自中國科學院計算技術研究所的陳雲霽、陳天石研究員課題組提交的《一種神經網路指令集》論文,更是ISCA2016最高得分論文。

在具體介紹AI晶片國內外之前,看到這裡有部分讀者或許會產生這樣的疑惑:這不都是在說神經網路和深度學習嗎?那麼我覺得有必要對人工智慧和神經網路的概念進行闡述,特別是2017年工信部釋出的《促進新一代人工智慧產業發展三年行動計劃(2018-2020年)》中,對發展標的的描述很容易讓人覺得人工智慧就是神經網路,AI晶片就是神經網路晶片。

人工智慧整體核心基礎能力顯著增強,智慧感測器技術產品實現突破,設計、代工、封測技術達到國際水平,神經網路晶片實現量產併在重點領域實現規模化應用,開源開發平臺初步具備支撐產業快速發展的能力。

其實則不然。人工智慧是一個很老很老的概念,而神經網路只不過是人工智慧範疇的一個子集。早在1956年,被譽為“人工智慧之父”的圖靈獎得主約翰·麥卡錫就這樣定義人工智慧:創造智慧機器的科學與工程。而在1959年,Arthur Samuel給出了人工智慧的一個子領域機器學習的定義,即“計算機有能力去學習,而不是透過預先準確實現的程式碼”,這也是目前公認的對機器學習最早最準確的定義。而我們日常所熟知的神經網路、深度學習等都屬於機器學習的範疇,都是受大腦機理啟發而發展得來的。另外一個比較重要的研究領域就是脈衝神經網路,國內具有代表的單位和企業是清華大學類腦計算研究中心和上海西井科技等。

好了,現在終於可以介紹AI晶片國內外的發展現狀了,當然這些都是我個人的一點觀察和愚見,管窺之見權當拋磚引玉。

01 國外 | 技術寡頭,優勢明顯

由於具有得天獨厚的技術和應用優勢,英偉達和谷歌幾乎佔據了人工智慧處理領域80%的市場份額,而且在谷歌宣佈其Cloud TPU開放服務和英偉達推出自動駕駛處理器Xavier之後,這一份額佔比在2018年有望進一步擴大。其他廠商,如英特爾、特斯拉、ARM、IBM以及Cadence等,也在人工智慧處理器領域佔有一席之地。

當然,上述這些公司的專註領域卻不盡相同。比如英偉達主要專註於GPU和無人駕駛領域,而谷歌則主要針對雲端市場,英特爾則主要面向計算機視覺,Cadence則以提供加速神經網路計算相關IP為主。如果說前述這些公司還主要偏向處理器設計等硬體領域,那麼ARM公司則主要偏向軟體,致力於針對機器學習和人工智慧提供高效演演算法庫。

▲註:上述表格中所給為截止到2017年各研製單位公開可查的最新資料

1. 獨佔鰲頭——英偉達

在人工智慧領域,英偉達可以說是目前涉及面最廣、市場份額最大的公司,旗下產品線遍佈自動駕駛汽車、高效能運算、機器人、醫療保健、雲端計算、遊戲影片等眾多領域。其針對自動駕駛汽車領域的全新人工智慧超級計算機Xavier,用NVIDIA執行長黃仁勛的話來說就是“這是我所知道的 SoC 領域非常了不起的嘗試,我們長期以來一直致力於開發晶片。”

Xavier 是一款完整的片上系統 (SoC),集成了被稱為 Volta 的全新 GPU 架構、定製 8 核 CPU 架構以及新的計算機視覺加速器。該處理器提供 20 TOPS(萬億次運算/秒)的高效能,而功耗僅為 20 瓦。單個 Xavier 人工智慧處理器包含 70 億個電晶體,採用最前沿的 16nm FinFET 加工技術進行製造,能夠取代目前配置了兩個移動 SoC 和兩個獨立 GPU 的 DRIVE PX 2,而功耗僅僅是它的一小部分。

而在2018年拉斯維加斯CES展會上,NVIDIA又推出了三款基於Xavier的人工智慧處理器,包括一款專註於將增強現實(AR)技術應用於汽車的產品、一款進一步簡化車內人工智慧助手構建和部署的DRIVE IX和一款對其現有自主出租車大腦——Pegasus的修改,進一步擴大自己的優勢。

2. 產學研的集大成者——谷歌

如果你只是知道谷歌的AlphaGo、無人駕駛和TPU等這些人工智慧相關的產品,那麼你還應該知道這些產品背後的技術大牛們:谷歌傳奇晶片工程師Jeff Dean、谷歌雲端計算團隊首席科學家、斯坦福大學AI實驗室主管李飛飛、Alphabet董事長John Hennessy和谷歌傑出工程師David Patterson。

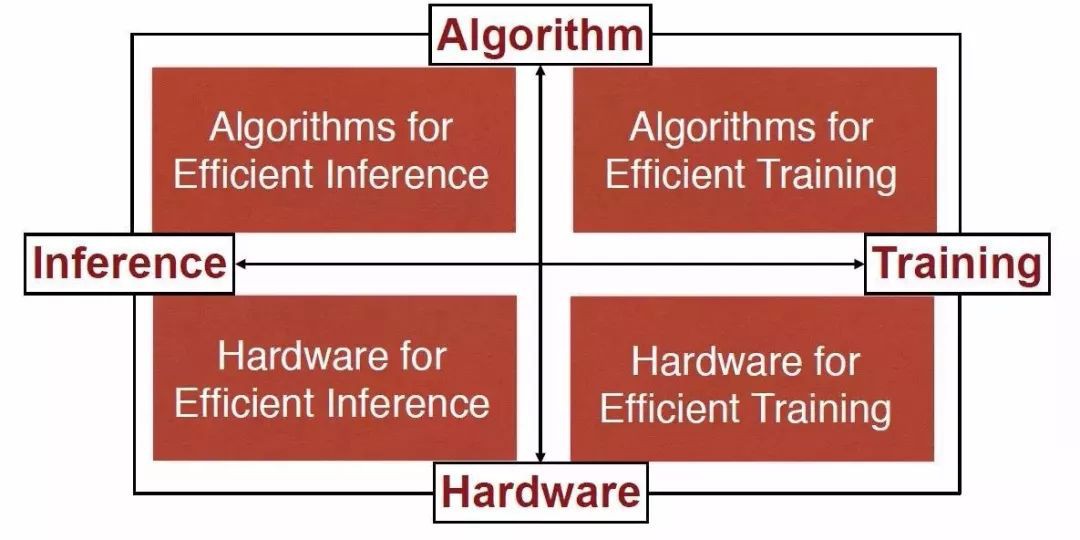

時至今日,摩爾定律遇到了技術和經濟上的雙重瓶頸,處理器效能的增長速度越來越慢,然而社會對於計算能力的需求增速卻並未減緩,甚至在移動應用、大資料、人工智慧等新的應用興起後,對於計算能力、計算功耗和計算成本等提出了新的要求。與完全依賴於通用CPU及其程式設計模型的傳統軟體編寫樣式不同,異構計算的整個系統包含了多種基於特定領域架構(Domain-Specific Architecture, DSA)設計的處理單元,每一個DSA處理單元都有負責的獨特領域並針對該領域做最佳化,當計算機系統遇到相關計算時便由相應的DSA處理器去負責。而谷歌就是異構計算的踐行者,TPU就是異構計算在人工智慧應用的一個很好例子。

2017年釋出的第二代TPU晶片,不僅加深了人工智慧在學習和推理方面的能力,而且谷歌是認真地要將它推向市場。根據谷歌的內部測試,第二代晶片針對機器學習的訓練速度能比現在市場上的圖形晶片(GPU)節省一半時間;第二代TPU包括了四個晶片,每秒可處理180萬億次浮點運算;如果將64個TPU組合到一起,升級為所謂的TPU Pods,則可提供大約11500萬億次浮點運算能力。

3. 計算機視覺領域的攪局者——英特爾

英特爾作為世界上最大的計算機晶片製造商,近年來一直在尋求計算機以外的市場,其中人工智慧晶片爭奪成為英特爾的核心戰略之一。為了加強在人工智慧晶片領域的實力,不僅以167億美元收購FPGA生產商Altera公司,還以153億美元收購自動駕駛技術公司Mobileye,以及機器視覺公司Movidius和為自動駕駛汽車晶片提供安全工具的公司Yogitech,背後凸顯這家在PC時代處於核心位置的巨頭面向未來的積極轉型。

Myriad X就是英特爾子公司Movidius在2017年推出的視覺處理器(VPU,vision processing unit),這是一款低功耗的系統晶片(SoC),用於在基於視覺的裝置上加速深度學習和人工智慧——如無人機、智慧相機和VR / AR頭盔。Myriad X是全球第一個配備專用神經網路計算引擎的片上系統晶片(SoC),用於加速裝置端的深度學習推理計算。該神經網路計算引擎是晶片上整合的硬體模組,專為高速、低功耗且不犧牲精確度地執行基於深度學習的神經網路而設計,讓裝置能夠實時地看到、理解和響應周圍環境。引入該神經計算引擎之後,Myriad X架構能夠為基於深度學習的神經網路推理提供1TOPS的計算效能。

4. 執“能效比”之牛耳——學術界

除了工業界和廠商在人工智慧領域不斷推出新產品之外,學術界也在持續推進人工智慧晶片新技術的發展。

比利時魯汶大學的Bert Moons等在2017年頂級會議IEEE ISSCC上面提出了能效比高達10.0TOPs/W的針對摺積神經網路加速的晶片ENVISION,該晶片採用28nm FD-SOI技術。該晶片包括一個16位的RISC處理器核,1D-SIMD處理單元進行ReLU和Pooling操作,2D-SIMD MAC陣列處理摺積層和全連線層的操作,還有128KB的片上儲存器。

韓國科學技術院KAIST的Dongjoo Shin等人在ISSCC2017上提出了一個針對CNN和RNN結構可配置的加速器單元DNPU,除了包含一個RISC核之外,還包括了一個針對摺積層操作的計算陣列CP和一個針對全連線層RNN-LSTM操作的計算陣列FRP,相比於魯汶大學的Envision,DNPU支援CNN和RNN結構,能效比高達8.1TOPS/W。該晶片採用了65nm CMOS工藝。

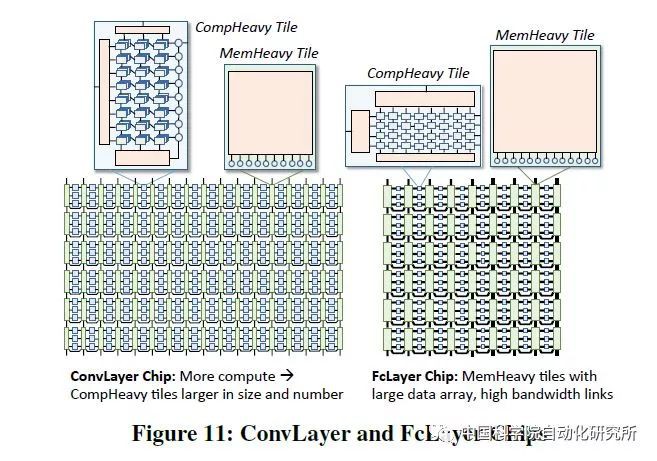

相比較於魯汶大學和韓國科學技術院都針對神經網路推理部分的計算操作來說,普渡大學的Venkataramani S等人在計算機體系結構頂級會議ISCA2017上提出了針對大規模神經網路訓練的人工智慧處理器SCALLDEEP。

該論文針對深度神經網路的訓練部分進行針對性最佳化,提出了一個可擴充套件伺服器架構,且深入分析了深度神經網路中摺積層,取樣層,全連線層等在計算密集度和訪存密集度方面的不同,設計了兩種處理器core架構,計算密集型的任務放在了comHeavy核中,包含大量的2D乘法器和累加器部件,而對於訪存密集型任務則放在了memHeavy核中,包含大量SPM儲存器和tracker同步單元,既可以作為儲存單元使用,又可以進行計算操作,包括ReLU,tanh等。而一個SCALEDEEP Chip則可以有不同配置下的兩類處理器核組成,然後再組成計算簇。

論文中所用的處理平臺包括7032個處理器tile。論文作者針對深度神經網路設計了編譯器,完成網路對映和程式碼生成,同時設計了設計空間探索的模擬器平臺,可以進行效能和功耗的評估,效能則得益於時鐘精確級的模擬器,功耗評估則從DC中提取模組的網表級的引數模型。該晶片僅採用了Intel 14nm工藝進行了綜合和效能評估,峰值能效比高達485.7GOPS/W。

02 國內 | 百家爭鳴,各自為政

可以說,國內各個單位在人工智慧處理器領域的發展和應用與國外相比依然存在很大的差距。由於我國特殊的環境和市場,國內人工智慧處理器的發展呈現出百花齊放、百家爭鳴的態勢,這些單位的應用領域遍佈股票交易、金融、商品推薦、安防、早教機器人以及無人駕駛等眾多領域,催生了大量的人工智慧晶片創業公司,如地平線、深鑒科技、中科寒武紀等。儘管如此,國內起步較早的中科寒武紀卻並未如國外大廠一樣形成市場規模,與其他廠商一樣,存在著各自為政的散裂發展現狀。

除了新興創業公司,國內研究機構如北京大學、清華大學、中國科學院等在人工智慧處理器領域都有深入研究;而其他公司如百度和位元大陸等,2017年也有一些成果釋出。

▲註:上述表格中所給為截止到2017年各研製單位公開可查的最新資料

1. 全球AI晶片界首個獨角獸——寒武紀

2017年8月,國內AI晶片初創公司寒武紀宣佈已經完成1億美元A輪融資,戰略投資方可謂陣容豪華,阿裡巴巴、聯想、科大訊飛等企業均參與投資。而其公司也成為全球AI晶片界首個獨角獸,受到國內外市場廣泛關註。

寒武紀科技主要負責研發生產AI晶片,公司最主要的產品為2016年釋出的寒武紀1A處理器(Cambricon-1A),是一款可以深度學習的神經網路專用處理器,面向智慧手機、無人機、安防監控、可穿戴裝置以及智慧駕駛等各類終端裝置,在執行主流智慧演演算法時效能功耗比全面超越傳統處理器。目前已經研發出1A、1H等多種型號。與此同時,寒武紀也推出了面向開發者的寒武紀人工智慧軟體平臺 Cambricon NeuWare,包含開發、除錯和調優三大部分。

2. 軟硬體協同發展的典範——深鑒科技

深鑒科技的聯合創始人韓松在不同場合曾多次提及軟硬體協同設計對人工智慧處理器的重要性,而其在FPGA領域頂級會議FPGA2017最佳論文ESE硬體架構就是最好的證明。該項工作聚焦於使用 LSTM 進行語音識別的場景,結合深度壓縮(Deep Compression)、專用編譯器以及 ESE 專用處理器架構,在中端的 FPGA 上即可取得比 Pascal Titan X GPU 高 3 倍的效能,並將功耗降低 3.5 倍。

在2017年10月的時候,深鑒科技推出了六款AI產品,分別是人臉檢測識別模組、人臉分析解決方案、影片結構化解決方案、ARISTOTLE架構平臺,深度學習SDK DNNDK、雙目深度視覺套件。而在人工智慧晶片方面,公佈了最新的晶片計劃,由深鑒科技自主研發的晶片“聽濤”、“觀海”將於2018年第三季度面市,該晶片採用臺積電28nm工藝,亞裡士多德架構,峰值效能 3.7 TOPS/W。

3. 對標谷歌TPU——位元大陸算豐

作為比特幣獨角獸的位元大陸,在2015年開始涉足人工智慧領域,其在2017年釋出的面向AI應用的張量處理器算豐Sophon BM1680,是繼谷歌TPU之後,全球又一款專門用於張量計算加速的專用晶片(ASIC),適用於CNN / RNN / DNN的訓練和推理。

BM1680單晶片能夠提供2TFlops單精度加速計算能力,晶片由64 NPU構成,特殊設計的NPU排程引擎(Scheduling Engine)可以提供強大的資料吞吐能力,將資料輸入到神經元核心(Neuron Processor Cores)。BM1680採用改進型脈動陣列結構。2018年位元大陸將釋出第2代算豐AI晶片BM1682,計算力將有大幅提升。

4. 百家爭鳴——百度、地平線及其他

在2017年的HotChips大會上,百度釋出了XPU,這是一款256核、基於FPGA的雲端計算加速晶片,用於百度的人工智慧、資料分析、雲端計算以及無人駕駛業務。在會上,百度研究員歐陽劍表示,百度設計的晶片架構突出多樣性,著重於計算密集型、基於規則的任務,同時確保效率、效能和靈活性的最大化。

歐陽劍表示:“FPGA是高效的,可以專註於特定計算任務,但缺乏可程式設計能力。傳統CPU擅長通用計算任務,尤其是基於規則的計算任務,同時非常靈活。GPU瞄準了平行計算,因此有很強大的效能。XPU則關註計算密集型、基於規則的多樣化計算任務,希望提高效率和效能,並帶來類似CPU的靈活性。

在2018年百度披露更多關於XPU的相關資訊。

2017年12月底,人工智慧初創企業地平線釋出了中國首款全球領先的嵌入式人工智慧晶片——面向智慧駕駛的徵程(Journey)1.0處理器和麵向智慧攝像頭的旭日(Sunrise)1.0處理器,還有針對智慧駕駛、智慧城市和智慧商業三大應用場景的人工智慧解決方案。“旭日 1.0”和“徵程 1.0”是完全由地平線自主研發的人工智慧晶片,具有全球領先的效能。

為瞭解決應用場景中的問題,地平線將演演算法與晶片做了強耦合,用演演算法來定義晶片,提升晶片的效率,在高效能的情況下可以保證它的低功耗、低成本。具體晶片引數尚無公開資料。

除了百度和地平線,國內研究機構如中國科學院、北京大學和清華大學也有人工智慧處理器相關的成果釋出。

北京大學聯合商湯科技等提出一種基於 FPGA 的快速 Winograd 演演算法,可以大幅降低演演算法複雜度,改善 FPGA 上的 CNN 效能。論文中的實驗使用當前最優的多種 CNN 架構(如 AlexNet 和 VGG16),從而實現了 FPGA 加速之下的最優效能和能耗。在 Xilinx ZCU102 平臺上達到了摺積層平均處理速度 1006.4 GOP/s,整體 AlexNet 處理速度 854.6 GOP/s,摺積層平均處理速度 3044.7 GOP/s,整體 VGG16 的處理速度 2940.7 GOP/s。

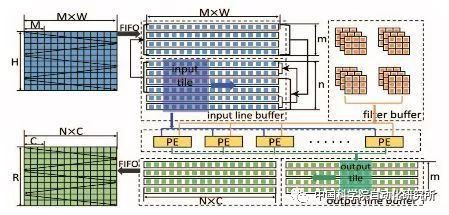

中國科學院計算機體系結構國家重點實驗室在頂級會議HPCA2017上提出了一種基於資料流的神經網路處理器架構,以便適應特徵圖、神經元和突觸等不同層級的平行計算,為了實現這一標的,該團隊對單個處理單元PE進行重新設計,使得運算元可以直接透過橫向或縱向的匯流排從片上儲存器獲取,而非傳統PE只能從上至下或從左至右由相鄰單元獲取。該晶片採用了TMSC 65nm工藝,峰值效能為490.7 GOPs/W。

清華大學微納電子系魏少軍等2017年的VLSI國際研討會上提出了基於可重構多模態混合的神經計算晶片Thinker。Thinker晶片基於該團隊長期積累的可重構計算晶片技術,採用可重構架構和電路技術,突破了神經網路計算和訪存的瓶頸,實現了高能效多模態混合神經網路計算。Thinker晶片具有高能效的突出優點,其能量效率相比目前在深度學習中廣泛使用的GPU提升了三個數量級。Thinker晶片支援電路級程式設計和重構,是一個通用的神經網路計算平臺,可廣泛應用於機器人、無人機、智慧汽車、智慧家居、安防監控和消費電子等領域。該晶片採用了TSMC 65nm工藝,片上儲存為348KB,峰值效能為5.09TOPS/W。

5. 新架構新技術——憶阻器

2017年清華大學微電子所錢鶴、吳華強課題組在《自然通訊》(Nature Communications)線上發表了題為 “運用電子突觸進行人臉分類”(“Face Classification using Electronic Synapses”)的研究成果,將氧化物憶阻器的整合規模提高了一個數量級,首次實現了基於1024個氧化物憶阻器陣列的類腦計算。該成果在最基本的單個憶阻器上實現了儲存和計算的融合,採用完全不同於傳統“馮·諾依曼架構”的體系,可以使晶片功耗降低到原千分之一以下。憶阻器被認為是最具潛力的電子突觸器件,透過在器件兩端施加電壓,可以靈活地改變其阻值狀態,從而實現突觸的可塑性。此外,憶阻器還具有尺寸小、操作功耗低、可大規模整合等優勢。因此,基於憶阻器所搭建的類腦計算硬體系統具有功耗低和速度快的優勢,成為國際研究熱點。

在神經形態處理器方面,最為著名的就是IBM在2014年推出的TrueNorth晶片,該晶片包括4096個核心和540萬個電晶體,功耗70mW,模擬了一百萬個神經元和2.56億個突觸。而在2017年,英特爾也推出一款能模擬大腦工作的自主學習晶片Loihi,Loihi由128個計算核心構成,每個核心集成了1024個人工神經元,整個晶片擁有超過個13萬個神經元與1.3億個突觸連線,與人腦超過800億個神經元相比,簡直是小巫見大巫,Loihi的運算規模僅比蝦腦複雜一點點而已。英特爾認為該晶片適用於無人機與汽車自動駕駛,紅綠燈自適應路面交通狀況,用攝像頭尋找失蹤人口等任務。

而在神經形態晶片研究領域,清華大學類腦計算研究中心施路平等在2015年就推出了首款類腦晶片—“天機芯”,該晶片世界首次將人工神經網路(Artificial Neural Networks, ANNs)和脈衝神經網路(Spiking Neural Networks,SNNs)進行異構融合,同時兼顧技術成熟並被廣泛應用的深度學習模型與未來具有巨大前景的計算神經科學模型,可用於諸如影象處理、語音識別、標的跟蹤等多種應用開發。在類腦“自行”車演示平臺上,整合32個天機一號晶片,實現了面向視覺標的探測、感知、標的追蹤、自適應姿態控制等任務的跨模態類腦資訊處理實驗。據悉,基於TSMC 28nm工藝的第二代天機晶片也即將推出,效能將會得到極大提升。

03 從ISSCC2018看人工智慧晶片發展趨勢

在剛剛結束的計算機體系結構頂級會議ISSCC2018,“Digital Systems: Digital Architectures and Systems”分論壇主席Byeong-Gyu Nam對人工智慧晶片,特別是深度學習晶片的發展趨勢做了概括。深度學習依然今年大會最為熱門的話題。相比較於去年大多數論文都在討論摺積神經網路的實現問題,今年則更加關註兩個問題:其一,如果更高效地實現摺積神經網路,特別是針對手持終端等裝置;其二,則是關於全連線的非摺積神經網路,如RNN和LSTM等。

同時,為了獲得更高的能效比,越來越多的研究者把精力放在了低精度神經網路的設計和實現,如1bit的神經網路。這些新型技術,使得深度學習加速器的能效比從去年的幾十TOPS/W提升到了今年的上百TOPS/W。有些研究者也對數字+模擬的混合訊號處理實現方案進行了研究。對資料存取具有較高要求的全連線網路,有些研究者則藉助3-D封裝技術來獲得更好的效能。

總結 | 對國產人工智慧晶片的一點愚見

正如前文所述,在人工智慧晶片領域,國外晶片巨頭佔據了絕大部分市場份額,不論是在人才聚集還是公司合併等方面,都具有絕對的領先優勢。而國內人工智慧初創公司則又呈現百家爭鳴、各自為政的紛亂局面;特別是每個初創企業的人工智慧晶片都具有自己獨特的體系結構和軟體開發套件,既無法融入英偉達和谷歌建立的生態圈,又不具備與之抗衡的實力。

國產人工智慧晶片的發展,一如早年間國產通用處理器和作業系統的發展,過份地追求完全獨立、自主可控的怪圈,勢必會如眾多國產晶片一樣逐漸退出歷史舞臺。藉助於X86的完整生態,短短一年之內,兆芯推出的國產自主可控x86處理器,以及聯想基於兆芯CPU設計生產的國產計算機、伺服器就獲得全國各地黨政辦公人員的高度認可,併在黨政軍辦公、資訊化等國家重點系統和工程中已獲批次應用。

當然,投身於X86的生態圈對於通用桌面處理器和高階伺服器晶片來說無可厚非,畢竟創造一個如Wintel一樣的生態鏈已絕非易事,我們也不可能遇見第二個喬布斯和蘋果公司。而在全新的人工智慧晶片領域,對眾多國產晶片廠商來說,還有很大的發展空間,針對神經網路加速器最重要的就是找到一個具有廣闊前景的應用領域,如華為海思麒麟處理器之於中科寒武紀的NPU;否則還是需要融入一個合適的生態圈。另外,目前大多數國產人工智慧處理器都針對於神經網路計算進行加速,而能夠提供單晶片解決方案的很少;微控制器領域的發展,ARM的Cortex-A系列和Cortex-M系列佔據主角,但是新興的開源指令集架構RISC-V也不容小覷,完全值得眾多國產晶片廠商關註。

作者:吳軍寧

來源:中國科學院自動化研究所(ID:casia1956)

推薦閱讀

日本老爺爺堅持17年用Excel作畫,我可能用了假的Excel···

看完此文再不懂區塊鏈算我輸:手把手教你用Python從零開始建立區塊鏈

Q: 你都用過哪款國產晶片?

歡迎留言與大家分享

覺得不錯,請把這篇文章分享給你的朋友

轉載 / 投稿請聯絡:baiyu@hzbook.com

更多精彩文章,請在公眾號後臺點選“歷史文章”檢視

知識星球

知識星球