作者丨李光睿

學校丨重慶大學本科在讀

研究方向丨計算機視覺

#Image Synthesis

CVPR 2018 Spotlight 論文,ReID + GAN 換 pose。

本文用了較多的篇幅講 loss function,pose 的提取用的是 OpenPose 這個庫。

其 loss 分為三部分:

1. Image Adversarial Loss:即傳統 GAN 的 loss;

2. Pose Loss:pose 差異,生成後的圖片再用 OpenPose 提取 pose 資訊做差值;

3. Identity Loss:此為關鍵,又分為兩部分,分別是 content 和 style loss,其中 content 用於保證生成圖和原圖在某 pretrain model 生成的 feature map 一致, style 則是利用 Gram matrix 生成某種 feature map,然後作比對。

#Person ReID

CVPR 2018 RE-ID Spotlight 一篇,這篇文章主要 contribution 有以下兩點:

1. 提出了一個新的更大的資料集,更為細緻:考慮到了視角,光照等更為細緻的因素,具體引數可以直接看文章;

2. 多個資料集間的差異,即 domain-gap,透過 GAN 來生成和模仿,類似文章:Camera Style Adaptation for Person Re-identification,個人認為創意是有的,可以作為 data augmentation 的一個方法,但實現難度上並沒有很大。

Disentangled Person Image Generation

#Image Generation

在 NIPS 2017 上,該團隊已經為我們貢獻了 Pose Guided Person Image Generation 這篇非常棒的文章,在 CVPR 2018 中,他們推出的更新的這篇文章不僅僅解決了換 pose 問題,還實現了”隨心所欲“的換裝換 pose,入選今年的 Spotlight。

在這裡提到的前一篇文章可復現度很高,可以嘗試。

該模型分為三個分支:

1. 運用 OpenPose 這個庫,生成 pose 的 18 個 dots,並將這 concat 進 decoder 之前的 feature map 中;

2. 在經過摺積運算後的 feature map 上,運用 mask 將前後景分離,背景的 feature map 也是直接 concat 進最後的 feature map 中;

3. 核心是前景的處理上,用 7 個 ROI 進一步將前景解開,然後用公用的 encoder 生成前景的 feature map。

#Network Generation

CVPR 2018 Oral 一篇,本文主要提出了透過封裝模組(block-wise)的方法,運用增強學習設計生成網路架構的方法。

封裝模組思路:

作者本人對增強學習和動態規劃理解有限,模組生成的總體思路是 Q-Learning 及動態規劃,其中提到了運用 reward shaping 最佳化設計過程,當是本文亮點之一。

設計完網路後,生成對應任務的準確率,作為 q-value(即 reward),然後再次重新生成網路。

此外,文章還提到了部分 trick:

-

在 reward 中將複雜度和計算複雜度納入;

-

early-stopping

#Convolutional Neural Networks

CVPR 2018 Oral,topic:網路設計模組化。

如名所示,提出了 aggregation 的具體思路,併在層融合上提出了具體方式。

#Face Age Progression

CVPR 2018 Oral,intro 和 related works 主要講了現有方案大多將年齡資訊優先而 identity 資訊次之,換句話說,就是生成不同年齡的同時,identity 資訊不能很好保留。

Generator 部分不做介紹,無亮點,本文亮點在 loss 部分。

文中提出了特徵提取器用於提出特定特徵,原因是作者認為相同年齡段的不同人臉有著相同的的紋理等特定資訊,而這個提取器就是提取出這些特徵。此外,該分類器是經過 age 分類任務預訓練好了的。

文中和今年很多思路一樣,考慮到了 low-level 和 high-level 資訊,將第 2、4、7 等層資訊 concat 起來,作為 d 的輸入。

identity 資訊的保留和上一個 extractor 類似,在人臉分類資料集上預訓練,然後拿來直接當 extractor。

#Convolutional Neural Network

北大團隊提出的新的 block 設計,achieves the performance of the state of the art with less parameters.

block 內部更新的核心思路可以直接看這個公式,每一層更新時的輸入是比他低的層的更新後的輸出加上比他高的層更新前的輸出。

由於 block 內任意兩層互連,故實現了 top-bottom refinement,也就實現了 attention 機制。

還提到了部分 technique:

1. channel-wise attention mechanism

2. Bottleneck and compression

#Object Detection

CVPR 2018 Oral, 今年 CVPR Landmark 和 Attention 這兩個詞出現的頻率很高。

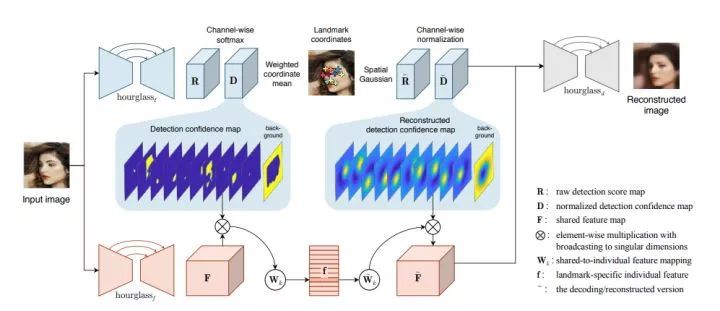

Landmark Detector

本文采用的是名為 hourglass 的網路構架,以圖片作為輸出,該網路輸出 k+1 個 channel,含有 k 個 landmark 和背景。對不同 landmark 用 softmax 生成 confidence。

在如圖公式中,Dk(u,v) 意思是第 k channel 中坐標為 (u,v) 的值,Dk 是 weight map,與對應坐標相乘,再除以總的權重和坐標乘積的和,從而生成該 channel 的 landmark 的 normalized 坐標。

Soft Constrain

為了保證我們生成的諸 landmark 及其坐標是表達的我們想要的 landmark 而非其他 latent repre,文章提出了幾個 soft constrain:

1. Concentration Constrain:

計算兩個坐標軸上坐標的方差,設計如圖示 loss 是為了使方差盡可能小。

這裡做了一個近似,使之轉換成了 Gau dis,更低的熵值意味著 peak 處更多的分佈,換句話說,就是使 landmark 盡可能地突出出來。

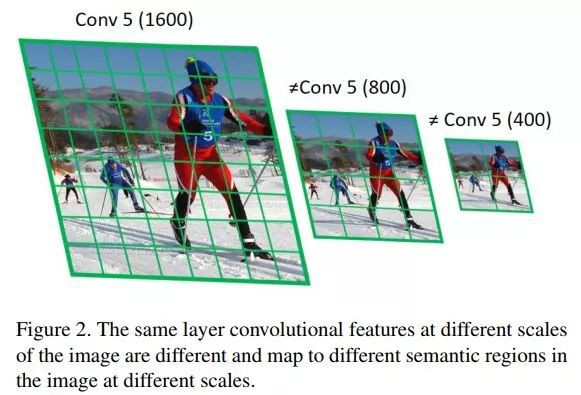

2. Separation Constrain:

由於剛剛開始訓練時候的輸入時純 random distribution,故可能導致提取出的 landmark 聚集在中心,可能會導致 separation 效果不好,因此而落入 local optima,故設計了該 loss。

這個 loss 也不難理解,將不同 channel 間的坐標做差值,使得不同 landmark 盡可能不重疊。

3. Equivariance Constrain

這個比較好理解,就是某一個 landmark 在另一個 image 中變換坐標時應該仍能夠很好地定位,在這裡,作者介紹了他們實現 landmark 變換坐標的幾個trick。

4. Cross-object Correspondence

本文模型認為不能保證同一 object 在不同情況檢測時絕對的 correspondence,文章認為這應該主要依賴於該特定 pattern 能夠在網路生成的啟用值展現一定的共性。

Local Latent Descriptors

這個 des 的目的是解決一個 delimma:除了我們定義的 landmark,可能還有一些 latent representation,要複原一個 image,僅僅 landmarks 是絕對不夠的,所以需要一些其他的資訊作為一個補充,但表達他們又有可能影響 landmark 的表達。

在這裡,文章又用了另一個 hourglass network,如圖中左下角的 F,就在我們之前提到的 concentration costrain 中,用一個高斯分佈來將該 channel 對應的 landmark 突出出來。

在這裡,文章將他當做 soft mask 來用,用 mask 提取後再用一個 linear operator 來講這些 feature map 對映到一個更低維的空間,至此,local latent descriptor 就被生成了。

Landmark-based Decoder

第一步,Raw score map.

第二步,normalize.

第三步,生成最終影象。

在這裡,wk 是 landmark-specific operator。

簡言之,Dk 是我們提出的 landmark 位置資訊,fk 是對應 landmark 的 descriptor。

這裡又提到了一個 dilemma:在用 mask 的時候,越多的 pixel 被納入是最理想的,但納入太多又使得邊緣的銳利不能體現,因為該文用了多個不同的超引數來嘗試。

#Object Detection

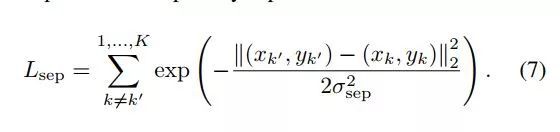

CVPR 2018 Oral,如下圖,文章主要解決網路處理不同 scale 圖片的網路策略。

▲ 讀圖中配字,理解文章針對的問題

▲ 圖2

▲ 圖3

如上面兩個圖示,三種網路的訓練方式和效果一目瞭然。

結論是:當我們要檢測小的物體時,在輸入是大的 scale 的網路上預訓練、在高解析度作為輸入的網路上預訓練、在upsample後的圖片作為輸入的網路上預訓練,對檢測小物體有益。

第 4 部分講了用了 DeformableRFCN 模型,第 5 部分主要討論了在不同解析度下訓練,在同樣的高解析度 test 的結果及其分析:

1. 在中解析度下訓練的模型比在高解析度下訓練的模型效果差,原因很簡單,因為後者訓練測試的解析度相同,但並沒有拉開很大的差距,為什麼呢?因為中高 scale 的 object 被變得太大以致不能被檢測到;

2. 作者隨後在高解析度下訓練了只針對 80pixel 下 Object 檢測的模型,但結果比在中解析度下的效果差了很多,為什麼呢?因為忽視中高 scale 的 Object 對訓練影響非常大;

3. 作者又用多解析度訓練模型(MST),但仍因為過小或過大的 Object 影響,效果仍不理想。

Scale Normalization for Image Pyramids

第 6 部分,作者提出了最終的模型。該模型的輸入解析度最低 480*800,最高 1400*2000,對於訓練中過大或者過小 scale 的 Object,模型選擇直接忽略,訓練只針對在 scale 的一個範圍內的 Object。

後面就是訓練細節和 trick,詳情可以翻看論文。

#Introspective Neural Networks

CVPR 2018 Oral,同時也是目前為止個人印象最深刻的一篇文章。

文章主要做的事情就是提出了基於 Wasserstein 的 INN,該組已經在 ICCV,NIPS 等多次提出並改進該模型,該模型主要做的就是將 GAN 中的 G 和 D 結合起來。

文章最開始給了一下最基本的 notation,然後介紹瞭如何將 INN 與 Wasserstein 結合起來並給出了必要的數學證明。

▲ 演演算法

上圖為分類過程 loss 的設計,圖中兩個公式,前者是標的函式,很容易理解,後者則是正則項,正則項是以隨機的 a 來生成真資料(x+)與生成的假資料(x-)的 mixture。

合成部分

合成部分的公式中,簡言之,就是以生成圖與原圖的相似度作為衡量標準。

圖中取用的 21,29 是作者的前面兩篇文章,分別是 NIPS 2017 和 ICCV 2017,作者在這篇文章中並未給出任何證明,後期本人應該會補上這兩篇的筆記。

#Action Recognition

CVPR 2018 Oral,本文思路很清晰且已讀,具體細節可以看文章,這裡僅僅把總體思路講一下。

用 u-net 訓練一個模型:輸入是一個靜態的幀,輸出的預測的五幀光流資訊,模型在 YouTube 資料集上訓練。

該模型 loss 分兩部分,一部分是將生成的五幀光流資訊與 YouTube 資料集的 groundtruch 對比,另一部分是將生成的光流資訊與真實的光流資訊送進某網路(在 ucf101 上預訓練過的 resent)計算歐式距離;前者是要求準確,後者是為了更好保留 high-level 的動作資訊。

最終將 rgb 和預測的光流作為標準 two-stream 模型的輸入進行預測。

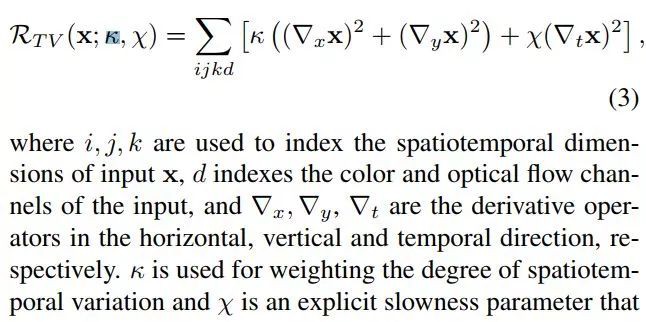

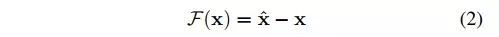

#Deep Spatiotemporal Representations

CVPR 2018 Zisserman 的新論文,這篇文章就是 two-stream 模型中間層的視覺化方法,換句話說,就是探尋 two-stream 模型學到了怎樣的時空資訊。

生成總共分為兩個步驟,詳情如上圖:計算出輸入的偏導,將計算出來的梯度用學習率 scale 並加到當前輸入上。

Activation Maximization

本文還提到了兩個正則方法:

1. 防止過大的值

2. 限制低頻資訊

#Neural Networks

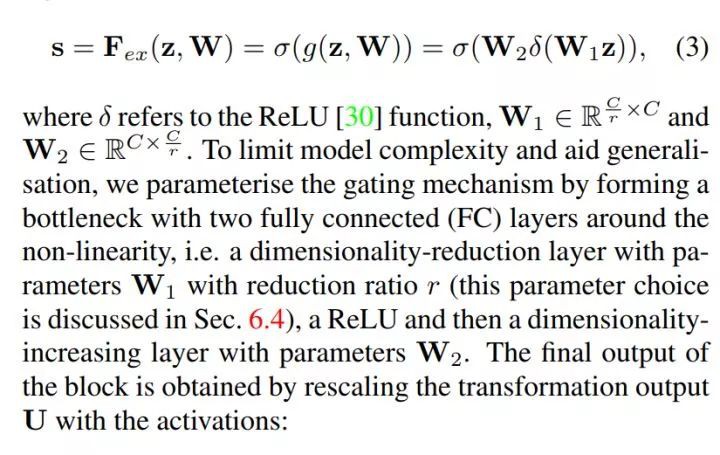

今年的 Oral,令人印象深刻的一篇文章,網上解讀很多,相當於在 channels 上加了一個 attention 機制,給不同的 channel 不同的權重。

這篇文章行文思路清晰,哪怕學習寫論文也要看一看。

Squeeze

簡言之就是全域性平均池化,是因為低層的感受野太小導致效果差。

Excitation

這個環節主要是搞清 channels 之間的關係及重要性。這裡作者提出了兩個要求:

1. 靈活,作者解釋:能夠學習 channels 間非線性的關係;

2. 必須學習一個非互斥關係,因為設計的 block 是為了強調多個 channels 而非一個。

這裡設計了兩個全連線層,一個降維,一個升回原來的維度。對於降維再升維,作者給出的解釋是為了降低計算複雜度和協助泛化。

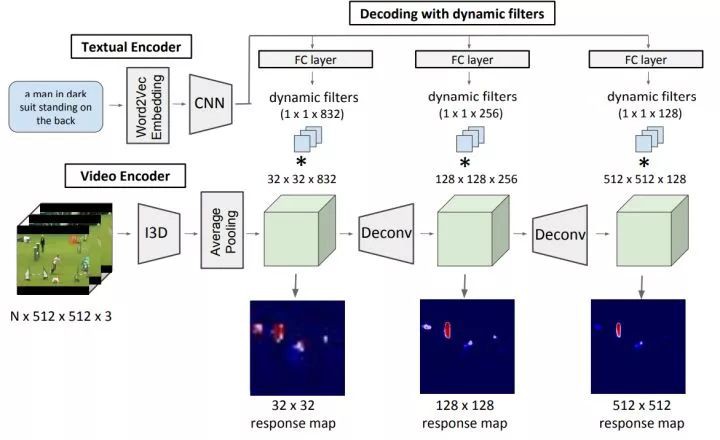

#Video Object Segmentation

CVPR 2018 Oral,本文定義了一個新的任務:給出一個句子,根據該句子分割影片中的 actor 及其 action。

主要有三大部分:

1. Textual Encoder:使用 word2vec 的預訓練模型,句子中的每個詞被編碼成 1×300 的 vector,一個句子則聲稱 nx300 的 matrix,透過 padding 使句子們 size 統一,網路構造詳情見文章;

2. Video Encoder: encode the actor and its action. 網路構型採用 state of the art 的運用 3d filte r的 I3D model,後面又提到 follow 了 two stream 模型,未做很多解釋,只說同時學習 RGB 和光流資訊;

3. Decoding with dynamic filters:這裡又提到了 dynamic conv filters,這是我第二次見到這個,感覺還是有必要讀一下,若網上解讀不多,會後期發出筆記。

為了保持同樣的解析度,使用了 deconv,deconv 的應用上有一些創新和 trick,詳情請翻讀論文。

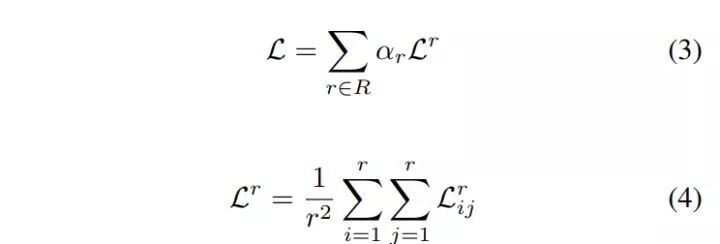

模型的訓練

訓練時模型的輸入:影片片段,sentence,segmentation mask。

▲ loss function

公式中的 r 表達的是不同的解析度,作者解釋是將多個解析度納入考慮,形成一種類似 skip-connnection 的效果。

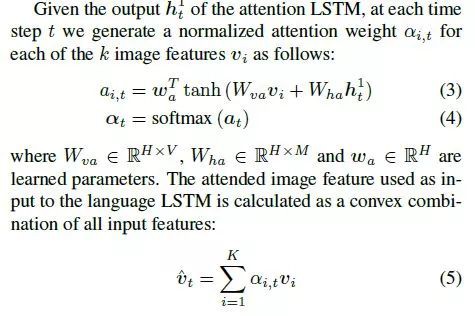

#Visual Question Answering

CVPR 2018 Oral,主題是 attention+VQA,這是筆者作者讀的第一篇關於這個領域的問題,可能難免會有講得不夠透徹的地方,歡迎批評指正和討論。

本文的主要思路是用 faster-rcnn 提取出 proposal,然後用其做 image captioning 或者 VQA,該方法取得了 2017 VQA Challenge 的第一名。

Bottom-Up Attention Model

簡言之,該部分就是直接復用了 faster-rcnn,提取出超過特定閾值的區域,並提取出其平均池化特徵。

Captioning Model

在這裡作者提到,該文的 captioning 系統即便在沒有基於 faster rcnn 的前提下,也有著相當好的體現,具體效果可以看 experiment 部分。

該部分作者未能講得非常透徹,主要是對 NLP 理解相當有限,後面會更新這部分的講解,這部分主要做的事情是用兩層 lstm,以 faster rcnn 生成的 feature 和 sentence 做輸入,生成對應 features 的 attention weights。

該部分由兩層 LSTM 組成:

▲ h的右上標的12分別代表attention,language lstm的輸出

1. 第一層 LSTM:top-down attention

在這裡直接將 faster-rcnn 階段生成的 region feature 稱為 V,該層的輸入時將:平均池化後的 v,上一時刻 language LSTM 的輸出,之前生成的 words,concat 起來。

對於某一個時刻 attention lstm 的輸出,生成一個 normalized attention weight,如下圖:

2. 第二層 LSTM:language

該層將 faster-rcnn 階段生成的 region feature 與 attention LSTM 的輸出 concat 起來作為這一層的輸入。

▲ 很容易理解,不做解釋

3. Objectives

該部分作者只是取用並復用了已有方法。

VQA Model

先將問題用 GRU encode 成 the hidden state q,這個 q 又當做 top-down 系統的輸入,即上面提到的兩層 lstm,生成 attention weight。

#Visual Question Answering

CVPR 2018 Schedule 上的第一篇 Oral,這篇文章主要定義了一個新的 task 並給出了一個資料集。

任務定義:將一個 agent 隨機丟進一個房間,向他提出一個問題,這個 agent 需要自己導航並回答問題。

▲ 問題型別,大家可以大致理解下

資料集問題,場景的生成都是用已經存在的 method 生成的,詳情可以翻閱論文。

這個 task 總體來說對於 agent 提出了四個要求:vision,language,navigation,question answering,文章還給出了各個部分的具體結構,很容易理解。

▲ 訓練策略

#Transfer Learning

CVPR 2018 Oral,本文定義了一個新的任務,針對在視覺內的遷移學習,並提出了一個蠻大的資料庫,然後還有 Malik,Savarese 兩位大牛掛名,感覺很值得關註。

定義的任務是這樣的:vision task 類目很多,只針對某個問題來解決的話,會需要很大的標註的資料集,但我們不難想到的是,一個視覺任務的解決應該能夠一定程度的解決另一個視覺任務,畢竟一個成熟模型的構建意味著對該 image 的一定的理解,而這部分的理解的一部分或許對另一個 task 有助益,例,物體 relation 的理解對深度資訊的學習毫無疑問是有著助益的。

首先做一個 notation 說明:source task 是指我們已經有著足夠標註資料集或者資訊,能夠解決的問題,target task 則是指待解決,希望透過前者的遷移學習來解決的問題。

有三個階段:

Step I: Task-Specific Modeling

encoder-decoder 結構,不需過多解釋。

Step II: Transfer Modeling

這裡的 transfer function 就是一個 decoder,他的輸入時多個 source task encoder 的 encoder 的輸出。

這裡作者提出了設計時應當考慮到的因素:

1. accessibility:首先,應該含有潛在的能夠解決 target task 的資訊,因此文章設計了一個小結構,用其基於小規模資料測試 accessibility;

2. higher-order transfers:多輸入,過濾掉有著更低 contribution 的 representation 的 filter 策略;

3. transitive transfers

Step III: Ordinal Normalization using Analytic Hierarchy Process (AHP)

簡言之,就是計算不同的 source 對一個 target task 的貢獻度。

Step IV: Computing the Global Taxonomy

計算全域性的一個 contribution graph。

#Convolutional Neural Networks

CVPR 2018 Oral,顧名思義,提出了保留 detail 的池化方法。

max/avg pooling 一個只選取最大而忽略與周圍畫素的關聯性,一個重視關聯性卻又直接抹平,並且在實際梯度計算中也有一些 drawback,所以該文提出了這個新方法,一句話概括,就是在池化過程中學了一個動態的 weight。

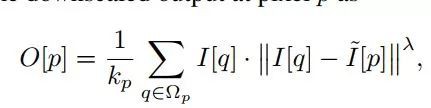

Notation:在此,我們以 I& 代替文章中出現的![]() ,ID 代指

,ID 代指![]() 。

。

Detail-Preserving Image Downscaling

▲ I是原圖,O是output,[]表示取對應坐標畫素值

▲ 如圖所示,ID是用近似高斯分佈的filtersmooth後的影象

作者總結:DPID 計算的是 weighted average of the input,周圍的畫素中,越近或者 difference 越大的值能夠給最終的 output 更高的 contribution。

以上這一部分是一個鋪墊。

Detail-Preserving Pooling

作者這部分就是將上一部分提出的 downscale 思想轉化成文章的 DPP(如 title) 簡言之,就是將上部分中的 L2 NORM 替換成一個可學習的 generic scalar reward function。

首先給出 weight 的表示:

▲ α和λ就是我們要學習的引數

這裡用了 constrain 來保證兩個引數為非負。

這裡給出了兩種 reward function:

▲ 這裡為了簡潔,將λ省略掉了

可以看到,相對而言,後者更傾向與給比中心畫素高的畫素更高權重,前者則是給差距大的更高權重。

後面,作者又補充了 I& 的生成:

#Image Synthesis

CVPR 2018 Oral,本文解決了 GAN 生成高解析度突破的問題,解析度達到了 2048*1024,方法精細,值得深入來看。

先來看 Generator:

如圖所示,中間部分的 G1 在低解析度情況下訓練,然後在前後又分別加上 G2,註意左邊部分的 G2 的輸出和 G1 的輸出 concat 之後,作為右邊 G2 的輸入。

再來看 D:這裡的 discriminator 是 multi-scale,有著三個針對不同尺寸的 D,三個尺寸分別是原尺寸,二分之一,四分之一。 放縮尺寸的理由不難理解,receptive field 大小的問題。

▲ objective中,三個D都納入考慮

Improved Adversarial Loss

一句話概括:在 D 的中間多個層抽取 feature map,作為分類和訓練依據。

Using Instance Map

個人認為是本文最 inspiring 的一點,先放對比圖。

圖勝千言,boundary map 一方面更加精細,也對邊緣的處理上給出了看起來很理想的解決方案。具體的對比解釋可以去文中尋找。

b map 的提取不難理解,主要是基於 semantic labels。

Learning an Instance-level Feature Embedding

這部分是基於前面提到的 instance level 資訊,做一個精細化的 embedding。在 generator 的輸入中,除了 ori img,boundary map 之外,還有 low-dimensional feature。

為了生成這些 low-dim feature,作者又設計了一個標準的 encoder-decoder 來生成。在這個 encoder 訓練好之後,還用生成的特徵做了一個聚類,從而可以控制生成圖片的 style。

#Data Augmentation

CVPR 2018 Oral,簡言之,就是用 GAN 生成新資料。

結構沒太多新意,也不會很難理解,就是在 appearance 和 pose 上分離。

在網路設計上,作者提到了三點:

1. 為了避免網路只是單純的 match feature pairs,如上圖所示,只是學習 the residual;

▲ 即source和target的feature vector的差

2. appearance 和 pose 分開訓練,pose 的學習便可以全監督訓練學習;

3. appearance 和 pose 分開訓練,能夠使對這兩個屬性的學習上更加 balance。

#GAN

CVPR 2018 Oral,首先要解釋一下 domain 的定義:

這裡的 domain 是指標對資料集中的 attribute,根據 attribute 來劃分的,比如就性別這個 attri 而言,男是一個 domain,女是一個,相對於發色而言,金髮是一個 domain,黑髮是一個 domain。

隨後作者提出,如果要 cross domain 來訓練 GAN,太麻煩了,n 個 domain 需要 n(n-1) 個 translator,作者在本文提出了一個可以解決 multiple domain translation 的 translator。

▲ 整個網路結構,下麵文字講得很清楚了

Adversarial Loss:這部分設計無太多新意。

Domain Classification Loss:簡言之,分成了兩個部分,第一個部分負責在 D 講 real img classify 到正確 domain label,第二個部分,則是負責激勵 G 將 fake img 向 target domain label 靠近。

Reconstruction Loss:簡言之,就是 cycleGAN 採用的那種 loss,具體請參見 cycleGAN,是為了保證 cross-domain 過程中只更改我們想要更改的部分。

#Zero-Shot Learning

CVPR 2018 Oral,Zero-Shot Learning 就是尋求將學習到的特徵對映到另一個空間中,從而 map 到 seen 及 unseen 的屬性或者 label 上。

這篇文章的主要亮點在於學習了已定義label的同時,學習了latent attribute(隱含屬性)。

已有方案的 drawbacks:

1. 在對映前,應當抽取 image 的 feature,傳統的用 pretrain model 等仍不是針對 zero-shot learning (ZSL) 特定抽取特徵的最優解;

2. 現有的都是學習 user-defined attribute,而忽略了 latent representation;

3. low-level 資訊和的空間是分離訓練的,沒有大一統的 framework。

本文便是對應著解決了以上問題。

Notation:

FNet:抽取 img 的 feature;

ZNet: 定位最 discriminative 的區域並將其放大;

ENet:將 img feature 對映到另一個空間。

下麵我們先介紹各個子網路 :

FNet (The Image Feature Network)

這部分直接借用了已有的 VGG19、GoogleNet,不細講。

ZNet (The Zoom Network)

這裡的目的是定位到能夠增強我們提取的特徵的辨識度的r egion,這個 region 同時也要與某一個我們已經定義好了的 attribute 對應。

ZNet 的輸入是 FNet 最後一個摺積層的輸出。在這裡運用某個已有的啟用函式方法,將我們定位好了的 region 提取出來,即將 crop 操作在網路中直接實現。

然後,將 ZNet 的輸出與 original img 做 element-wise 的乘法,最後,將 region zoom 到與 original img 相同的尺寸。

如圖,再講該輸出輸入到另一個 FNet(第一個 Fnet 的 copy)。

ENet (The Embedding Network)

這裡作者提出了一個 score 用於衡量 img feature 和 attribute space 的相似性(相容性)。

ENeT 將 img feature 對映到 2k dim 的空間中,1k 是對應於已經定義了的 label,並用 softmax loss。另 1k 則是對應潛藏屬性,為了使這些特徵 discriminative,作者使用了 triplet loss。

#Object Detection

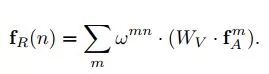

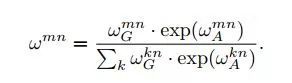

CVPR 2018 Oral,本文設計了一個考慮 relation 的 module,來增強 object detection 的效能。

對於每一個 object,都將其餘所有 object 的 appearance 和坐標納入考慮,增加在已有的 feature 上。

文中以倒推的方式給出表達,首先是最終表達(n-th Object 的 relation feature):

▲ fA的上標m是指第m個

▲ 式子左邊的值是其餘objects對這個Object的影響

▲ 本式的更具體解釋清翻看論文

再一點就是 fG 的處理:

這裡有兩步,首先將兩個物體的 fG 對映到高維表示,即 εG。

第二步則是將該特徵用 wG 對映到 scalar weight,max 的使用起到了類似 RELU 的作用,對幾何關係表示的權重做了一個限制。

再一個就是為了保證幾何特徵在變換中的不變性(invariant to translation and scale transformations),做瞭如下變換:

再將上圖特徵做了一個對映,對映過程未做過多解釋,只是做了一個取用。該文與其他類似方法最大的區別便是將幾何資訊納入考慮。

最終的表示不難理解:

就是將某一物體原有的 appearance feature 和其餘所有 Object 與該物體的 realation feature 加起來,為了保證維度一直,在 relation feature 生成時就已經將 feature 維度壓縮,從而 concat 之後的 relation feature 與 fA 對應。

隨後給出了證明,該 module 輸入輸出維度一致。

總得來說,這篇筆記還不夠透徹,後面會更新更補充,核心思想就是將文中取用的 scaled dot product attention 做了一個應用。

#Image Synthesis

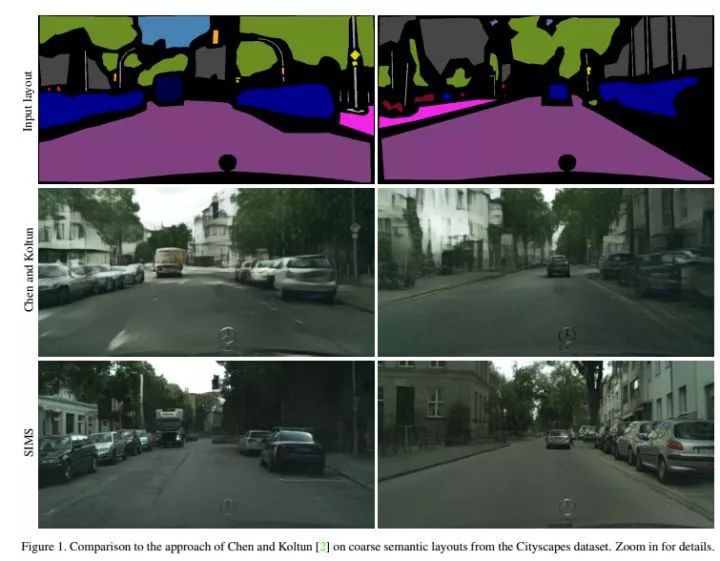

CVPR 2018 Oral,來自 CUHK,這裡設計的模型以 semantic layout 輸入,輸出真實的相片般的圖片。

▲ 最上面一排是輸入,下麵是輸出

模型的訓練基於是由 layout 和 color img 組成的 pair,用這樣的 pair 生成 memory bank。

Notation:我們用 M 表示 memory bank。

test 的時候,對於一個 semantic label map,我們的模型將其 segment,並從 M 中基於形狀等資訊找到對應的component。match 的塊的填充將要被填充到一個 canvas 上,由一個網路完成;為了預防重疊,設計了另一個網路來設計填充的順序。

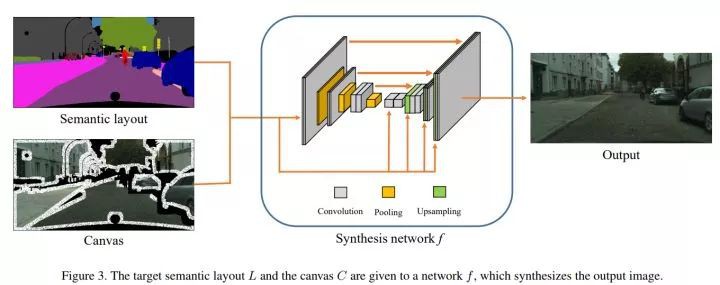

canvas 和 input layout 作為 synthesis network 的輸入,生成最終的輸出。

M 的表示

所謂的 memo bank 就是 segments 的一個 bank,基於 semantic label map 生成。

每一個 segment 定義了三個屬性,顏色,binary mask,semantic map(該 segment 周圍的 context,併在一個 bounding box 範圍內)。

Retrieval

對於一個新的 semantic layout,對於每一個 segment,計算出上面提到的三個屬性,基於下麵的 score 計算方法, 從 M 選出最 match 的塊:

▲ 兩個iou分別衡量的是segment本身shape,該segment周圍context

Transformation

在本階段,透過旋轉,放縮等變換,將選取的 segment 變得更加 match。

▲ objective

test 的時候 segment 之間不是完美契合的,所以訓練的時候我們的訓練資料也應當是不完全契合的,故直接用 mask 來做 map 是不行的,這裡作者用 random affine transformation。

Canvas

這一階段則是將 transform 後的 segment 放到一個 canvas 上,為瞭解決重疊問題,設計了一個 ordering network,這裡的思路挺讓人耳目一新的,為了訓練這樣一個網路,使用了深度資訊,對於沒有深度資訊的資料集,則是使用預測 depth 資訊的網路生成。

Image Synthesis

The image synthesis network f takes as input the semantic layout L, the canvas C, the target semantic layout and a binary mask that indicates missing pixels in the canvas.

#Action Recognition

CVPR 2018 Oral,Pose 合成。

網路的輸入是 original img,original pose,target pose,並預設 original img 和 target img 背景一樣,人是同一個。 首先前後景分離,然後針對前景(即人),針對身體的不同部分做細緻的 segment。

Pose Representation

人身體的 pose 用 14 個 dots 表示,在 dots 處還加入了高斯噪聲,有利於 regularization,且有利於網路更快學習到這個特徵。

Source Image Segmentation

分前後景,前景又對應著已經定義好了的身體部分(10 個)。採用 u-net,輸入是 original img 和 pose 的 concat,輸出是各個部分的 mask。

Foreground Spatial Transformation

這一過程則是將分割後的 segment 和 target pose 一一對應起來,並作相應的旋轉,放縮等。

Foreground Synthesis

前一階段我們已經根據 target pose 將各個 segment 位置變換好了,簡言之,就是把人的是個部分拆開來,然後根據標的姿勢重新組合,這一步則是將其徹底的合成,使其具備和真實照片一眼的一致性。

也是用的 u-net,輸入為 target pose 和已經 segments,輸出時 foreground 和 target mask。

Background Synthesis

這部分則是處理新的 target 之間的孔洞,無新意。

Loss Function

兩部分組成 VGG LOSS:將 VGG19 的前 16 層的輸出 concat 並計算 L1 距離。傳統的 GAN loss。

點選標題檢視更多論文解讀:

▲ 戳我檢視招聘詳情

#崗 位 推 薦#

#崗 位 推 薦#

關於PaperWeekly

PaperWeekly 是一個推薦、解讀、討論、報道人工智慧前沿論文成果的學術平臺。如果你研究或從事 AI 領域,歡迎在公眾號後臺點選「交流群」,小助手將把你帶入 PaperWeekly 的交流群裡。

▽ 點選 | 閱讀原文 | 訪問作者知乎專欄

知識星球

知識星球