導讀:多年來,深度學習一直處於所謂的人工智慧革命的最前沿,許多人相信深度學習將帶領我們進入通用AI時代。然而,從12,13年甚囂塵上,到如今的塵埃落地,浪潮一再的退去。面對疲軟的風口,養肥的豬,人工智慧將何去何從?

作者:FILIP PIEKNIEWSKI

翻譯:Yingying, Chaofan, Huaiwen

來源:專知(ID:Quan_Zhuanzhi)

00 AI Winter Is Well On Its Way

多年來,深度學習一直處於所謂的人工智慧革命的最前沿,許多人相信深度學習將帶領我們進入通用AI時代。在2014,2015,2016年,很多事件每每推動人們對 Ai的理解邊界。例如Alpha Go等。特斯拉等公司甚至宣稱:全自動駕駛汽車正在路上。

但是現在,2018年中期,事情開始發生變化。從錶面上看,NIPS會議仍然很火,關於AI的新聞也很多,Elon Mask仍然看好自動駕駛汽車,而Google CEO不斷重申Andrew Ng的口號,即AI比電力作出了更大的貢獻。但是這些言論已經開始出現裂紋。裂紋最明顯的地方是自動駕駛——這種現實世界中的實際應用。

01 深度學習塵埃落定

當ImageNet有了很好的解決方案(註意這並不意味著視覺問題得到已經解決【1】),該領域的許多傑出研究人員(甚至包括一直保持低調的Geoff Hinton)都在積極地接受採訪,在社交媒體上釋出內容(例如Yann Lecun,吳恩達,李飛飛等)。他們的話,可以總結為:世界正處在一場巨大的AI革命中。然而,好幾年已經過去了,這些人的Twitter資訊變得不那麼活躍了,比如 Andrew Ng:

2013年 – 每天0.413推文

2014 年- 每天0.605條推文

2015 -每天0.320條推文

2016 -每天0.802推文

2017 -每天0.668推文

2018 -每天0.263推文(至5月24日)

也許這是因為Andrew 的某些誇張言論,在當下會被進行更詳細的審查,如下麵的推文【2】所示:

不可否認,深度學習的熱度已經大大下降,贊美深度學習作為AI終極演演算法的推文少得多了,而且論文正在變得不那麼“革命”,現在大家換了個詞,叫:進化。

自從Alpha Zero以來,DeepMind已經許久沒有產出令人驚嘆的東西了。 OpenAI更是相當的低調,他們最近一次出現在媒體的報道上,是他們做了一個自動打Dota 2【3】的機器人 [我一開始以為,這是跟 Alpha Go 一樣的偉大,然後後來證明,並不是]。

從某些文章來看【4】,貌似Google實際上並不知道如何處理Deepmind,因為他們的結果顯然不如原先預期的那麼實際……至於傑出的研究人員,他們一般都為了funding 在各種政府機構間遊走,Yann Lecun甚至【5】從 Facebook的AI首席科學家的位置上下臺了。

像這種從富有的大公司向政府資助的研究機構的逐漸轉變表明,這些公司對這類研究的興趣(我認為是谷歌和Facebook)實際上正在慢慢消失。這些都是早期跡象,沒有人大聲的宣揚,但這些行動就像肢體語言,也能傳達某種意思。

02 大規模深度學習(實際並沒有)

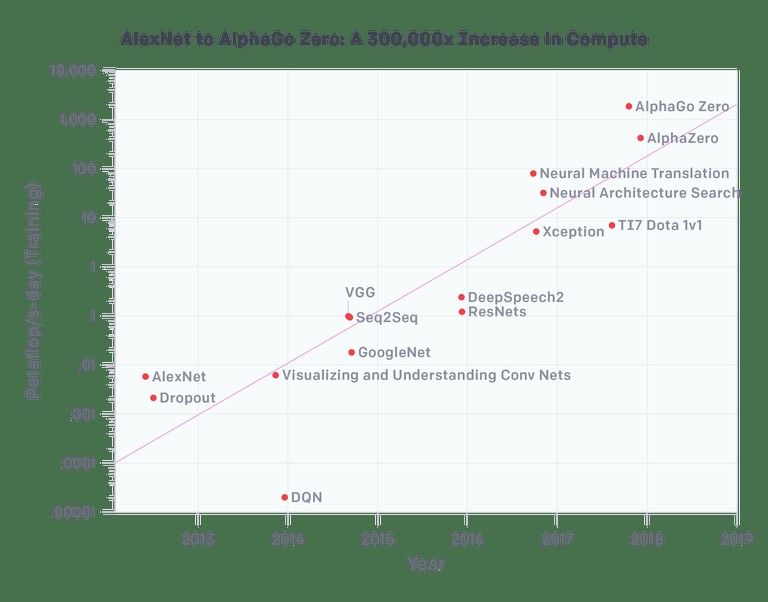

深度學習的一個重要口號是它可以輕鬆的擴充套件。我們在2012年擁有60M引數的AlexNet,現在我們已經有至少1000倍的數量的模型了嗎?好吧,我們可能會這樣做,但問題是 – 這些東西有1000x的能力提升嗎? 100倍的能力? openAI的研究派上用場:

因此,就視覺應用而言,我們看到VGG和Resnets在計算資源應用的一個數量級上飽和(就引數數量而言實際上較少)。Xception是谷歌Inception架構的一種變體,實際上它在ImageNet上的表現只是略微優於其他模型,因為AlexNet基本上解決了ImageNet。

因此,在比AlexNet計算量提高100倍的情況下,我們在視覺方面已經有了近乎飽和的體系結構,換句話說,影象分類的精確已經提不動了。

神經機器翻譯是所有大型網路搜尋玩家(google, baidu, yahoo 等)的一大努力,難怪它有多少機器就用多少機器(儘管谷歌翻譯仍然很糟糕,雖然已經在變得更好了)。

該圖上的最新三點有趣地顯示了Deep Mind和OpenAI應用於遊戲的強化學習相關專案。特別是AlphaGo Zero和稍微更通用的Alpha Zero需要大量計算,但不適用於真實世界的應用程式,因為需要大量計算來模擬和生成這些資料來供這些模型使用。

好的,現在我們可以在幾分鐘內完成AlexNet的訓練,但是我們可以在幾天內訓練一個比AlexNet大1000倍,質量更好的模型嗎?顯然不是……

所以實際上,這張旨在表明深度學習規模的圖,表明瞭最終結果恰恰相反。我們不能僅僅擴大AlexNet的規模來得到更好的結果——我們必須處理特定的體系結構。有效的額外的計算, 不需要大量的資料樣本,才是努力的方向。

03 自動駕駛事故

迄今為止,對深度學習的聲譽打擊最大的事件來自自動駕駛領域。一開始人們認為End-to-End的深度學習可以以某種方式解決自動駕駛問題 (Nvidia特別推崇這一理念)。現在我覺得地球上應該沒有人還相信這一點(儘管我可能是錯的)。

看看去年加州車輛管理局DMV給各個廠商的自動駕駛車輛人為幹預報告,Nvidia的自動駕駛汽車在缺少人為幹預的情況下,連開10英里都做不到。

自2016年以來,特斯拉自動駕駛系統發生了幾起事故【6,7,8】,其中一些事件是致命的【6,7】。可以說,特斯拉的自動駕駛輔助技術不應該與自動駕駛混淆起來雖然在核心上它依賴於同一種技術。

都到今天了,它仍然不能自動停在路口,不能識別交通訊號燈,甚至不能透過環形交叉路口。那是在2018年5月,在承諾特斯拉將自動駕駛從西海岸開到東海岸的幾個月後(儘管傳言是他們已經嘗試過但是在小於30次人工幹預的情況下無法實現)。幾個月前(2018年2月),伊隆馬斯克(Elon Musk)在一次電話會議上被問及海岸到海岸的行駛問題時重覆說到:

我們本可以實現海岸到海岸的駕駛,但它需要太多的專門程式碼來有效地進行遊戲;或者使程式碼變得脆弱一些,這樣它只適用於一個特定的路線,這不是通用的解決方案。

我對神經網路方面取得的進展感到非常興奮。但是看起來並沒有太多的進展。它會覺得這是一個蹩腳的司機。就像…,好吧,這是一個非常好的司機。像“Holy Cow!”

那麼,看看上面的圖表(來自OpenAI),我似乎沒有看到指數級的進展。幾乎在這個領域的每一個科研人員在離開之前都沒有看到指數級的進展。實質上,上述說法應該被解釋為:“我們目前沒有可以安全地驅使我們實現岸到岸駕駛的技術,儘管如果我們真的想要(也許……)我們可以偽造它。我們深深地希望神經網路領域的蓬勃發展儘快到來,並幫助我們免受恥辱和大規模的訴訟“。

但是迄今為止,人工智慧泡沫中最大的刺點是Uber自駕車在亞利桑那州(Arizona)發生的撞死一名行人的事故。從NTSB的初步報告中,我們可以讀到一些令人驚訝的發言:

自動駕駛系統會將行人識別為一個機器,或者說一個交通工具,對其運動速度的判斷就會有問題,預留的減速時間就會出現問題,從而出現緊急情況。

在報告中,除了整體系統設計的明顯失敗,令人吃驚的是,系統花費了很長時間去確定前方的物體到底是什麼(行人、腳踏車、汽車或者其他),而不是作出判斷,保證不撞到它。主要有幾個原因:第一,人們通常會在事後表達他們當時的決定,例如,“我看到一個騎腳踏車的人,所以我轉向左邊避開他”。

大量的心理學研究提供了截然不同解釋:當一個人遇到這種情況,會在很短的時間內,透過神經反饋,將前方物體識別為障礙,並迅速行動,避開他。稍長時間後,他意識到剛才發生了什麼,並提供口頭解釋。

我們的許多決定裡,有很多都不是用語言表達的。語言表達的開銷很大,並且現實中通常沒有那麼充裕的時間。這些機製為了保護我們的安全,已經進化了10億年的時間,雖然仍然可能導致錯誤,但我們對三維空間、速度、預測行為的理解能力,已經透過進化過程,磨練的相當好了。

但是由於這些問題大多無法用語言來表達,並且很難測量,因此難以在這些方面對機器學習系統最佳化。這種情況非常有利於基於Nvidia的端到端方法的發展,透過學習影象到動作的對映,不考慮任何語言,從某種程度來說,這個方法沒有錯,但問題是,輸入空間的超高維變數和動作空間的低維標簽之間的差距非常大。

因此,與輸入的資訊量相比,“標簽”的數量非常小,在這種情況下,演演算法非常容易學習到虛假的關係,正如在深度學習中所舉得例子一樣,需要不同的正規化,將對輸入空間的感知能力作為第一步,使得系統能夠提取真實世界的語意特徵,而不是虛假的相關性。可以閱讀之前的文章【9】。

事實上,如果說我們從深度學習的爆髮式增長中學到了什麼的話,那就是高維影象空間中含有非常多的偽樣式,併在許多影象中進行了泛化,這就使分類器好像理解了它們所看到的圖片那樣。即使那些頂級研究人員亦不得不承認,事實並非如此。

需要提到的是,更高層的人正在意識到這種問題,並開始公開的批評它。最為活躍的要數Gary Marcus。雖然我並不認同Gary關於AI的所有觀點,但我們都認同,它還沒有像宣傳的那麼強大。他的博文Deeplearning: A critical appraisal【10】 和In defense of skepticism about deep learning【11】中,詳細的解釋了深度學習的宣傳過程。我很尊重Gary,他表現的就像一個真正的科學家,而很多深度學習名人,卻像是廉價的明星一樣。

結論

預測人工智慧的冬天就像是猜測股市崩盤一樣——不可能精確地知道發生的時間,但幾乎可以肯定會在某個時刻發生,就像股市崩盤之前,有跡象表明會發生危機,但在當時的環境中,卻很容易被大家忽視。

在我看來,深度學習已經出現了明顯的下降跡象。我並不知道這個冬天會有多“深度”,我也不知道接下來會發生什麼,但我可以肯定,這個冬天一定會來臨,並且只會來的比想象的要早。

參考資料:

1.https://blog.piekniewski.info/2016/08/12/how-close-are-we-to-vision/

2.https://twitter.com/lpachter/status/999772075622453249

3.https://blog.openai.com/dota-2/

4.https://www.theinformation.com/articles/deep-confusion-tensions-lingered-within-google-over-deepmind?shared=f86956392ee2b350Iss

5.https://qz.com/1186806/yann-lecun-is-stepping-down-as-facebooks-head-of-ai-research/

6.http://www.newsweek.com/autonomous-tesla-crashes-parked-fire-truck-california-freeway-789177

7.http://www.newsweek.com/tesla-model-s-crash-car-autopilot-sped-just-utah-firetruck-944251

8.https://www.zerohedge.com/news/2018-05-28/tesla-enthusiasts-european-model-3-tour-ends-when-autopilot-crashes-median

9.https://blog.piekniewski.info/2016/11/04/predictive-vision-in-a-nutshell/

10.https://arxiv.org/abs/1801.00631

11.https://medium.com/@GaryMarcus/in-defense-of-skepticism-about-deep-learning-6e8bfd5ae0f1

原文連結:

https://blog.piekniewski.info/2018/05/28/ai-winter-is-well-on-its-way/

推薦閱讀

Q: 你還看好AI的未來嗎?

歡迎留言與大家分享

覺得不錯,請把這篇文章分享給你的朋友

轉載 / 投稿請聯絡:baiyu@hzbook.com

更多精彩,請在後臺點選“歷史文章”檢視

知識星球

知識星球