關於作者:鄭在翔,現為南京大學自然語言處理實驗室二年級碩士生,將準備繼續攻讀自然語言處理方向的博士。當前主要研究方向為神經網路機器翻譯。

作者在本文記錄了自己在自然語言處理頂會 ACL 2018 的參會經歷,從個人的角度出發,介紹了會議內外的內容、感興趣的工作和研究熱點,並簡單敘述了其以論文作者身份第一次參加學術會議的一些感想。

2018 年 7 月 15 日至 20 日,自然語言處理領域的頂級會議 ACL 2018 在澳大利亞墨爾本舉行。本次大會共收到了 1018 篇長文和 526 篇短文的提交,相比去年有顯著的增長,在規模上是名副其實的學術界的盛會。其中,長文有 256 篇被錄用,錄用率為 25.1%;短文有 125 篇被錄用,錄用率為 23.8%;總體的錄用率為 24.7%。

本次會議還是產業界的盛會,共得到了來自全世界 28 家贊助商的大力贊助。近些年來,來自中國的企業對人工智慧領域學術會議的贊助熱情和規模逐年上漲,ACL 2018 的主要贊助商中,有 7 家來自中國,如位元組跳動(ByteDance)、百度、京東、騰訊等。其中位元組跳動公司與 Apple、Google 等公司同為本屆 ACL 的頂級贊助商,這也反應了中國企業和市場對於人工智慧學術前沿和產業化應用的關註。

由於筆者有一篇發表在 TACL (Transaction of ACL)上的論文有機會在此次 ACL 展示,所以非常幸運地能來到墨爾本參加此次的大會。作為一個第一次參加學術會議的小白,筆者在墨爾本的這短短七天不僅經歷了好多“第一次”,更得到了許許多多的收穫。在會議期間,不僅有機會可以和來自世界各地優秀的研究者請教交流,還能近距離瞭解人工智慧企業感興趣的問題。筆者在此想結合自己的參會經歷,和大家分享一下本次會議的見聞。

精彩的主會場

第一天是 Tutorial 環節。此次大會共設了 8 場 Tutorial,上午下午各 4 場。筆者參加了上午的 Neural Approaches to Conversational AI 和下午的 Deep Reinforcement Learning for NLP。兩個 Tutorial 深入淺出,非常精彩,並且都公開了報告的 slides。

▲ Williams Wang 老師在報告《Deep Reinforcement Learning for NLP》Tutorial

第二天日程由大會開幕式開始。在開幕式中,大會主席 Marti Hearst 宣佈成立 AACL(The Asia-Pacific Chapter of the ACL)的決定,引發現場一片歡呼。區別於現有的針對於歐洲地區的 EACL(The European Chapter of the ACL)和北美地區的 NAACL(The North American Chapter of the Association for Computational Linguistics),此次成立的 AACL 會主要聚焦於亞太地區。

新成立的 AACL 委員會由亞太地區該領域具有影響力的學者組成。其中,AACL 委員會主席(Chair)是來自百度公司的王海峰,候任主席(Chair-Elect)是來自臺灣資訊科學研究所的 Keh-Yih Su,秘書(Secretary)是來自清華大學的劉洋等。相信 AACL 的成立將會給亞太地區的自然語言處理的研究者又一個促進交流和學習的機會。

筆者在本次會議中看到,深度學習繼續在自然語言處理的領域中發揮著重要作用。正式會議的上午和下午是 Oral 報告。筆者和大家一樣,在各個不同 Track的會場奔波。Oral 的報告都非常有啟發性,如來自 Google AI 的工作 The Best of Both Worlds: Combining Recent Advances in Neural Machine Translation,透過將 RNN 的時序建模能力和 Transformer 中的“塊”的概念及最新的訓練技術結合起來,再次掃清了機器翻譯上的最佳效能,同時也給筆者很大啟發:雖然 Transformer 的提出使人們驚訝於 Self-Attention 賦予模型的效能,但是這不一定代表 RNN 的表達能力是弱於 Self-Attention 的;而在結合了 Transformer 中的一些最新的技術後,RNN 也表現出了更優越的效能,使人重新思考模型的表達能力與訓練之間關係。

▲ Google AI 的論文報告

雖然筆者的研究方向主要是機器翻譯,但也非常希望能從其他方向上的一些優秀論文也會中得到對自己研究的啟發。例如來自 FAIR 的工作 What you can cram into a single $&!#* vector: Probing sentence embeddings for linguistic properties,透過採用探測(probing)的方法,試圖“探測”出30個不同模型學到神經網路句子表示中究竟蘊含了什麼,比如句子的長度資訊和句法樹的深度等,給下游任務的研究者對句子表示的理解提供了新的視角。

和 Oral 報告一樣,在 Poster 環節中,筆者也更關註其他 NLP 方向的工作,希望能從其他得到啟發。筆者看到本次會議有許多工作都開始探索基於 Self-Attention 的方法來建模文字中的句子表示和依賴關係。如來自 Berkeley 的工作 Constituency Parsing with a Self-Attention Encoder,透過引入 Transformer 中的 Self-Attention 機制,並且發現原本的 Self-Attention 機制中將內容資訊和位置資訊結合起來建模可能存在問題,提出了一種將內容和位置資訊分解的方式,在成分句法分析(Constituency Parsing)上得到了 state-of-the-art 的效能。筆者還向作者詢問了有關位置資訊編碼的問題,也得到了耐心的解答。

除此之外,筆者還發現,生成對抗網路和強化學習在很多工作中得到應用,這也表現了未來一段時間的研究熱點和趨勢。另外,研究如何將人類總結的知識和自然語言處理中的深度學習模型結合起來,向模型提供更多的先驗知識的工作也在逐漸增多。

筆者有幸在此有一篇論文 Modeling Past and Future for Neural Machine Translation 作為 Poster 展示。這篇工作主要的動機是源於在通常的神經機器翻譯的翻譯結果中觀察到的漏翻譯和重覆翻譯現象。於是我們試圖在解碼階段更顯式地建模和學習到翻譯的歷史和未來資訊的表示,希望能為當前一步翻譯的註意力機制和單詞預測提供更加豐富的標的端背景關係,從而希望能避免翻譯模型做出遺漏或者重覆的決策。

由於是作為小白的筆者第一次在學術會議上做 Poster,並且需要使用英語,對口語不是很自信的我一度非常緊張。當天中午筆者連午飯都來不及吃,就匆匆守到了我們的展板,內心十分忐忑,擔心自己不能很好地向對我們工作感興趣的研究者解答他們的疑惑和表達自己的觀點。

本文的共同第一作者、現在在位元組跳動人工智慧實驗室工作的師兄看出了筆者的緊張,就向我介紹了他的經驗。在實驗設計和論文撰寫時,師兄就提出了非常多有深度的見解,為這篇工作做出了主要貢獻。在他的鼓勵下,我的情緒得以稍稍緩解。當真正開始向源源不斷過來的人講解自己的工作的時候,筆者反而就忘記了緊張這回事了,投入到了和大家的交流過程中。面對各種各樣的問題,筆者只好不停地“freestyle”。幸運的是,每個人都很有耐心地和我進行反覆的討論。透過和大家的交流,不僅收穫了很多啟發和建議,也鍛煉了自己的表達和膽量,為自己積累了寶貴的經驗。

此次會議評選出了 3 篇最佳長論文和 2 篇最佳短論文,共計 5 篇,併在閉幕式前進行報告。其中,最佳長論文為:

1. Finding syntax in human encephalography with beam search. John Hale, Chris Dyer, Adhiguna Kuncoro and Jonathan Brennan.

2. Learning to Ask Good Questions: Ranking Clarification Questions using Neural Expected Value of Perfect Information. Sudha Rao and Hal Daumé III.

3. Let’s do it “again”: A First Computational Approach to Detecting Adverbial Presupposition Triggers. Andre Cianflone, Yulan Feng, Jad Kabbara and Jackie Chi Kit Cheung.

最佳短論文為:

1. Know What You Don’t Know: Unanswerable Questions for SQuAD. Pranav Rajpurkar, Robin Jia and Percy Liang

2. Lighter’ Can Still Be Dark: Modeling Comparative Color Descriptions. Olivia Winn and Smaranda Muresan

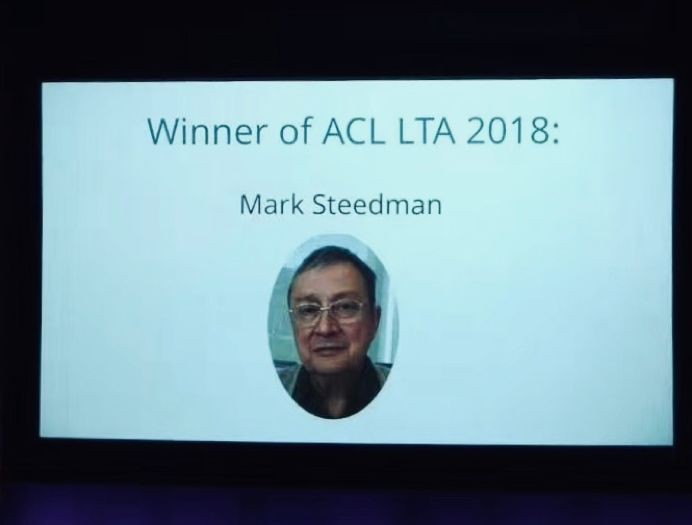

在閉幕式上,大會將 ACL 終身成就獎(Lifetime Achievement Award)頒發給了 University of Edinburgh 的 Mark Steedman 教授,感謝其對計算語言學、人工智慧和認知科學作出的貢獻。

▲ ACL終身成就獎獲得者Mark Steedman教授

會場之外

在休息時走出報告的會場,可以看到有很多企業的展臺,其中許多企業透過各種形式的 DEMO 來展示自己的技術和業務,讓參會者們有機會瞭解到產業界的狀況和關心的問題。 例如旗下有今日頭條、抖音等產品的位元組跳動(ByteDance)公司,他們以小明機器人(Xiaoming Bot) 為世界盃比賽自動寫稿為例,展示了計算機視覺與自然語言處理技術的結合。其中,小明機器人首先透過基於計算機視覺的足球比賽理解技術能對影片中的球員、足球甚至人物的表情進行實時的追蹤、分割和理解,而後結合自然語言處理技術自動生成圖文並茂的新聞稿。

除此之外還看到相關人員在演示位元組跳動支援多個語種的機器翻譯系統。作為近些年來國內發展迅猛的 AI 企業,它的產品和機構也在積極地進行全球化運作。除了短影片軟體抖音等在海外市場的驚人擴張外,它在美國矽谷、西雅圖等地都設立了國際化的 AI 實驗室,從而希望能招攬世界各地的行業精英。

筆者還有幸分別參加了百度公司和 CCF 青工委,以及位元組跳動組織的晚宴。在百度公司和青工委組織的晚宴上,微軟亞洲研究院副院長周明老師回顧了中國自然語言處理髮展的歷史,讓我們這些晚輩對從那個年代的艱難起一路堅持走來的學術先行者們的敬意油然而生。展望未來,周明老師說:“在 NLP 的頂會上,中國和美國發表的論文數量很接近,我們下一步的標的,不光做更多的工作,還要做更好的工作,做更多有挑戰的問題,為人類的文明作出貢獻。”位元組跳動晚宴邀請了很多國內外知名學者,李航老師現在在位元組跳動人工智慧實驗室工作,這次晚宴是由他主持。從演講瞭解到這是一個飛速發展的公司,在 NLP 領域已經有很多的應用,同時也正在招募更多技術人才加入他們。

除了在大會現場搭建展臺和學者們交流外,筆者也看到多家中國企業,如阿裡巴巴、百度、騰訊、京東、訊飛等,在主會場和最後兩天的 Workshop 中積極展示來自企業的工作發表及研究成果。一段時間以來,這些 AI 相關的企業都在大力佈局人工智慧,透過對產業界中發現的實際問題進行研究和解決,表現出對前沿學術研究的空前熱情,也使得學術界能更直接地瞭解到產業界關心的問題,對整個人工智慧領域的健康發展起到了重要的作用。

寫在最後

短短幾日的 ACL 2018 之旅就要結束了,這幾日經筆者歷了無數的“第一次”:第一次參加學術會議,第一次在會議上作 Poster 展示,第一次鼓起勇氣向 Christopher Manning 教授請教問題,第一次走在路上被墨爾本突如其來的冰雹襲擊等。我感覺對我來說最大的收穫除了各個學術上的報告外,就是學會傾聽別人的想法和努力表達自己的想法。

相信很多小夥伴一開始的時候也向筆者一樣,對自己的聽力和表達不自信,擔心無法和來自世界各地的研究者交流。但當筆者真正專註進這個事情,渴望就自己感興趣的話題交換想法時,就發現這些都不再成為溝通的障礙了。在開會期間遇見了太多太多優秀的同齡人,他們對研究理解很深入,對問題的看法頗有遠見,這也激勵筆者要多多提高自己,努力向優秀的同齡人看齊。以上是筆者參加 ACL 2018 的一些見聞和淺薄的見解,希望自己將來也能做出有意義的工作,再次有機會和世界各地的學者交流。

關於PaperWeekly

PaperWeekly 是一個推薦、解讀、討論、報道人工智慧前沿論文成果的學術平臺。如果你研究或從事 AI 領域,歡迎在公眾號後臺點選「交流群」,小助手將把你帶入 PaperWeekly 的交流群裡。

▽ 點選 | 閱讀原文 | 加入社群刷論文

知識星球

知識星球