(點選上方公眾號,可快速關註)

轉自:JerryLead

http://www.cnblogs.com/jerrylead/archive/2011/04/06/2006924.html

這篇討論使用期望最大化演演算法(Expectation-Maximization)來進行密度估計(density estimation)。

與k-means一樣,給定的訓練樣本是![]() ,我們將隱含類別標簽用

,我們將隱含類別標簽用![]() 表示。與k-means的硬指定不同,我們首先認為

表示。與k-means的硬指定不同,我們首先認為![]() 是滿足一定的機率分佈的,這裡我們認為滿足多項式分佈,

是滿足一定的機率分佈的,這裡我們認為滿足多項式分佈,![]() ,其中

,其中![]() ,

,![]() 有k個值{1,…,k}可以選取。

有k個值{1,…,k}可以選取。

而且我們認為在給定![]() 後,

後,![]() 滿足多值高斯分佈,即

滿足多值高斯分佈,即![]() 。由此可以得到聯合分佈

。由此可以得到聯合分佈![]() 。

。

整個模型簡單描述為對於每個樣例![]() ,我們先從k個類別中按多項式分佈抽取一個

,我們先從k個類別中按多項式分佈抽取一個![]() ,然後根據

,然後根據![]() 所對應的k個多值高斯分佈中的一個生成樣例

所對應的k個多值高斯分佈中的一個生成樣例![]() ,。

,。

整個過程稱作混合高斯模型。註意的是這裡的![]() 仍然是隱含隨機變數。模型中還有三個變數

仍然是隱含隨機變數。模型中還有三個變數![]() 和

和![]() 。最大似然估計為

。最大似然估計為![]() 。對數化後如下:

。對數化後如下:

這個式子的最大值是不能透過前面使用的求導數為0的方法解決的,因為求的結果不是close form。但是假設我們知道了每個樣例的![]() ,那麼上式可以簡化為:

,那麼上式可以簡化為:

這時候我們再來對![]() 和

和![]() 進行求導得到:

進行求導得到:

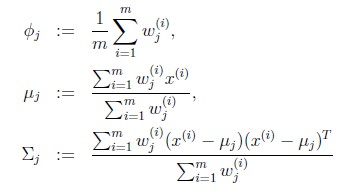

![]() 就是樣本類別中

就是樣本類別中![]() 的比率。

的比率。![]() 是類別為j的樣本特徵均值,

是類別為j的樣本特徵均值,![]() 是類別為j的樣例的特徵的協方差矩陣。

是類別為j的樣例的特徵的協方差矩陣。

實際上,當知道![]() 後,最大似然估計就近似於高斯判別分析模型(Gaussian discriminant analysis model)了。所不同的是GDA中類別y是伯努利分佈,而這裡的z是多項式分佈,還有這裡的每個樣例都有不同的協方差矩陣,而GDA中認為只有一個。

後,最大似然估計就近似於高斯判別分析模型(Gaussian discriminant analysis model)了。所不同的是GDA中類別y是伯努利分佈,而這裡的z是多項式分佈,還有這裡的每個樣例都有不同的協方差矩陣,而GDA中認為只有一個。

之前我們是假設給定了![]() ,實際上

,實際上![]() 是不知道的。那麼怎麼辦呢?考慮之前提到的EM的思想,第一步是猜測隱含類別變數z,第二步是更新其他引數,以獲得最大的最大似然估計。用到這裡就是:

是不知道的。那麼怎麼辦呢?考慮之前提到的EM的思想,第一步是猜測隱含類別變數z,第二步是更新其他引數,以獲得最大的最大似然估計。用到這裡就是:

|

迴圈下麵步驟,直到收斂: { (E步)對於每一個i和j,計算 (M步),更新引數: } |

在E步中,我們將其他引數![]() 看作常量,計算

看作常量,計算![]() 的後驗機率,也就是估計隱含類別變數。估計好後,利用上面的公式重新計算其他引數,計算好後發現最大化最大似然估計時,

的後驗機率,也就是估計隱含類別變數。估計好後,利用上面的公式重新計算其他引數,計算好後發現最大化最大似然估計時,![]() 值又不對了,需要重新計算,周而複始,直至收斂。

值又不對了,需要重新計算,周而複始,直至收斂。

![]() 的具體計算公式如下:

的具體計算公式如下:

這個式子利用了貝葉斯公式。

這裡我們使用![]() 代替了前面的

代替了前面的![]() ,由簡單的0/1值變成了機率值。

,由簡單的0/1值變成了機率值。

對比K-means可以發現,這裡使用了“軟”指定,為每個樣例分配的類別![]() 是有一定的機率的,同時計算量也變大了,每個樣例i都要計算屬於每一個類別j的機率。

是有一定的機率的,同時計算量也變大了,每個樣例i都要計算屬於每一個類別j的機率。

與K-means相同的是,結果仍然是區域性最優解。對其他引數取不同的初始值進行多次計算不失為一種好方法。

雖然之前再K-means中定性描述了EM的收斂性,仍然沒有定量地給出,還有一般化EM的推導過程仍然沒有給出。下一篇著重介紹這些內容。

覺得本文有幫助?請分享給更多人

關註「演演算法愛好者」,修煉程式設計內功

淘口令:複製以下紅色內容,再開啟手淘即可購買

範品社,使用¥極客T恤¥搶先預覽(長按複製整段文案,開啟手機淘寶即可進入活動內容)

近期,北京地區正常發貨,但派件時間有所延長。

知識星球

知識星球