3月11日訊息,英偉達官方宣佈已經達成協議,以69億美元現金收購以色列晶片商Mellanox Technologies。這是英偉達史上最大規模的一筆收購交易。

此前,微軟賽靈思英特爾均參與了Mellanox的競購,收購價預計在50-60億美元區間。彭博社稱,英偉達正在為這家以色列公司支付每股125美元的現金,該公司生產的晶片用於加速計算機伺服器之間的資訊流動。這比其週五收盤價109.38美元溢價14%。

英偉達表示,一旦收購完成,該組合預計將立即增加利潤和自由現金流。這個價值69億美元的收購案是英偉達有史以來最貴的一筆交易。

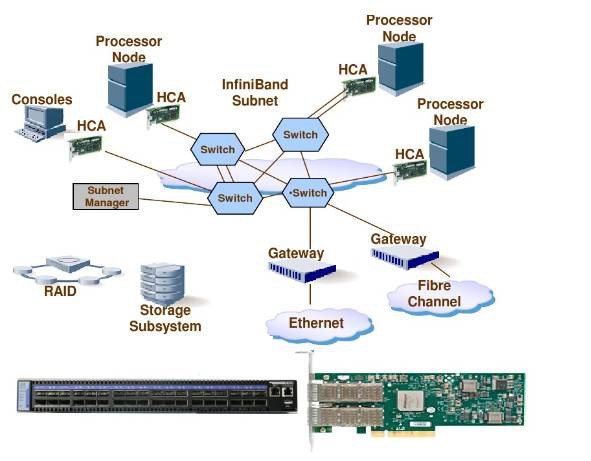

Mellanox成立於1999年,總部設在美國加州和以色列,Mellanox公司是伺服器和儲存端到端連線InfiniBand解決方案的領先供應商。2010年底Mellanox完成了對著名Infiniband交換機廠商Voltaire公司的收購工作,使得Mellanox在HPC、雲端計算、資料中心、企業計算及儲存市場上獲得了更為全面的能力,下麵就談談Mellanox的產品和技術。

IB 網路和拓撲組成

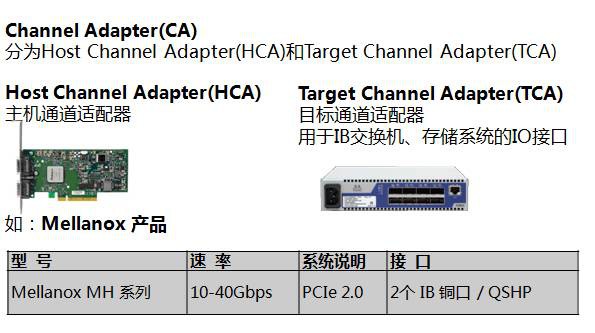

InfiniBand結構基於通道的串列埠替代共用匯流排,從而使I/O子系統和CPU/記憶體分離。所有系統和節點可透過通道配接器邏輯連線到該結構,它們可以是主機、配接器(HCA)或標的配接器(TCA),還包括InfiniBand交換機和路由器擴充套件,從而滿足不斷增長的需求。

InfiniBand也是一種分層協議(類似TCP/IP協議),每層負責不同的功能,下層為上層服務,不同層次相互獨立,每一層提供相應功能。InfiniBand協議可滿足各種不同的需求,包括組播、分割槽、IP相容性、流控制和速率控制等。

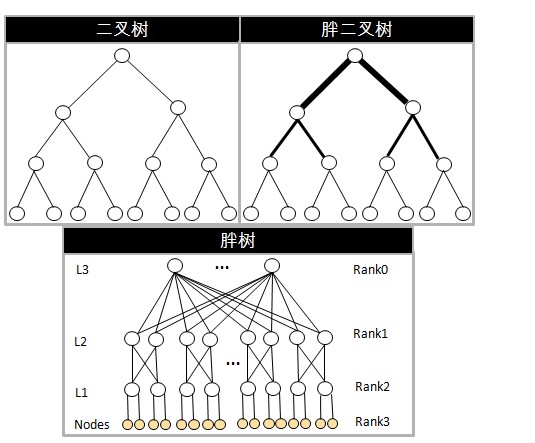

InfiniBand網路路由演演算法包括最短路徑演演算法、基於Min Hop的UPDN 演演算法和基於Fat Tree組網FatTree演演算法。

演演算法在一定程度上也決定了InfiniBand網路拓撲結構,尤其在高效能運算、大型集群系統,必須要考慮網路之間的拓撲結構,網路上行和下行鏈路阻塞情況也決定著整個網路效能。由於樹形拓撲結構具備清晰、易構建和管理的有點,故而胖樹網路拓撲結構常常被採用,以便能夠發揮出InfiniBand網路優勢,也通常應用在無阻塞或阻塞率很低的應用場景,所以我們下麵我們重點討論下。

在傳統的三層組網架構中(二層架構也經常用到),由於接入層節點數量龐大,所以要求匯聚層或核心層的網路頻寬和處理能力與之匹配,否則設計出來的網路拓撲結構就會產生一定的阻塞比。

為瞭解決這一問題,在匯聚層和核心層就要採用胖節點組網(如果採用瘦節點就一定發生阻塞,且三層組網阻塞比二層組網更加嚴重),如上圖胖二叉樹事例,胖節點(Fat Tree)必須提供足夠的網路埠和頻寬與葉子節點匹配。

採用胖樹拓撲網路的結構一般由葉子(Leaf)和主幹(Spine)交換機組成,葉子交換機與伺服器或儲存等通道適配卡相連,分配一部分埠給節點,另一部分埠被接入網路中。在InfiniBand網路中Fat Tree組網結構具有下麵幾個特點。

- 連線到同一端Switch的埠叫埠組,同一Rank級別的Switch必須有相同的上行埠組,且根Rank沒有上行埠組;除了Leaf Switch,同一Rank的Switch必須有相同的下行埠組。

- 同一Rank的每個上行埠組中埠個數相同;且同一Rank的每個下行埠組中埠個數也相同。

- 所有終端節點的HCA卡都在同一Rank級別上。

上圖是一個採用二層架構的無阻塞Fat Tree組網事例,接入層下行提供1296個IB埠給伺服器或儲存適配卡,上行也提供配接器給匯聚層。但從一個接入IB交換機來看,上行和下行分別提供18個介面實現無阻塞組網。胖樹拓撲結構一方面提供費阻塞資料傳輸,另一方面提供網路冗餘增強網路可靠性。

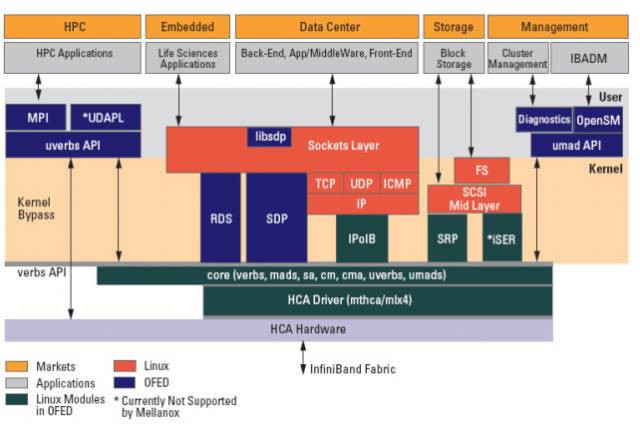

軟體協議棧OFED

為伺服器和儲存叢集提供低延遲和高頻寬的企業資料中心(EDC),高效能運算(HPC)和嵌入式應用環境。 Mellanox所有適配卡與基於Open Fabrics的RDMA協議和軟體相容。2004年OpenFabrics Alliance成立,該組織致力於促進RDMA 網路交換技術的發展。2005年,OpenFabrics Alliance釋出了第一個版本的OFED (OpenFabrics Enterprise Distribution)。

Mellanox OFED是一個單一的軟體堆疊,包括驅動、中介軟體、使用者介面,以及一系列的標準協議IPoIB、SDP、SRP、iSER、RDS、DAPL(Direct Access Programming Library),支援MPI、Lustre/NFS over RDMA等協議,並提供Verbs程式設計介面;Mellanox OFED由開源OpenFabrics組織維護。

如果前面的軟體堆疊邏輯圖過於複雜,可以參考上面的簡明介紹圖。Mellanox OFED for Linux (MLNX_OFED_LINUX) 作為ISO映像提供,每個Linux發行版,包括原始碼和二進位制RPM包、韌體、實用程式、安裝指令碼和檔案。

InfiniBand網路管理

OpenSM軟體是符合InfiniBand的子網管理器(SM),執行在Mellanox OFED軟體堆疊進行IB 網路管理,管理控制流走業務通道,屬於帶內管理方式。

OpenSM包括子網管理器、背板管理器和效能管理器三個元件,系結在交換機內部的必備部件。提供非常完備的管理和監控能力,如裝置自動發現、裝置管理、Fabric視覺化、智慧分析、健康監測等等。

平行計算叢集計算

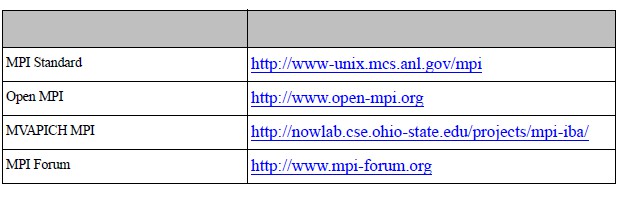

MPI (Message Passing Interface) 用於並行程式設計的一個規範,並行程式設計即使用多個CPU來平行計算,提升計算能力。Mellanox OFED for Linux的InfiniBand MPI實現包括Open MPI和OSU MVAPICH。

Open MPI是基於Open MPI專案的開源MPI-2實現,OSU MVAPICH是基於俄亥俄州立大學的MPI-1實施。下麵列出了一些有用的MPI連結。

RDS (Reliable Datagram Socket)是一種套接字API,在sockets over RC or TCP/IP之間提供可靠的按順序資料報傳送,RDS適用於Oracle RAC 11g。

基於Socket網路應用能力

IPoIB/ EoIB (IP/Eth over InfiniBand) 是透過InfiniBand實現的網路介面實現,IPoIB封裝IP資料報透過InfiniBand連線或資料報傳輸服務。

SDP (Socket Direct Protocol) 是提供TCP的InfiniBand位元組流傳輸協議流語意,利用InfiniBand的高階協議解除安裝功能,SDP可以提供更低的延遲更高頻寬。

儲存支援能力

支援iSER (iSCSI Extensions for RDMA)和NFSoRDMA (NFS over RDMA),SRP (SCSI RDMA Protocol) 是InfiniBand中的一種通訊協議,在InfiniBand中將SCSI命令進行打包,允許SCSI命令透過RDMA(遠端直接記憶體訪問)在不同的系統之間進行通訊,實現儲存裝置共享和RDMA通訊服務。

RDMA (Remote Direct Memory Access)技術是為瞭解決網路傳輸中伺服器端資料處理的延遲而產生的。RDMA透過網路把資料直接傳入計算機的儲存區,將資料從一個系統快速移動到遠端系統儲存器中,而不對作業系統造成任何影響,這樣就不需要用到多少計算機的處理功能。它消除了外部儲存器複製和文字交換操作,因而釋放記憶體頻寬和CPU週期用於改進應用系統效能。

Mellanox產品介紹

Mellanox是伺服器和儲存端到端連線解決方案的領先供應商,一直致力於InfiniBand和乙太網互聯產品的研發工作,也是業界公認的超高速網路典型代表。下麵我們重點看看InfiniBand和相關產品介紹。

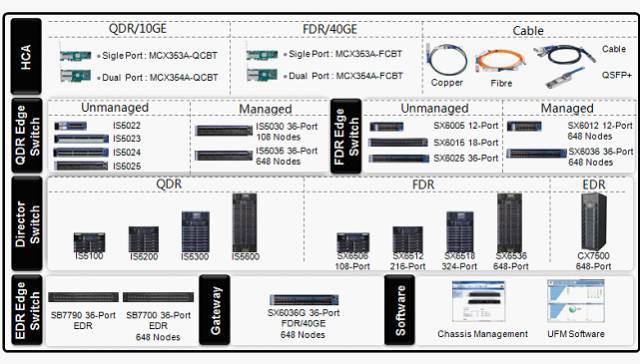

InfiniBand產品搭配先進的VPI技術使得單埠適配業務需求,主要產品包括VPI系列網絡卡、交換機。晶片產品也是保障所有系列產品的可靠基石。種類豐富的線纜是實現高速網際網路絡的重要保證。除了硬體外,InfiniBand配套加速軟體和統一管理軟體豐富整個產品家族(說明: 產品資料為來得及更新,最新產品請登入官網檢視)。

Infiniband交換機

在IB網路內提供點到點高速通訊;基於LID技術將資料從一個埠送到另外一個埠 ,當前單個交換機支援從18到864節點等規模不等,支援SDR(10Gbps)、DDR(20Gbps)、QDR(40Gbps)、FDR10(40Gbps)、FDR(56Gbps)等。

從SwitchX 到Switch IB,SwitchX是支援10、20、40、56 G IB主流的晶片,下一代晶片Switch IB支援IB EDR 100Gb/s,並且向前相容,後面還有SwitchX3支援100G和IB EDR。

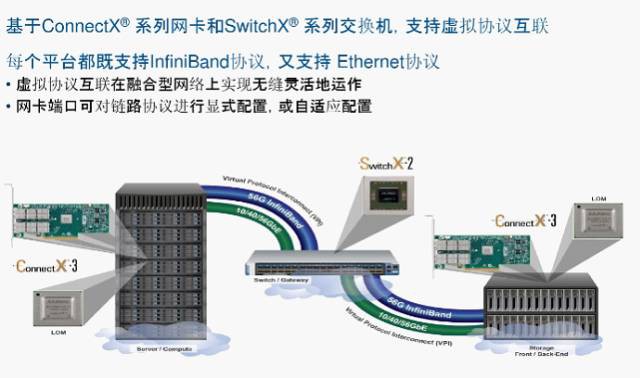

基於ConnectX系列網絡卡和SwitchX交換機可以實現乙太網和IB網路的虛擬協議互聯(VPI),實現鏈路協議顯示或自動適配,一個物理交換機實現多種技術支援。虛擬協議互聯支援整機VPI、埠VPI和VPI橋接,整機VPI實現交換機所有埠執行在InfiniBand或乙太網樣式,埠VPI實現交換機部分埠執行InfiniBand、部分埠執行乙太網樣式,VPI橋接樣式實現InfiniBand和乙太網橋接。

邊緣(機架) InfiniBand交換機系統支援8到36埠,提供非阻塞40到100Gb 埠,在1U的空間可提供7.2Tb的頻寬,這些邊緣交換機是組成中小型費阻塞網路叢集Leaf節點的理想選擇。邊緣交換機使用先進的InfiniBand交換技術(如自適應路由、擁塞控制和服務質量等)旨在構建最有效的交換矩陣。

核心InfiniBand交換機系統支援108至648埠,提供全雙向40至100Gb埠, InfiniBand核心交換機系統提供高密的解決方案,在一個機框內頻寬可以8.4Tb至130Tb之間靈活擴充套件,可達數千個埠。針對關鍵任務應用,InfiniBand核心交換機提供核心級可用性,系統所有部件都採用冗餘技術設計。

InfiniBand配接器

Inifiniband的主機通道配接器HCA(網路介面卡),通常透過PCIE介面與主機連線,插在或整合在伺服器內;支援PCI-E 8X插槽(雙埠和單埠)。提供Inifiniband的網路鏈路接入能力。等同於乙太網的NIC。HCA包含三代晶片:目前主流的QDR,FDR使用的晶片為ConnectX3,OSCA使用的也是ConnectX3。

標的通道配接器(TCA)提供InfiniBand到I/O裝置的連線,系結在儲存或閘道器裝置等外設。

Infiniband路由器和閘道器

Infiniband路由器完成不同子網的infiniband報文的轉發。Mellanox的SB7780是基於Switch-IB交換機ASIC實現的InfiniBand路由器,提供EDR 100Gb s埠可以連線不同型別的拓撲。因此,它能夠使每個子網拓撲最大化每個應用程式的效能。例如,儲存子網可以使用Fat Tree拓撲,而計運算元網可以使用最適合本地應用程式的環路拓撲。

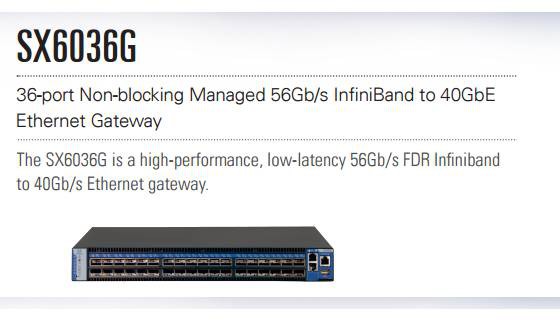

SX6036G是採用Mellanox第六代SwitchX 2 InfiniBand構建的交換機閘道器裝置,提供高效能、低延遲的56Gb FDR Infiniband到40Gb乙太網的閘道器,支援InfiniBand和乙太網連線的虛擬協議互連(VPI)技術,VPI透過一個硬體平臺能夠在同一機箱上執行InfiniBand和乙太網網路協議。

Infiniband線纜和收發器

Mellanox LinkX互連產品包括10、25、40、50和100 Gb/s豐富銅纜、有源光纜以及針對單模光纖和多模光纖應用的收發器。

LinkX系列提供200Gb/s和400Gb/s電纜和收發器等關鍵元件,對於InfiniBand互連基礎設施來說,讓端到端的200Gb/s解決方案成為可能。當然Mellanox是網路和互聯解決方案供應商,所以其技術和產品也不只是InfiniBand。

知識星球

知識星球