硬碟是大家都很熟悉的裝置,一路走來,從HDD到SSD,從SATA到NVMe,作為NVMe SSD的前端介面,PCIe再次進入我們的視野。作為x86體系關鍵的一環,PCIe標準歷經PCI,PCI-X和PCIe,走過近30年時光。其中Host發現與查詢裝置的方式卻一脈沿襲,今天我們先來聊一聊PCIe裝置在一個系統中是如何發現與訪問的。

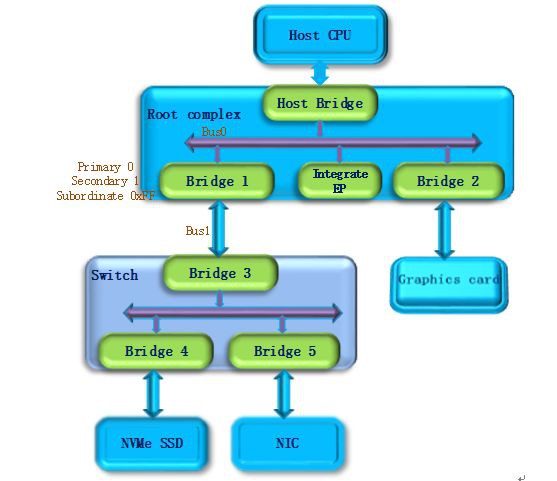

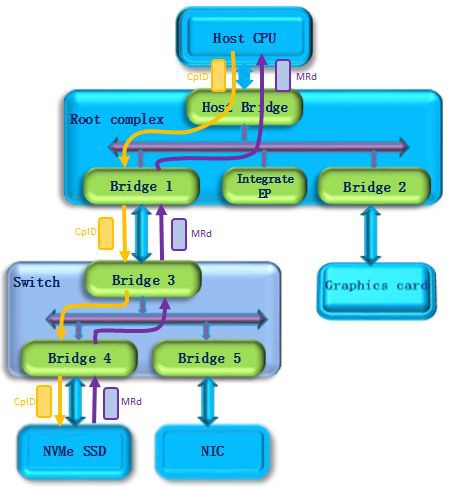

首先我們來看一下在x86系統中,PCIe是什麼樣的一個體系架構。下圖是一個PCIe的拓撲結構示例,PCIe協議支援256個Bus, 每條Bus最多支援32個Device,每個Device最多支援8個Function,所以由BDF(Bus,device,function)構成了每個PCIe裝置節點的身份證號。

PCIe體系架構一般由root complex,switch,endpoint等型別的PCIe裝置組成,在root complex和switch中通常會有一些embeded endpoint(這種裝置對外不出PCIe介面)。這麼多的裝置,CPU啟動後要怎麼去找到並認出它們呢? Host對PCIe裝置掃描是採用了深度優先演演算法,其過程簡要來說是對每一個可能的分支路徑深入到不能再深入為止,而且每個節點只能訪問一次。我們一般稱這個過程為PCIe裝置列舉。列舉過程中host透過配置讀事物包來獲取下游裝置的資訊,透過配置寫事物包對下游裝置進行設定。

第一步,PCI Host主橋掃描Bus 0上的裝置(在一個處理器系統中,一般將Root complex中與Host Bridge相連線的PCI匯流排命名為PCI Bus 0),系統首先會忽略Bus 0上的embedded EP等不會掛接PCI橋的裝置,主橋發現Bridge 1後,將Bridge1 下麵的PCI Bus定為 Bus 1,系統將初始化Bridge 1的配置空間,並將該橋的Primary Bus Number 和 Secondary Bus Number暫存器分別設定成0和1,以表明Bridge1 的上游匯流排是0,下游匯流排是1,由於還無法確定Bridge1下掛載裝置的具體情況,系統先暫時將Subordinate Bus Number設為0xFF。

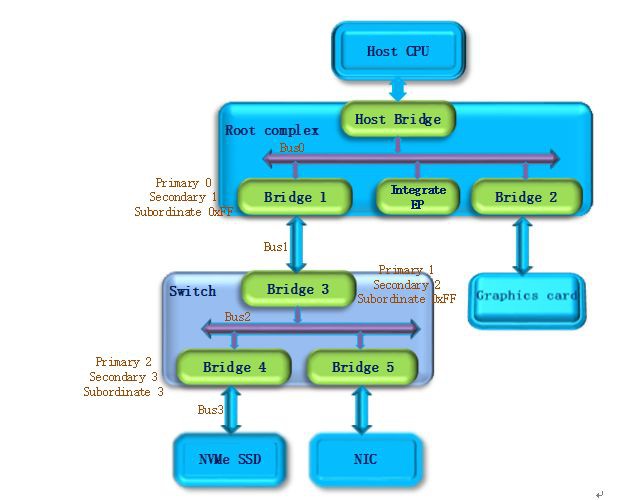

第二步,系統開始掃描Bus 1,將會發現Bridge 3,併發現這是一個switch裝置。系統將Bridge 3下麵的PCI Bus定為Bus 2,並將該橋的Primary Bus Number 和 Secondary Bus Number暫存器分別設定成1和2,和上一步一樣暫時把Bridge 3 的Subordinate Bus Number設為0xFF。

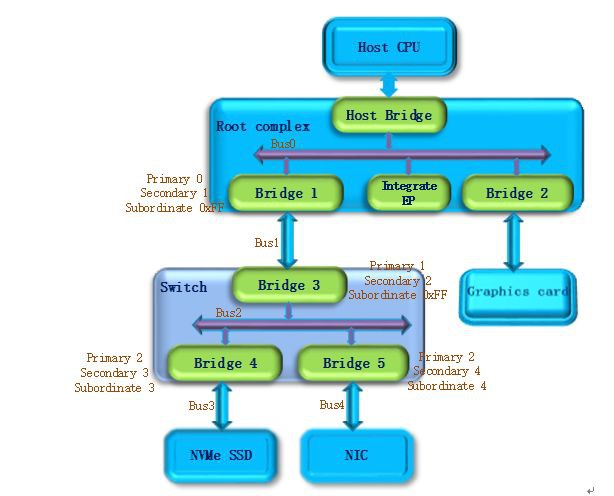

第三步,系統繼續掃描Bus 2,將會發現Bridge 4。繼續掃描,系統會發現Bridge下麵掛載的NVMe SSD裝置,系統將Bridge 4下麵的PCI Bus定為Bus 3,並將該橋的Primary Bus Number 和 Secondary Bus Number暫存器分別設定成2和3,因為Bus3下麵掛的是端點裝置(葉子節點),下麵不會再有下游匯流排了,因此Bridge 4的Subordinate Bus Number的值可以確定為3。

第四步,完成Bus 3的掃描後,系統傳回到Bus 2繼續掃描,會發現Bridge 5。繼續掃描,系統會發現下麵掛載的NIC裝置,系統將Bridge 5下麵的PCI Bus設定為Bus 4,並將該橋的Primary Bus Number 和 Secondary Bus Number暫存器分別設定成2和4,因為NIC同樣是端點裝置,Bridge 5的Subordinate Bus Number的值可以確定為4。

第五步,除了Bridge 4和Bridge 5以外,Bus2下麵沒有其他裝置了,因此傳回到Bridge 3,Bus 4是找到的掛載在這個Bridge下的最後一個bus號,因此將Bridge 3的Subordinate Bus Number設定為4。Bridge 3的下游裝置都已經掃描完畢,繼續向上傳回到Bridge 1,同樣將Bridge 1的Subordinate Bus Number設定為4。

第六步,系統傳回到Bus0繼續掃描,會發現Bridge 2,系統將Bridge 2下麵的PCI Bus定為Bus 5。並將Bridge 2的Primary Bus Number 和 Secondary Bus Number暫存器分別設定成0和5, Graphics card也是端點裝置,因此Bridge 2 的Subordinate Bus Number的值可以確定為5。

至此,掛在PCIe匯流排上的所有裝置都被掃描到,列舉過程結束,Host透過這一過程獲得了一個完整的PCIe裝置拓撲結構。

系統上電以後,host會自動完成上述的裝置列舉過程。除一些專有系統外,普通系統只會在開機階段進行進行裝置的掃描,啟動成功後(列舉過程結束),即使插入一個PCIe裝置,系統也不會再去識別它。

在linux作業系統中,我們可以透過lspci –v -t命令來查詢系統上電階段掃描到的PCIe裝置,執行結果會以一個樹的形式列出系統中所有的pcie裝置。如下圖所示,其中黃色方框中的PCIe裝置是北京憶芯科技公司(Bejing Starblaze Technology Co., LTD.)推出的STAR1000系列NVMe SSD主控晶片,圖中顯示的9d32是Starblaze在PCI-SIG組織的註冊碼,1000是裝置系列號。

STAR1000裝置的BDF也可以從上圖中找出,其中bus是0x3C,device是0x00,function是0x0,BDF表示為3C:00.0,與之對應的上游埠是00:1d.0。

我們可以透過“lspci –xxx –s 3C:00.0”命令來列出該裝置的PCIe詳細資訊(技術發燒友或數字控請關註該部分)。這些內容儲存在PCIe配置空間,它們描述的是PCIe本身的特性。如下圖所示(低位地址0x00在最左邊),可以看到這是一個非易失性儲存控制器,0x00起始地址是PCIe的Vendor ID和Device ID。Class code 0x010802表示這是一個NVMe儲存裝置。0x40是第一組capability的指標,如果你需要檢視PCIe的特性,就需要從這個位置開始去查詢,在每組特徵的頭欄位都會給出下一組特性的起始地址。從0x40地址開始依次是power management,MSI中斷,鏈路控制與狀態,MSI-X中斷等特性組。這兒特別列出了鏈路特徵中的一個0x43欄位,表示STAR1000裝置是一個x4lane的連結,支援PCIe Gen3速率(8Gbps)。

當然也可以使用lspci –vvv –s 3C:00.0命令來檢視裝置特性,初學者看到下麵的串列也就一目瞭然了。

Host在列舉裝置的同時也會對裝置進行配置,每個PCIe裝置都會指定一段CPU memory訪問空間,從上面的圖中我們可以看到這個裝置支援兩段訪問空間,一段的大小是1M byte,另一段的大小是256K byte,系統會分別指定它們的基地址。基地址配置完成以後,Host就可以透過地址來對PCIe memory空間進行訪問了。

PCIe memory空間關聯的是PCIe裝置物理功能,對於STAR1000系列晶片而言,物理功能是NVMe,memory中存放的是NMVe的控制與狀態資訊,對於NMVe的控制以及工作狀態的獲取,都需要透過memory訪問來實現。

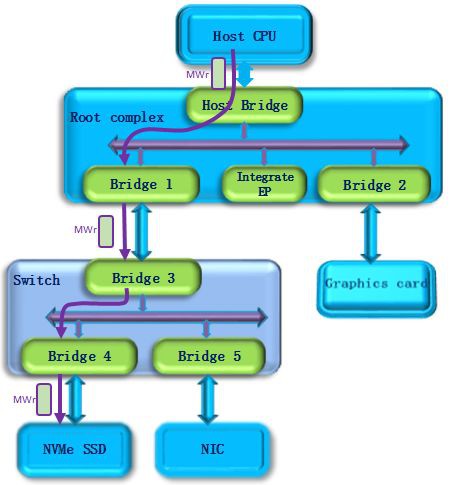

下麵以NVMe命令下發為例簡單描述PCIe裝置的memory訪問。NVMe命令下發的基本操作是1)Host寫doorbell暫存器,此時使用PCIe memory寫請求。如下圖所示,host發出一個memory write(MWr)請求,該請求經過switch到達要訪問的NVMe SSD裝置。

這個請求會被端點裝置接收並執行2)NVMe讀取命令操作。如下圖所示,此時NVMe SSD作為請求者,發出一個memory read(MRd)請求,該請求經過Switch到達Host,Host作為完成者會傳回一個完成事物包(CplD),將訪問結果傳回給NVMe SSD。

這樣,一個NVMe的命令下發過程就完成了。同樣,NVMe的其他操作比如各種佇列操作,命令與完成,資料傳輸都是透過PCIe memory訪問的方式進行的,此處不再詳述。

透過上面的描述,相信能夠幫助大家瞭解PCIe的裝置列舉和memory空間訪問。以後會繼續與大家探討PCIe的其他內容,比如PCIe的協議分層,鏈路建立,功耗管理等等。目前PCIe協議還正在不斷的快速演進中,2017年釋出的PCIe Gen4標準,每條Serdes支援的速率已經達到16Gbps,Gen5也在加速制定中,其速率會再翻一倍達到32Gbps。Starblaze會緊跟技術的發展趨勢,提供速率更高,效能更好更穩定的NVMe SSD系列產品。

來源:SSDFans公眾號

知識星球

知識星球