在碎片化閱讀充斥眼球的時代,越來越少的人會去關註每篇論文背後的探索和思考。

在這個欄目裡,你會快速 get 每篇精選論文的亮點和痛點,時刻緊跟 AI 前沿成果。

點選本文底部的「閱讀原文」即刻加入社群,檢視更多最新論文推薦。

本期推薦的論文筆記來自 PaperWeekly 社群使用者 @LUOHAO。本文提出了一種針對於行人重識別的生成對抗網路 PTGAN,使用 GAN 將一個資料集的行人遷移到另外一個資料集。

如果你對本文工作感興趣,點選底部的閱讀原文即可檢視原論文。

關於作者:羅浩,浙江大學博士研究生,研究方向為計算機視覺和深度學習,現為曠視科技(Face++)的 research intern。

■ 論文 | Person Transfer GAN to Bridge Domain Gap for Person Re-Identification

■ 連結 | https://www.paperweekly.site/papers/1557

■ 作者 | Longhui Wei / Shiliang Zhang / Wen Gao / Qi Tian

摘要

本文提出了一種針對於 ReID 的生成對抗網路 PTGAN,可以實現不同 ReID 資料集的行人圖片遷移,在保證行人本體前景不變的情況下,將背景轉換成期望的資料集 style。

另外本文還提出一個大型的 ReID 資料集 MSMT17,這個資料集包括多個時間段多個場景,包括室內和室外場景,是一個非常有挑戰的資料集。

論文用 PTGAN 來縮小不同資料集間的 domain gap,併在新提出的 MSMT17 這個大資料集和其他一些公開的小資料集上做了實驗。

MSMT17 資料集

MSMT17 是一個大型的 ReID 資料集,現在的一些公開資料集的準確度已經被刷得很高,這個資料集的提出進一步延續了 ReID 的發展。不過資料集目前還有公開,等待論文接收後資料集可以公開。

MSMT17 資料集有以下幾個特性:

-

資料採集時長約為 180 小時

-

總共有 15 個相機,其中 12 個室外相機,3 個室內相機

-

行人框由 Faster RCNN 機標完成

-

最後總共有 4101 個行人的 126441 個 bounding boxes

△ MSMT17 資料集和已有 ReID 資料集的對比

△ MSMT17 資料集的圖片和其他資料集的直觀對比

PTGAN

Person Transfer GAN(PTGAN)是作者提出的一個針對於 ReID 問題的 GAN。這個 GAN 最大的特點就是在盡可能保證行人前景不變的前提下實現背景 domain 的遷移。

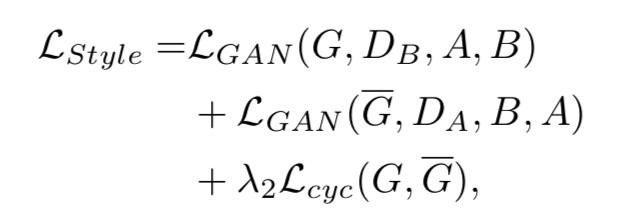

首先 PTGAN 網路的損失函式包括兩部分:

其中 LStyle 代表生成的風格損失,或者說 domain 損失,就是生成的影象是否像新的資料集風格。LID 代表生成影象的 ID 損失,就是生成的影象是否和原始影象是同一個人。λ1 是平衡兩個損失的權重。下麵的關鍵就是看這兩個損失怎麼定義。

首先 PTGAN 的基礎是 CycleGAN,所以 loss 也和正常的 CycleGAN 的 loss 差不多。首先第一部分是 LStyle,這個就是標準的 CycleGAN 的判別 loss。

以上幾部分都是正常的 CycleGAN 的損失,保證生成的圖片和期望的資料集的 domain 是一樣的。

論文的另外一個改進的地方就是 LID。為了保證圖片遷移過程中前景不變,先用 PSPNet 對圖片進行了一個前景分割,得到一個 mask 區域。

傳統的 CycleGAN 並不是用於 ReID 任務,因此也不需要保證前景物體的 ID 資訊不變,這樣的結果就是前景可能模糊之類的質量很差,更糟糕的現象是行人的外觀可能改變,比如衣服顏色發生了改變,這是 ReID 任務非常不希望見到的。

為瞭解決這個問題,論文提出 LID 損失,用 PSPNet 提取的前景,這個前景就是一個 mask,最後 ID 損失為:

其中 M(a) 和 M(b) 是兩個分割出來的前景 mask,ID loss 將會約束行人前景在遷移過程中盡可能的保持不變。最後轉換的效果如下圖所示:

可以看出,直觀上和傳統的 CycleGAN 相比能夠更好的保證行人的 ID 資訊。

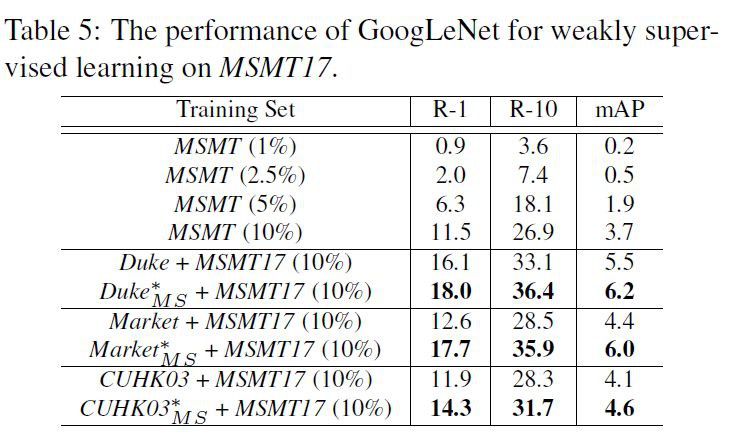

結果

實驗結果如上表,雖然論文沒有用特別複雜的網路來訓練,但是將另外一個資料集透過 PTGAN 遷移到 MSMT 上都能增加 MSMT17 資料集上的 performance。並且從準確度上看 MSMT17 還是一個非常難的資料集。

本文由 AI 學術社群 PaperWeekly 精選推薦,社群目前已改寫自然語言處理、計算機視覺、人工智慧、機器學習、資料挖掘和資訊檢索等研究方向,點選「閱讀原文」即刻加入社群!

△ 戳我領取新年禮物

參與方式

1. 長按識別下方二維碼參與投票

2. 文末留言你喜歡某篇論文的原因

3. 分享本文到朋友圈並截圖發至後臺

截止時間

2018年1月24日0點0分

福利清單

PaperWeekly定製手機殼 x 3份

PaperWeekly定製筆記本 x 5份

PaperWeekly定製行李牌 x 10份

△ 我們長這樣哦~

長按掃描二維碼,參與投票!

▼

# 高 能 提 醒 #

# 高 能 提 醒 #

1. 為了方便大家在投票過程中檢視論文詳情,請勿使用微信內建瀏覽器。點選頁面右上角的“…”按鈕,在手機瀏覽器中開啟表單。

2. 本次評選包含自然語言處理和計算機視覺兩大方向,請在你所選擇的參與方向下勾選3-10篇論文。

3. 獲獎名單將於1月25日公佈,其中5位由小編根據文末留言選取,其他13位採用隨機抽取,禮物隨機發放。

長按掃描二維碼,馬上投票!

▼

關於PaperWeekly

PaperWeekly 是一個推薦、解讀、討論、報道人工智慧前沿論文成果的學術平臺。如果你研究或從事 AI 領域,歡迎在公眾號後臺點選「交流群」,小助手將把你帶入 PaperWeekly 的交流群裡。

▽ 點選 | 閱讀原文 | 檢視原論文

知識星球

知識星球