-

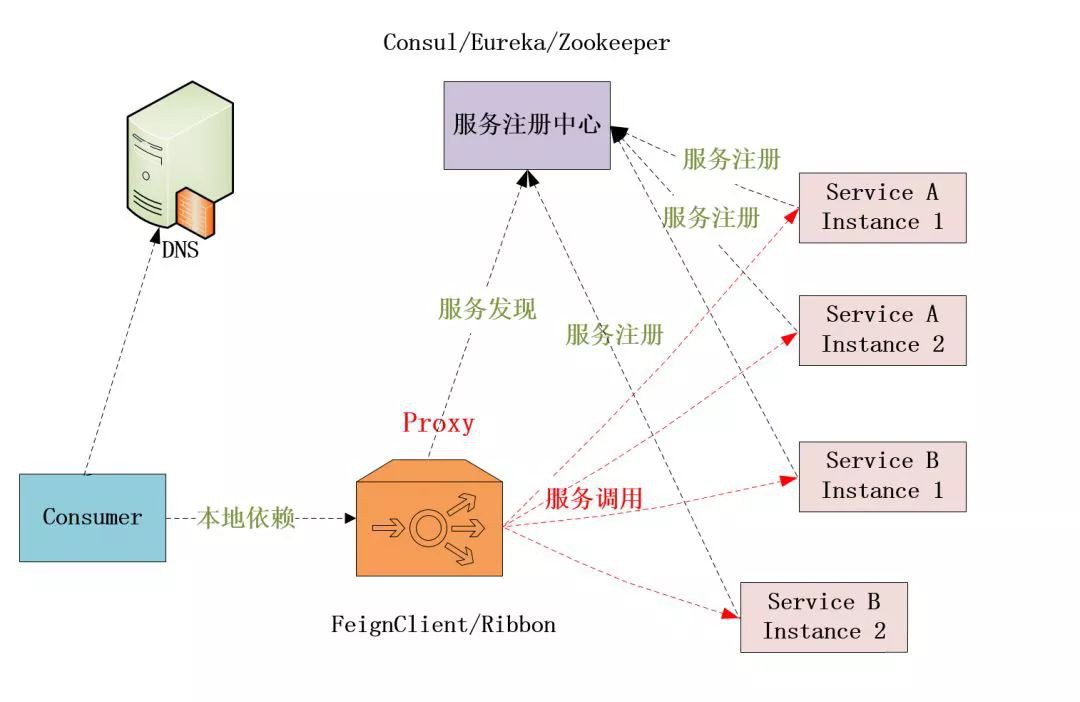

動態服務發現

-

負載均衡

-

TLS終止

-

HTTP/2和gRPC代理

-

熔斷器

-

健康檢查

-

基於百分比的流量分割

-

故障註入

-

豐富的指標

-

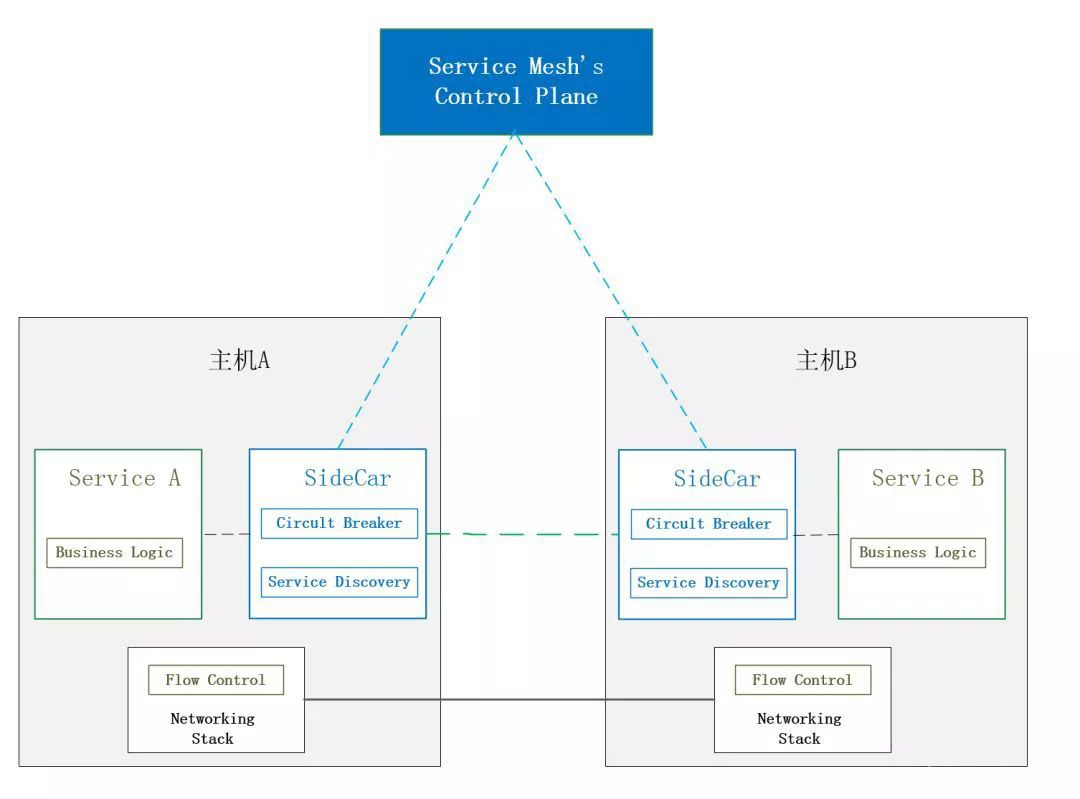

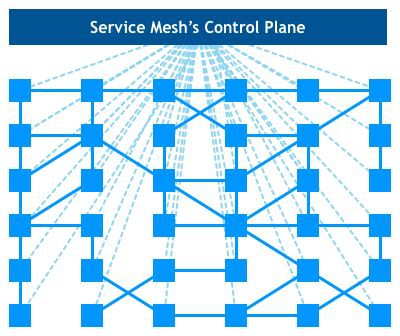

Mixer:負責收集代理上採集的度量資料,進行集中監控;

-

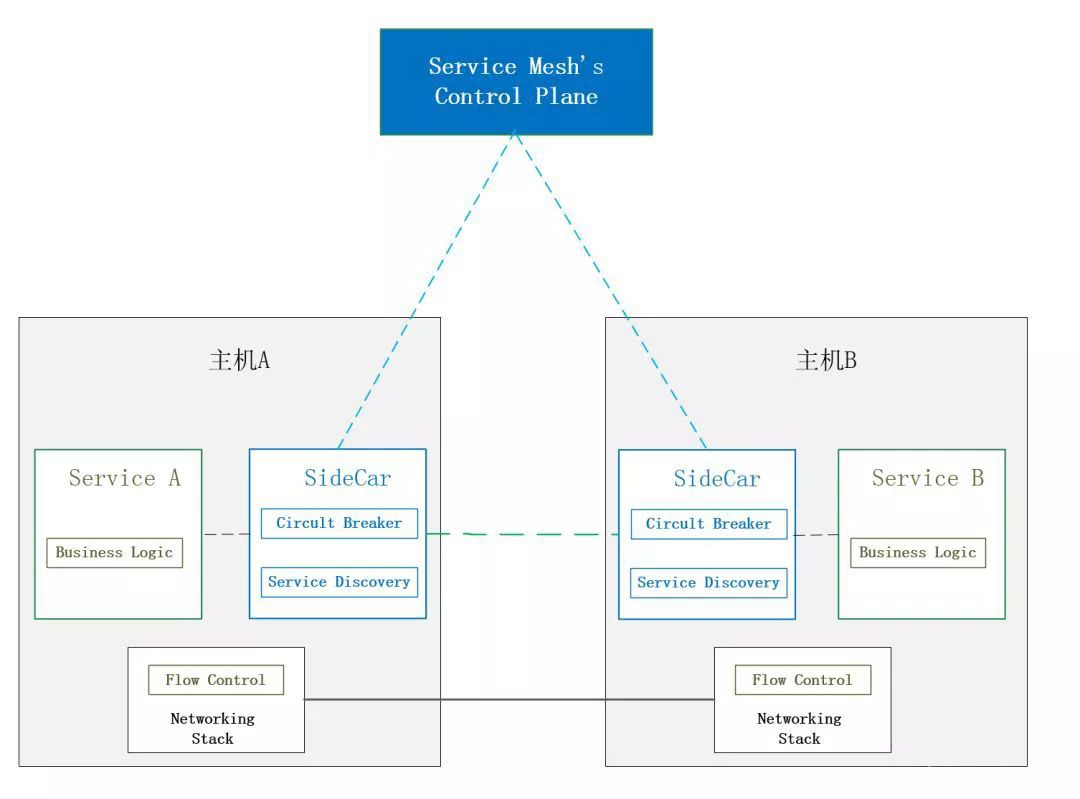

Pilot:主要為SideCar提供服務發現、智慧路由(如A/B測試)、彈性(超時、重試、斷路器)的流量管理功能;

-

Citadel:負責安全控制資料的管理和下發;

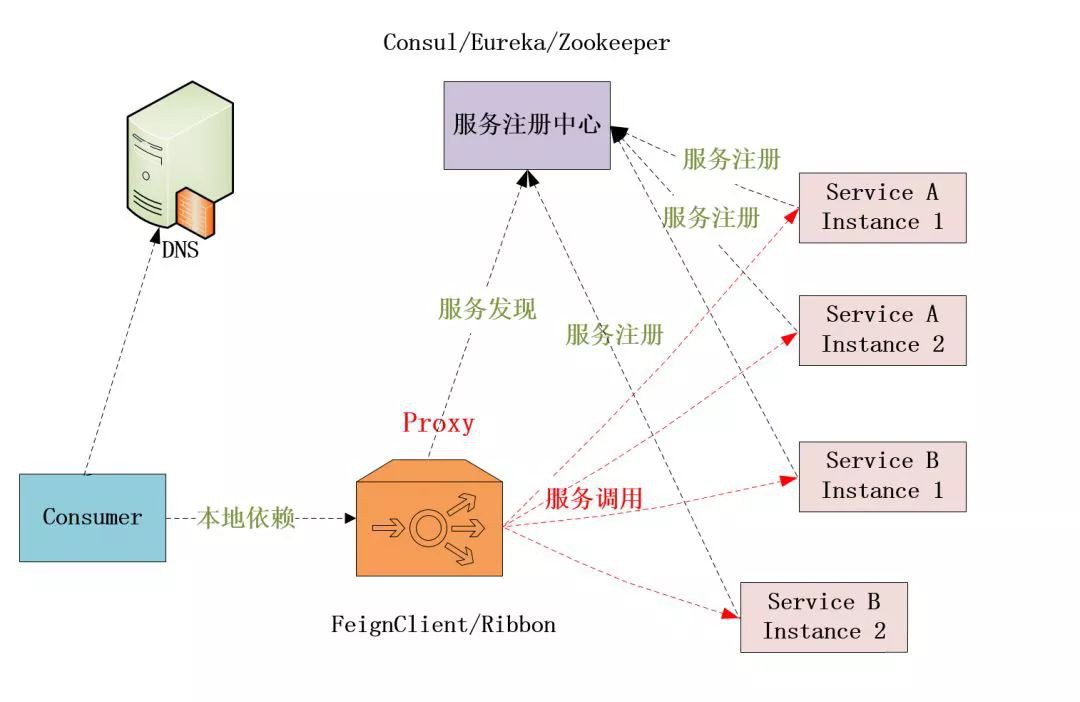

動態服務發現

負載均衡

TLS終止

HTTP/2和gRPC代理

熔斷器

健康檢查

基於百分比的流量分割

故障註入

豐富的指標

Mixer:負責收集代理上採集的度量資料,進行集中監控;

Pilot:主要為SideCar提供服務發現、智慧路由(如A/B測試)、彈性(超時、重試、斷路器)的流量管理功能;

Citadel:負責安全控制資料的管理和下發;