或者往輕了說,它是一個混淆概念。往重了說,是用來欺騙大眾的流行語,並且流行度非常高。

其實真正的內涵是“機器學習”。所以,真正強大的,每個人都應該為此感到興奮並不是所謂的人工智慧。

另一方面,人工智慧確實為一些好玩的段子提供了特別棒的素材。所以,戴上你的質疑之帽,是時候來一場人工智慧版的“揭秘之旅”了!

編譯:李馨瑜、朱帥、籍緩、蔣寶尚

來源:大資料文摘(ID:BigDataDigest)

原文:predictiveanalyticsworld

▲施瓦辛格的兩個標誌性角色:幼兒園警察和終結者

在閱讀本文之前,需要明確三點:

1. 與AI不同,機器學習完全合理

雖然獲得了令人興奮的進步。然而,這些進步幾乎完全來自於有監督的機器學習,其只能解決有很多標記資料或實體資料的計算機學習問題。這種形式將機器學習侷限在了非常有限的範圍。

2. AI什麼都不是,AI只不過是一個品牌

一個強大但空洞的承諾。“智慧”的概念完全是主觀的,本質上來自於人類自身。

那些支援人工智慧有無限可能的人,包括比爾蓋茨和埃隆馬斯克,都有同樣的假設:人工智慧的發展是一條單行道。他們表示,技術的進步推動著我們沿著這條單行道發展,直到計算機達到人類級別的智慧。其實,即便這樣,這條單行道的關鍵點也是“帶標簽的資料”。我們正在快速前進,但是朝著不同的方向發展,唯一可以確定的是,只有在一個非常特殊、有限的能力範圍內才能取得進展。

3. AI不會殺了你

科幻片中所描述的機器人災難其實是“鬼故事”。機器將按照自己的意志升級並消除人性的想法沒有任何價值。

01 勝利的神經網路

在電影《終結者2:審判日》中,機器人說:“我的CPU是神經網路處理器,一臺可以學習的計算機。”機器人所說的神經網路實際上是一種機器學習方法。更準確的說是一種描述複雜數學公式的方法。

神經網路真的可以完成很多不可思議的事,運用它可以進行影象識別。透過機器學習,計算機基本上已經可以透過程式設計來獨立完成這項工作。就其本身而言,它已經能夠確定要尋找的樣式或視覺特徵的細節。機器學習實現這些標的的能力令人敬畏!

神經網路的最新改進被稱為深度學習。它使得物體識別的準確度大幅度提高。深度學習透過增加更多神經網路層使學習更加深入。

▲具有四層的簡單神經網路的體系結構

02 機器學習需要標記資料

因此,隨著機器在人性化任務中表現得越來越好,這是否意味著他們變得越來越聰明,越來越智慧化?

不。它可以真正地、出色地完成某些任務,但只有在有正確的資料可供學習的情況下才可以。對於上面討論的標的識別,可以透過從大量打標簽的照片中學習做到這一點。因為,其中標的已經被正確標記。

深度學習需要這些打標簽的資料。這稱為有監督的機器學習:當有預先標記的訓練資料時,學習過程由標記的資料引導或“監督”。

它不斷調整神經網路以使它在這些資料上做得更好,然後逐個改進,這是學習過程。神經網路改進或“學習”的唯一方法是透過在那些標記的資料上進行測試來實現的。沒有標記資料,神經網路就無法知道改進的正確與否,也就不會知道在這個過程中要堅持哪些改進。

▲《危險邊緣》上的沃森

這是另一個例子。2011年,IBM的沃森在電視智力競賽節目《危險邊緣》中擊敗了兩屆人類冠軍。

準確地說,計算機並不能真正聽懂問題,而是將每個問題轉換成文字輸入。但是,考慮到《危險邊緣》遊戲中的問題都是基於人類的習慣而設計的,採用了複雜而巧妙的措辭,並且涵蓋了各種對話場景,而沃森能夠一口氣答對一個又一個問題,不得不承認,它是非常棒的“類智慧”物體。

但是,需要說明的是,沃森之所以能夠如此聰明,是因為它事先透過大量有標簽的樣例問題進行了學習:它的學習樣本是從過去多年來電視問答節目上採集的25000個問題,且每個問題都給出了正確答案。

其實,最核心的技巧是把每個問題轉換成“是/否”的預測結果。對諸如“某某是這個問題的正確答案嗎?”的問題,回答“是”還是“否”。

如果你能回答一個這樣的問題,那麼就能回答所有類似的問題,你要做的只是不停地嘗試上千種選項直到有足夠的自信回答正確。舉個例子,“亞伯罕·林肯是美國的第一任總統嗎?”不是。“喬治·華盛頓呢?”是的!現在,機器就對這個問題有了自己的答案並且能夠回答出來了。

03 能像人類一樣交談的計算機

同樣,語言應用的另一個領域也需要大量的標簽資料,那就是“機器翻譯”。機器學習是透過學習大量有標註的資料實現的,例如英文翻譯到日文的過程,計算機會學習到英文標註的陳述句文字,以及每個陳述句對應的日文翻譯。

近年來,每個人都能線上使用的谷歌翻譯,透過深度學習驅動的架構取代原來的底層方案,實現了翻譯質量的進一步改善。

另一方面,掌握像英語這樣的自然語言是人性化的標誌,但也僅僅是人性化。對於我們的“矽谷兄弟姐妹”來說,如何流利地說出自然語言仍然是一個問題。

而當我們人類理解別人的話時,在所有的單詞以及一些邏輯語法規則的表象下,往往帶有“常識和推理”。如果沒有這個人類特有的技能,你就無法使用語言。

所以,人類和計算機交談的希望和夢想會終將破滅。因為,很不幸,沒有“像人一樣交談”這樣的標簽資料。你可以針對一個受限的、具體的任務獲取正確的資料,像電視問答,或者回答一些人們希望Siri回答的有限範圍的問題。

但是,“像人一樣交談”的一般性概念是一個無法被很好地定義的問題,計算機能夠解決的只是能夠被準確定義的問題。

所以,我們無法利用機器學習實現我們在很多科幻電影裡看到的那些能夠正常交談的計算機,像終結者,或者星際迷航中友善的飛船電腦。你可以用英語和這些機器交談,就像和正常人交談一樣。這很容易,你只需要成為科幻電影裡的人物就行。

▲出自電影《2001太空漫遊》

04 智慧是主觀的,所以AI沒有真正的定義

現在,如果你覺得自己對人工智慧還不夠瞭解,那你錯了。其實沒什麼好瞭解的,因為它很不真實,沒有任何有意義的明確定義。人工智慧作為一個領域,只是一個被幻想存在的東西而已。

作為一個假定的領域,人工智慧有許多矛盾的定義,其中大部分可以歸結為“智慧計算機”。我必須提醒你,不要在字典裡查“自我參照”(self-referential),否則會陷入死迴圈。

▲“蝙蝠”電腦

如果有些定義真的可能的話,它們比“智慧計算機”更讓人摸不著頭腦。它們只是直截了當地在AI的定義裡使用了“智慧”這個詞而已,比如“由機器展現出來的智慧”(intelligence demonstrated by a machine)。

如果你認為這些定義裡存在更深的隱含意義,那麼可能會讓你驚訝,因為並沒有。無法解釋“智慧”是一個多麼主觀的詞彙。對於計算機與工程行業來說,“智慧”可以是一個任意的概念,和任何精確的標的都不相關。所有試圖定義AI的行為都因為無法解決模糊性而失敗。

令人困惑的是,在如今的實踐中,“智慧”這個詞被作為機器學習的同義詞使用。但是就人工智慧本身的定義而言,大部分提出的定義都是以下三種定義的變體:

1. 人工智慧是讓計算機像人一樣思考,模擬人的認知。現在,我們對自己的大腦任何運轉尚且知之甚少。而試圖透過一個神經元接一個神經元的複製大腦,就如同科幻小說中用到“倘若”這個詞一樣,純屬白日做夢。

內省(當你思考自己如何思考的時候)是一件有趣並且重要的事情,但是最終我們也無法得知自己的頭腦中究竟發生了什麼。

2. 人工智慧是讓計算機像人一樣行動,模擬人的行為。想象一下它像鴨子一樣走路,像鴨子一樣交談……但是,它不會,也不可能會。我們太過複雜以至於我們無法完全理解自己,更不用說將這些理解轉換為計算機程式碼了。

此外,讓人們誤以為聊天室裡的電腦是一個正常人(也就是人工智慧領域著名的圖靈測試),在這個定義裡就變成了一個不成熟的論斷。因為機器是一個移動的標的,正如我們人類會透過辨別用來欺騙我們的行為才能變得更聰明。

3. 人工智慧是讓電腦解決困難的問題,讓它們真正能夠完成那些看起來需要“智慧”或者“人類級別的能力”才能完成的任務,比如駕車,識別人臉或者下棋。

但是,既然計算機能做這些事情,那這些事情就看起來不那麼智慧了。計算機能夠做的所有事情僅僅是那些機械的,容易理解的並且行為簡單的工作。一旦計算機能夠做到這件事情,它就不會再給人留下很深的印象了,自然也就失去了魅力。

電腦科學家拉里·特斯勒建議將“智慧”定義為“機器還不能做的事情”。這聽起來像在開玩笑,因為這是在用一個不斷變化的定義去定義本身就不存在的東西。

05 相信人工智慧的必然性的謬論

事實是,“人工智慧”本身就是一個謊言。只要使用這個流行語,就像在說技術的進步正在向人們預料的方向發展。為了獲得像人一樣的“常識”,這是一個非常誘人的標的,但也只不過是一個不切實際的承諾。

你是獨一無二的,你抽象思考的能力和理解周圍世界的能力,在每時每刻的經歷中,你可能會覺得非常簡單,但其實它複雜得我們無法想象。這種簡單的體驗,可能是因為人類獨特的大腦對這些的感受已經非常熟練了,也可能是因為人類固有的錯覺,或者兩者兼而有之。

現在,有些人可能會回應,“沒有靈感的時候,有遠見的雄心是一件好事嗎?”

想象力鼓勵了我們,未知的世界向我們招手!《2001太空漫遊》的作者亞瑟克拉克提出了一個很好的觀點:“任何足夠先進的技術都與魔術無法區分。”

然而,這並不意味著我們可以想象的可能包含在科幻小說中的“魔法”最終都可以透過技術實現。因為它在電影中存在並不意味著它會發生。

▲HBO西部世界的機器人

人類的獨特性和機器學習的真正進步都已經令人驚嘆和激動,讓我們樂在其中。但我們不需要童話故事,尤其是誤導性的故事。

06 索菲亞:人工智慧最臭名昭著的欺詐性宣傳特技

這部童話故事的明星——“公主”的主角,由索菲亞飾演,這是漢森機器人的產物,也是人工智慧最臭名昭著的欺詐性宣傳噱頭。

這個機器人運用她的人造優雅和魅力來欺騙媒體。Jimmy Fallon和其他採訪者“主持”了她。當和它“交談”時,它的回覆是預先設定的對話,卻被誤傳為自發對話,在某些情況下,只是基本的聊天機器人級別的響應。

▲三大時尚雜誌中有一本封面上是機器人索菲亞

不管你信不信,三大時尚雜誌都將索菲亞列入封面,沙烏地阿拉伯國家正式授予其公民身份,使其成為第一個機器人公民。

索菲亞是一個現代機械土耳其人(Mechanical Turk),這曾是一個18世紀的騙局,騙了拿破侖和本傑明富蘭克林這樣的人,這個騙局使他們相信他們只是在一臺機器上輸了一盤棋。你可以在桌子後面看到的人體模型會移動棋子,受騙者不會註意到實際上有一個隱藏在櫥櫃內的人類象棋專家。

▲機械土耳其人(Mechanical Turk)

在現代,亞馬遜有一個線上服務,用來僱傭工人執行許多需要人類判斷的小任務,比如選擇最好看的幾張照片。它被命名為亞馬遜機械土耳其人(Mechanical Turk),它的口號是“人工的人工智慧”。

這讓我想起這個選單上有“模擬假鴨”的優質素食餐廳,它的味道與模擬鴨子完全一樣。如果它像鴨子一樣說話,它的味道就像一隻鴨子……

▲這是一隻鴨子

是的,最好的假AI是人類。1965年,當NASA捍衛將人類送入太空的想法時,他們就是這樣說的:“人類是成本最低,重150磅,非線性,通用的計算機系統,可由非熟練勞動力大規模生產。”

▲NASA認為人類是人工智慧的良好替代品,確實,我的大多數朋友都是人

07 危險超級智慧的神話

對於索菲亞,人們集體聲討,事實上情況變得更糟:人們聲稱人工智慧對人類構成了生存威脅。最看似可靠的訊息表明,最精英的科技名人都相信存在殺人機器人和殺手電腦的世界末日。除了比爾·蓋茨、埃隆·馬斯克,甚至已故的偉大的斯蒂芬霍金都沒有跳出“超級智慧奇點”的潮流。

他們相信機器將達到一定程度的能力,使機器能夠自我提高,甚至將迅速升級過去的人類智慧,並以計算機的閃電般速度實現這一標的。

計算機本身的速度透過他們的超級智慧繼續提高,以至於輕微的標的錯位可能會消滅人類。就像我們天真地命令它製造盡可能多的橡膠雞一樣,它可能會發明一個全新的高速工業,可以生產40萬億隻橡膠雞,但這會以人類的滅絕為代價。

這個理論存在兩個問題。首先,它是如此引人註目的戲劇性,它會破壞電影。如果最好的壞人總是機器人而不是人類,那麼Nurse Ratched(恐怖片《比利小姐的決定》角色)和Norman Bates(恐怖片《驚魂序曲》角色)呢?我需要我的漢尼拔!順便說一下,“最好的壞人”是矛盾的。 “人工智慧”也是如此。

▲漢尼拔

但確實如此:《機器人啟示錄》肯定會到來。基於同名小說的《變形金剛》導演邁克爾貝爾講話時說到,如果《機器人啟示錄》沒有到來,那麼你出生在了錯誤的平行宇宙中。

人工智慧世界末日理論的第二個問題是:AI是如此聰明,它會意外殺死所有人?成為很愚蠢的超級智慧?這聽起來是一個矛盾。

更確切地說,真正的問題是該理論假設技術進步使我們沿著人類“思考”的道路前進。但他們並不是像人類一樣“思考”。我將稍後繼續探討這一點。現在進一步談一下關於這個世界末日理論的輻射範圍。

08 超級智慧的廣泛信仰

牛津大學應用倫理學教授Nick Bostrom的紐約時報暢銷書《超級智慧(Superintelligence)》是奠定基礎的首選書籍。如果這本書沒有為人類開火,那麼這本書就會扼殺恐懼並煽動火焰。它探討了我們如何“使AI爆炸成為可能。”

《衛報》報道了一篇文章《人工智慧:我們就像孩子們玩炸彈》,《新聞週刊》也報道了《人工智慧即將到來,它可以淘汰人類》,這兩個標題都乖乖地取用了博斯特羅姆本人的話。

比爾·蓋茨對此書有很高的評價;馬斯克曾說過:人工智慧的危險程度甚於朝鮮。霍金一直堅持他自己的觀點:人工智慧是人類的終結……

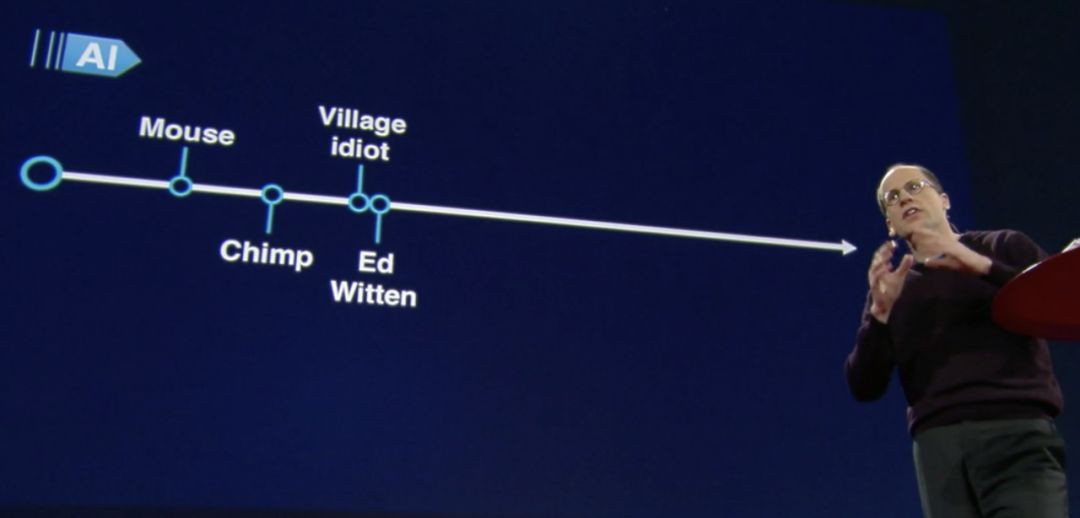

不管怎麼說,這個對“智慧”錯誤的定義才是問題所在。在很多訪談和演講中,幾乎所有的信徒都在錯誤的假設下,“聰明”或“智慧”或多或少被弱化。他們認為,機器會在一些具有挑戰性的任務中的排名會變得越來越高,最終超過了人類。

但機器學習讓我們沿著不同的道路前進。我們正在快速前進,我們可能會走得很遠,但我們正走進一個不同的方向,這個方向與人類能力相關。

人類非常聰明,對個人經歷思考正在讓我們進入思想陷阱。正如一些錶面非常簡單的事情,其實非常複雜。人類的一些獨特的能力被被隱藏在了一種有意識的面紗下。“常識”對我們來說非常簡單,但是沒有任何技術和方式能夠複製。

抽象思維往往感覺很簡單。我們在腦海中畫出視覺效果,就像我們正在模擬的一座城市的非比例地圖,或者兩家大公司正在競爭銷售的“空間”,每家公司在某些領域佔據主導地位,但在另一些地區則不佔主導地位。

或者,當考慮到人工智慧時,越來越熟練的能力-智力和計算能力-的錯誤視野都沿著同一條路走,有點狹窄。

我們不應該把智慧機器未來的樣子擬人化。它不是人類的,所以很難推測它的具體細節。既然有些人相信技術是沿著包括並超越人類認知的領域前進的,那麼他們所設想的本身就是擬人化的,它具有人性的特質。

現在,在你看來,你的常識推理似乎是任何一種智力發展必經的“自然階段”,但這是一個以人為中心的觀點。常識是複雜的,非常特別。對任何人來說,正式定義包括人類認知在內的“智力範圍”是遠遠無法控制的。

09 機器沿著不同的方向前進

機器學習實際上只適用於標記了資料的任務,比如影象中的標的識別。有了標簽資料,可以比較和排序各種嘗試來解決這個問題。計算機用這些資料來衡量它做得有多好。例如,一個神經網路可以正確識別影象中90%的卡車,然後經過一些改進可能達到95%。

但是在特定的任務上做得越來越好,顯然並不能產生一般的常識推理能力。機器不會達到像人類一樣的水平,它只會越來越好地識別物體,僅此而已。

智力對人類來說並不是獨立存在的柏拉圖式的理想,它一直等待被髮現的。並且不會隨著越來越好的技術自發地出現。

人們往往很容易相信複雜性的增加會導致智力的增長。畢竟,計算機是非常通用的,它們基本上可以完成任何任務,只要把智力定義為一項任務就好了。我們讓他們做越來越複雜的事情,但僅僅因為我們讓它做事情,而不是自發的做事情。

到目前為止,機器學習方面的任何進步都沒有提供任何提示或暗示,說明什麼讓計算機可以獲得“一般常識推理”。夢想讓機器擁有這種能力。不過只是我們的一廂情願罷了。

經過了幾十年的創新,其實現在和過去也沒有本質的不同。

10 讓術語“AI”終止

機器基本上仍在我們的控制之下。計算“犯錯”或許會導致死亡,正如人們會在自動駕駛和醫療自動化中死亡,但不會是災難性的級別,除非是有人故意設計程式攻擊人類。其實,當出現錯誤時,我們可以將系統離線並修複它。

是時候讓術語“AI”終止了。確實,流行詞“AI”弊大於利。在一定程度上,它有時可能有助於宣傳,但至少在同樣程度上,它誤導了公眾。

最重要的是,不要對“AI”進行監管!技術非常需要某些領域的監管,例如,解決演演算法決策和自主武器開發中的偏見。因此在這些討論中,“清晰”是絕對關鍵的。使用“人工智慧”這一不精確、具有誤導性的術語,嚴重損害了任何管制技術的舉措的效力和可信度。監管已經夠嚴格了,而且目前還沒把水弄混。

本文是Dr. Data基於其自己的影片《AI是一個大謊言》整理而成。Dr. Data又名Eric Siegel,打破了傳統的資料科學資訊娛樂的樣式,做了一個涵蓋機器學習和預測分析的網頁,非常有趣。

影片連結:

https://youtu.be/xnKkHaALj1U

網頁:

https://www.predictiveanalyticsworld.com/doctor-data-show/

相關報道:

https://www.predictiveanalyticsworld.com/patimes/dr-data-video-a-i-is-a-big-fat-lie/9909/

我們正在繪製一份大資料粉絲畫像——

2019大資料粉絲有獎調查問捲上線了

歡迎長按二維碼填寫

我們每週一將從參與者中

隨機抽取3名幸運小夥伴

每位將獲贈近期出版的技術類圖書1本

更多精彩

在公眾號後臺對話方塊輸入以下關鍵詞 檢視更多優質內容!

PPT | 報告 | 讀書 | 書單 大資料 | 揭秘 | 人工智慧 | AI Python | 機器學習 | 深度學習 | 神經網路 視覺化 | 區塊鏈 | 乾貨 | 數學

Q: 你覺得AI是個謊言嗎?

歡迎留言與大家分享

覺得不錯,請把這篇文章分享給你的朋友

轉載 / 投稿請聯絡:baiyu@hzbook.com

更多精彩,請在後臺點選“歷史文章”檢視

知識星球

知識星球