Intersect360對HPC使用者現網系統中三個應用領域(系統互聯、儲存網路和區域網LAN)的網路型別和供應商的情況進行調研,調查的主要結果包括:

- 乙太網和InfiniBand是兩種主要的網路協議,在系統互連、儲存網路和區域網三個領域中都保持著競爭。在不考慮資料速率的情況下,乙太網是這三個應用領域中應用最普遍的。對於效能更高的網路互連,InfiniBand(尤其是40G)研究報告顯示是使用數量最多的。

- 約2/3的受訪站點反饋在其網站上部署安裝了乙太網和InfiniBand。

- 10GE乙太網在儲存網路最多,包括從GE乙太網升級業務而來的,超過InfiniBand安裝數量。

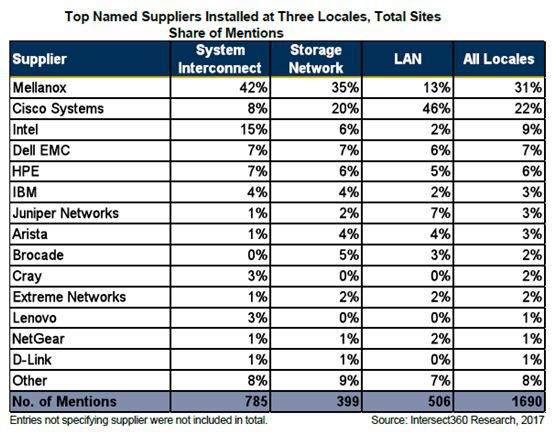

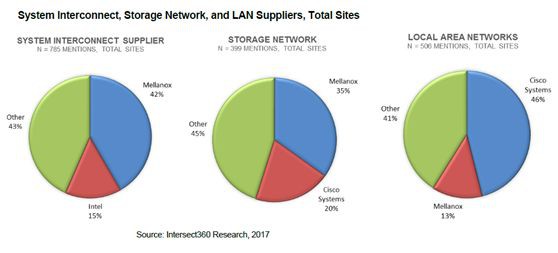

- Mellanox是系統互連最常見的供應商,42%的使用者提到使用該網路,35%的使用者提到在儲存網路使用該網路。思科仍然是區域網市場的領先供應商,有46%的使用者採用思科網路。

- Mellanox在每個領域都獲得了市場份額。在系統互連佔42%,儲存網路佔35%,區域網絡佔13%。

- 報告顯示正如預期,乙太網佔據了這些站點的大部分區域網網路實現,10千兆乙太網和千兆乙太網各佔35%。預計千兆位乙太網在未來幾年的市場份額將緩慢下降。

Intersect360利用基於Web的調查工具調查了來自行業、政府和學術界的高效能運算的使用者,收集並展示了關於硬體、軟體和網路配置的資訊。受訪者列出他們的高效能運算伺服器、儲存、網路、中介軟體和應用軟體的特徵。

Intersect360研究公司每年進行大規模的普查。在2016年第二和第三季度連續第9次的調查,收到了來自240個站點的回覆,在2016年的普查報告中,共涉及487個高效能站點資訊(包含之前兩次調查)。收集和調查地點資料的標的包括:

- 開發需求側資料,用於跟蹤和建模高效能運算市場在機房、供應商定位、技術採用、使用者購買樣式等領域的基本特徵。

- 收集和比較需求端資料和供應端資料,以便準確構建整個HPC生態系統。

- 隨著時間的推移跟蹤這些特性的趨勢。

- 支援我們的高效能運算市場規模和預測模型。

站點調查產生了大量的及到供應商對市場的滲透、體系結構、處理器、互連、儲存和軟體以及購買樣式資料。這些資訊在我們的現場普查報告系列中被提出和分析。本報告概述了在HPC使用者站點互連和網路情況(系統、儲存和LAN)。總共有474個站點, 723個高效能運算系統、633個儲存系統和638個區域網的互連和網路特性。

在調查中,我們詢問了受訪者關於安裝在三種場景的互連和網路的特點:

- 1)刀鋒伺服器、叢集和MPP系統的系統互連;

- 2)儲存網路;

- 3)區域網或機房區域網(以下簡稱區域網)。

三個應用領域網路型別比較

乙太網(所有資料速率)是所有三種場景使用的主要技術,主要是由於千兆位乙太網的優勢。該表的主要內容包括:

- 超過30%的系統互連和區域網使用1GE乙太網。Intersect360認為這些較慢的技術通常用於叢集上的二級管理連線,以及小型面向吞吐量的叢集的主要互連。

•大約72%的千兆位乙太網被認為是次要的互連,而不是主要的。千兆乙太網作為標準的叢集互連繫統出現在許多系統中,這使得它在分散式記憶體系統中得到了廣泛的應用。

- InfiniBand繼續是高效能系統互聯的首選。如果不包括乙太網1GE,InfiniBand的安裝量大約是乙太網(10G、40G和100G)的總安裝量的兩倍。在InfiniBand安裝中,InfiniBand 40G仍然是安裝最多的。然而,對於2014年以後的系統來說,InfiniBand 56G是最受歡迎的系統選擇。

- 10千兆乙太網在儲存和區域網安裝中使用的比任何其他協議都多。報告顯示,10千兆乙太網的安裝佔所有儲存網路的35%,InfiniBand一直在逐步增加其儲存網路的份額,從31%增加到34%,幾乎所有的份額都來自InfiniBand 56G。

- 2016年Omni-Path安裝在系統互連和儲存網路中所佔的份額很小(小於1%)。Omni-Path於2016年第一季度開始上量。因此,我們預計在以後的調查中會越來越多。

高效能運算站點互連和網路型別

下麵圖示說明瞭在調查站點上安裝了哪種主要網路型別,以及在HPC基礎設施上使用的主要網路標準。統計資料是根據現場數量計算,使用相同的系統互連或網路型別在一個站點上的多個系統或網路只計算一次。

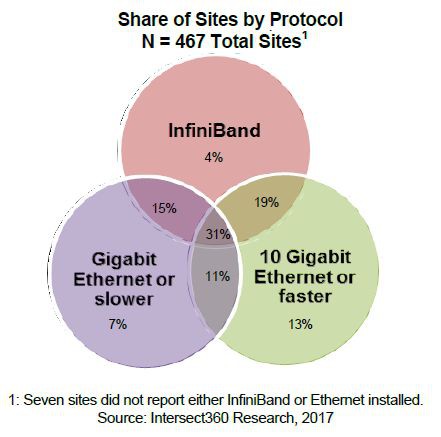

下圖顯示安裝了至少一種主要網路型別(千兆位乙太網或更慢、10千兆位乙太網或更快、InfiniBand)共享的站點。顯示31%的站點,也是最大的份額的共享,統計包括所有三種網路型別。接下來兩個最大的份額是InfiniBand和一種乙太網的站點。大約65%的站點都在現場安裝了InfiniBand和乙太網。這說明瞭站點網路安裝的多樣性和複雜性。

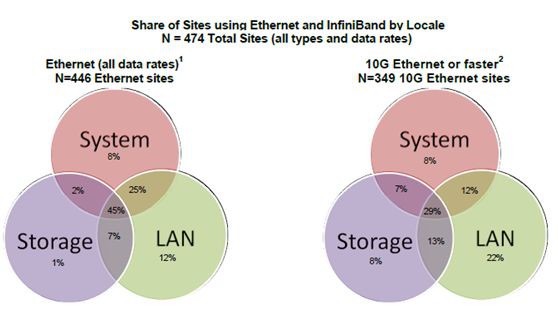

圖示說明瞭每個網路協議的使用位置。乙太網(所有速率)、10千兆位乙太網或更快的乙太網和InfiniBand分別給出。百分比表示安裝了特定網路的站點的份額。例如,446個乙太網站點中有45%在所有領域(系統互連、儲存網路和LAN)使用該技術,而25%僅在系統互連和LAN中使用該技術。

高速乙太網 (10G、40G和100G)的站點常主要用於儲存網路和區域網,如果它也用於該站點的LAN或儲存網路,則更可能用作系統互連。

InfiniBand安裝在一個或多個應用領域,佔69%,與過去幾次調查所得的比例大致相同。InfiniBand在儲存網路上的使用有所增加,在使用InfiniBand的站點中,大約有56%的站點使用InfiniBand。Intersect360認為,在任何地區選擇InfiniBand的使用者,都是出於對更高效能的需求,尤其是更高的頻寬和更低的延遲,這兩個指標上,InfiniBand一直在乙太網絡上保持著優勢。選擇InfiniBand作為系統互連的使用者,在將其擴充套件到儲存網路時,可能也在利用這個架構優勢。

每個應用領域互連網路和供應商

在51家頂級網路供應商中,有20家在所有三個應用領域都有產品。Mellanox在系統互連和儲存網路中被使用者提及的次數最多,是在系統互連方面的最強代表。思科在區域網產品中提及次數最多。Mellanox和思科兩個供應商在報告中,安裝數量佔50%以上。

隨著技術變得更加標準化和可靠,使用者往往會對特定的供應商失去興趣和忠誠度。這種趨勢反映在使用者將系統或儲存供應商與系統中的元件技術相互關係。無論供應商在該系統上安裝了多少網路元件,所提及的每個站點網路供應商都被算作一次統計。完整的供應商串列請參考報告原文。

結論

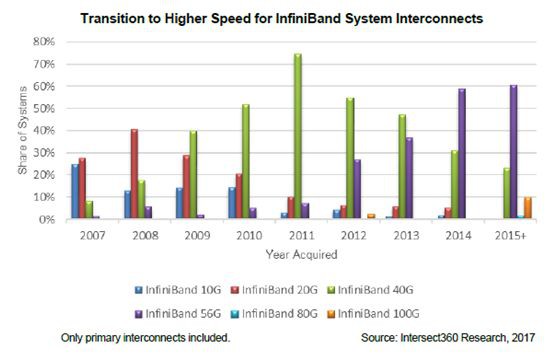

對速度的需求幾乎是高效能運算和互連的主要驅動力,網路也不例外。下圖顯示InfiniBand系統互連技術向更高速度過渡。對於2007年的系統,我們看到InfiniBand10G和20G之間的分佈大致相同。到2009年,更多的系統使用InfiniBand 40G。InfiniBand 40G在2014年之前佔據了系統的大部分份額,當時InfiniBand 56G接管了主要的安裝系統互連,這一轉變非常迅速,最新的效能領導者在兩到三年內佔據了大部分出貨量。

儲存網路也在向最新技術的快速過渡。類似大多數技術,使用者試圖最佳化、向最新或更快互連網路過渡,這似乎與伺服器的生命週期(每兩到三年)的速度差不多。每次系統更新時,都會選擇最新或最好價格/效能互連網路。

網路效能的另一個驅動力是應用程式的並行化趨勢。隨著單執行緒效能的極限,使用者必須重寫應用程式,以便更好地使用並行性。一階並行化可以使用每個處理器的更多核心,向量或SIMD程式設計模型的OpenMP風格多執行緒軟體。

然而,向量模型並不是在所有情況下都有效。這種情況將迫使使用者探索訊息傳遞或MIMD解決方案,其中應用程式效能與網路的延遲和頻寬特性或處理器節點之間的互連緊密相連。長期以來,為並行應用程式效能構建互連結構一直是MPP系統的主要關註點,MPP系統是圍繞專有互連構建的,而超級計算機叢集往往使用最快的通用網路技術。在所有級別上實現更大的應用程式並行化的趨勢,將推動市場對網路效能的需求不斷走向高頻寬、低延時。

在這三個應用領域中,至少有兩個供應商佔了超過50%的比例。Mellanox和Intel在系統互連,Mellanox和Cisco在儲存網路和區域網。這三個供應商的網路元件都是基於乙太網或InfiniBand。

2016年,Omni-Path向高效能運算市場普及。英特爾在2012年從QLogic手中收購了技術,成為了InfiniBand 網路的供應商,該公司現在以TrueScale品牌銷售。

在2016年的調查中,只有少數使用者(15%)提到了Omni-Path。儘管這一份額遠遠落後於Mellanox,但英特爾將透過引入Omni-Path技術,將其互連技術整合到其處理器路線圖中。這可能會在很大程度上改變系統Fabric業務的架構,因為英特爾可能會開始將網路作為英特爾處理環境的特性擴充套件進行營銷。就目前而言,Mellanox在戰略上和行動上都先發制人,但是Mellanox花落誰家,未來該如何走,只能拭目以待。

關於IS360 HPC網路分析報告,請文末留言,並聯絡作者獲取。關於更多HPC、Omni-Path、Infiniband、pFS等技術,請點選原文連結獲取更多內容。

推薦閱讀:

溫馨提示:

請搜尋“ICT_Architect”或“掃一掃”二維碼關註公眾號,點選原文連結獲取更多電子書詳情。

求知若渴, 虛心若愚

知識星球

知識星球