-

DAS就是本地盤,直接插到伺服器上

-

NAS是指提供NFS協議的NAS裝置,通常採用磁碟陣列+協議閘道器的方式

-

SAN跟NAS類似,提供SCSI/iSCSI協議,後端是磁碟陣列

-

SDS是一種泛指,包括分散式NAS(並行檔案系統),ServerSAN等

-

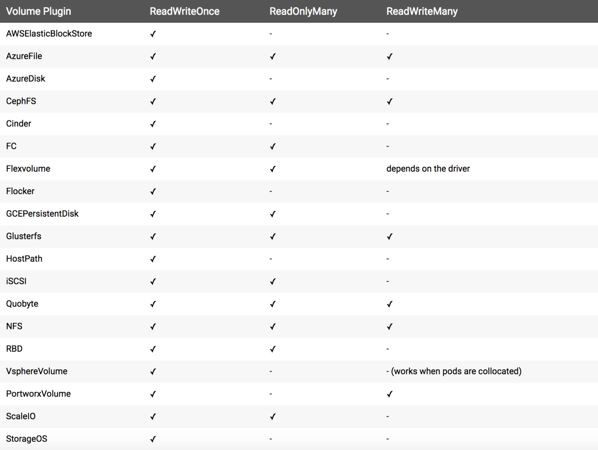

塊儲存通常只支援RWO,比如AWSElasticBlockStore,AzureDisk,有些產品能做到支援ROX,比如GCEPersistentDisk,RBD,ScaleIO等

-

檔案儲存(分散式檔案系統)支援RWO/ROX/RWX三種樣式,比如CephFS,GlusterFS和AzureFile

-

物件儲存不需要PV/PVC來做資源抽象,應用可以直接訪問和使用

fio -filename=/dev/sdc -iodepth=${iodepth} -direct=1 -bs=${bs} -size=100% --rw=${iotype} -thread -time_based -runtime=600 -ioengine=${ioengine} -group_reporting -name=fioTest

fio -filename=/mnt/yrfs/fio.test -iodepth=1 -direct=1 -bs=${bs} -size=500G --rw=${iotype} -numjobs=${numjobs} -time_based -runtime=600 -ioengine=sync -group_reporting -name=fioTest

mpirun --allow-run-as-root -mca btl_openib_allow_ib 1 -host yanrong-node0:${slots},yanrong-node1:${slots},yanrong-node2:${slots} -np ${num_procs} mdtest -C -T -d /mnt/yrfs/mdtest -i 1 -I ${files_per_dir} -z 2 -b 8 -L -F -r -u

-

儲存容量在70%以上或者檔案數量上億的效能指標

-

節點/磁碟故障後的效能指標

-

擴容過程時的效能指標

-

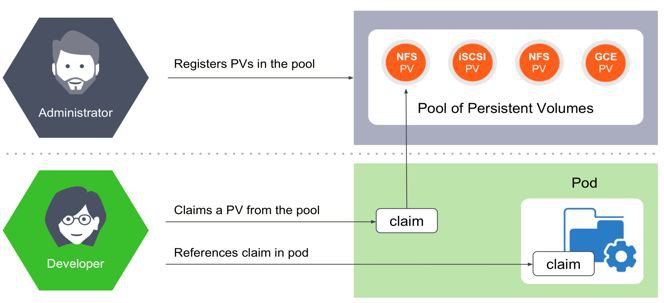

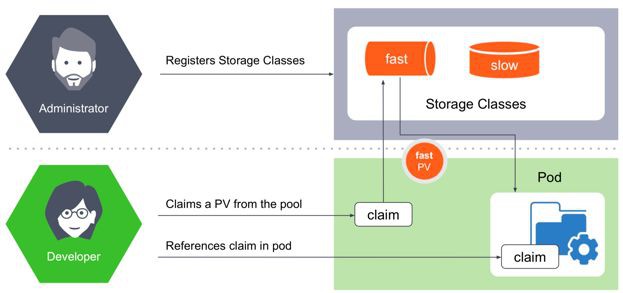

Flexvolume/CSI介面的支援,動態/靜態PV的支援

-

儲存配額。對於Kubernetes的管理員來說,儲存的配額是必須的,否則儲存的使用空間會處於不可控狀態

-

服務質量(QoS)。如果沒有QoS,儲存管理員只能期望儲存提供其他監控指標,以保證在叢集超負荷時,找出罪魁禍首

-

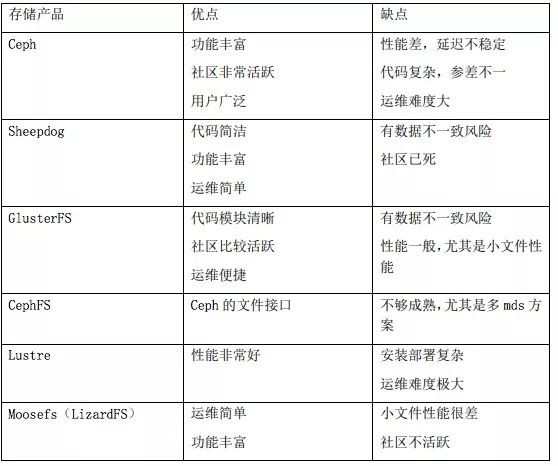

儲存的三大核心,高可靠,高可用和高效能

-

業務場景,選擇分散式檔案儲存

-

擴充套件性,儲存能橫向擴充套件,應對業務增長需求

-

可運維性,儲存的運維難度不亞於儲存的開發,選擇運維便捷儲存產品

-

成本

知識星球

知識星球