在碎片化閱讀充斥眼球的時代,越來越少的人會去關註每篇論文背後的探索和思考。

在這個欄目裡,你會快速 get 每篇精選論文的亮點和痛點,時刻緊跟 AI 前沿成果。

點選本文底部的「閱讀原文」即刻加入社群,檢視更多最新論文推薦。

本期推薦的論文筆記來自 PaperWeekly 社群使用者 @TwistedW。本文來自斯坦福斯大學,論文在 WGAN 的基礎上為 GAN 設計了一個課程,透過不斷增強判別器的判別能力(課程難度)讓生成器學習任務更難,從而讓生成器生成能力不斷提高(學業成績提高)達到整體的最佳化。

如果你對本文工作感興趣,點選底部閱讀原文即可檢視原論文。

關於作者:武廣,合肥工業大學碩士生,研究方向為影象生成。

■ 論文 | Improved Training with Curriculum GANs

■ 連結 | https://www.paperweekly.site/papers/2182

■ 作者 | Rishi Sharma / Shane Barratt / Stefano Ermon / Vijay Pande

本文來自斯坦福斯大學,論文在 WGAN 的基礎上為 GAN 設計了課程,透過不斷地增強判別器的判別能力(增加課程難度),讓生成器學習任務更困難,在越來越難的課程下不斷進步自己的生成能力,從而實現高質量影象的生成。雖然是在 WGAN 的基礎上開展的工作,但是 Curriculum GAN 的思想的普適性是有的,所以具有一定指導意義。

論文引入

讓 GAN 的訓練更穩定生成的樣本更加多樣性一直是 GAN 發展的主要動力,WGAN [1]、LSGAN [2]、WGAN-GP [3] 都是在 GAN 的損失函式上採取改進,將衡量真實和生成樣本的分佈的 JS 距離換為更加優越的衡量標準。

WGAN 就是在 GAN 的基礎上改進的比較成功的一種。WGAN 利用 Wasserstein 距離代替 JS 距離,從而避免了一定的梯度消失問題,這也為很多 GAN 模型的擴充套件提供了指導。詳細的關於 WGAN 的知識,可以參看我之前的部落格 [4]。

WGAN-GP 是在 WGAN 的基礎上改進的,WGAN 在保證 Lipschitz 限制條件時,作者是採用將限制判別器神經網路的所有引數(這裡指權重 w)不超過某個範圍 [-c,c]。這樣做帶來了引數上的兩極化,為了改進 WGAN,WGAN-GP 提出了梯度懲罰概念用於滿足 Lipschitz 限制條件。具體展開描述,可以參看我之前的部落格 [5]。Curriculum GANs 其是在 WGAN-GP 的基礎上改進的,但是思路是沿襲 WGAN 所以也稱之為 WGAN-C。

在訓練 GAN 上有很多 trick,比如如何衡量生成器和判別器的強弱從而控制一方的能力;在判別器中加入 minibatch,用於衡量更多的樣本,從而豐富生成的多樣性;合理的設計網路深度和引數等等。這些 trick 確實提高了 GAN 的訓練穩定性和生成上的多樣性,但是仍無法避免 GAN 的問題。

為 GAN 設計課程,從而讓生成器逐步的進步。這在邏輯上是行得通的。WGAN-C 就是定義一個越來越嚴苛的判別器,用於發現生成器的問題,生成器為了欺騙住判別器,需要在越來越難的課程任務下不斷進步。由於生成器已經有了先前學習的基礎,在最小化真實和生成樣本分佈上逐漸的進步,有了學習基礎增大難度使得生成器的能力越來越強,從而生成質量更高的影象。

總結一下 WGAN-C 的優勢:

1. 為 GAN 設計了一個課程,透過不斷提高判別器的判別能力從而增強生成器的能力;

2. Curriculum GANs 的思想不僅僅適用於 WGAN 還適用於其它的 GAN 模型,不僅僅是在影象的生成,在文字到影象,影象到影象都有指導意義。

WGAN-C思想

WGAN-C 不考慮固定一個判別器![]() ,而是考慮預定義的一組判別器的凸組合,定義

,而是考慮預定義的一組判別器的凸組合,定義 表示,使得

表示,使得 。判別器的組合可以寫為

。判別器的組合可以寫為 。其中的 λ 可以被視為是判別器的能力,λ 值越大也就是意味著判別器的區分能力越強。

。其中的 λ 可以被視為是判別器的能力,λ 值越大也就是意味著判別器的區分能力越強。

這裡面是有著一套嚴格的數學證明的,整體的思路就是隨著 λ 的增加,越大的 λ 可以支配前面的 λ,越大的 λ 可以滿足之前的要求同時也增強了現有的能力,從而實現了判別能力的逐步增強。根據難度程度對訓練樣本進行排序,形成判別器的凸組合。

我們透過文中的圖來進一步分析:

從圖中可以看到隨著 λ1 到 λ3 逐漸的增大,生成的影象的質量也是越來越好。

WGAN-C實現

我們先來對比一下 WGAN-C 和 WGAN-GP 在實現演演算法上的不同,先上 WGAN-GP 的實現演演算法框圖:

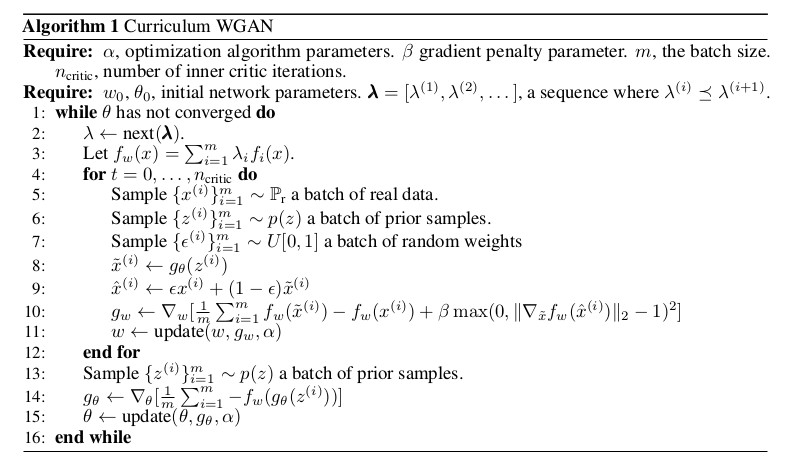

我們再來看看 WGAN-C 的實現演演算法框圖:

透過對比我們發現,整體上兩個是相似的,WGAN-C 要多了些操作,那就是多了 λ 的選取和相應的判別器的選取,透過不斷的提高判別器的判別能力從而實現生成器的生成能力的不斷提高,此處控制梯度懲罰的引數用 β 表示了。

WGAN-C實驗

WGAN-C 的實驗主要在正弦曲線的生成和人臉的生成上,在正弦曲線生成上,實驗對比了有無課程指導的 GAN 的生成效果,從下圖可以看出來在相同網路下加入課程指導的 GAN 生成的正弦曲線更加的真實。

在生成正弦曲線的定量上也對比了有無課程指導的效果,測量了生成的波與資料集中最接近的正弦波的平均 l − 2 誤差(透過離散生成資料集的正弦波的範圍)。在訓練結束時,漸進式延長策略產生的正弦曲線的平均誤差降低了 33.6% – 訓練資料集的平均最小距離 l − 2 在課程指導下產生的正弦曲線為 1.13 ± 0.01 ,並且沒有課程指導生成的誤差為 1.51 ± 0.06 。

在人臉生成上,也對比了有無課程指導下的生成效果。

總結

WGAN-C 在 WGAN 的基礎上為 GAN 設計了課程,透過不斷增加判別器的判別能力來提高課程的難度,相對應的,作為學生的生成器在高難度的課程下不斷提高生成能力,從而實現匹配課程難度的生成能力。

WGAN-C 為 GAN 設計課程的思路適用於各種 GAN 模型,同時不僅僅是在影象生成上,在其他 GAN 的生成上也可以發揮作用。

參考文獻

[1]. Arjovsky, M., Chintala, S., and Bottou, L. (2017). Wasserstein gan. arXiv preprint arXiv:1701.07875.

[2]. Xudong Mao, Qing Li, Haoran Xie, Raymond YK Lau, Zhen Wang, and Stephen Paul Smolley. Least squares generative adversarial networks. arXiv preprint, ArXiv:1611.04076, Apr. 2016.

[3]. Gulrajani, I., Ahmed, F., Arjovsky, M., Dumoulin, V., and Courville, A. (2017). Improved training of wasserstein gans. arXiv preprint arXiv:1704.00028.

[4]. http://www.twistedwg.com/2018/01/31/WGAN.html

[5]. http://www.twistedwg.com/2018/02/02/WGAN-GP.html

本文由 AI 學術社群 PaperWeekly 精選推薦,社群目前已改寫自然語言處理、計算機視覺、人工智慧、機器學習、資料挖掘和資訊檢索等研究方向,點選「閱讀原文」即刻加入社群!

點選標題檢視更多論文解讀:

關於PaperWeekly

PaperWeekly 是一個推薦、解讀、討論、報道人工智慧前沿論文成果的學術平臺。如果你研究或從事 AI 領域,歡迎在公眾號後臺點選「交流群」,小助手將把你帶入 PaperWeekly 的交流群裡。

▽ 點選 | 閱讀原文 | 下載論文

知識星球

知識星球