小編邀請您,先思考:

1 什麼是機器學習演演算法?

2 如何使用機器學習演演算法?

3 機器學習演演算法的能與不能?

本篇內容主要是面向機器學習初學者,介紹常見的機器學習演演算法,當然,歡迎同行交流。

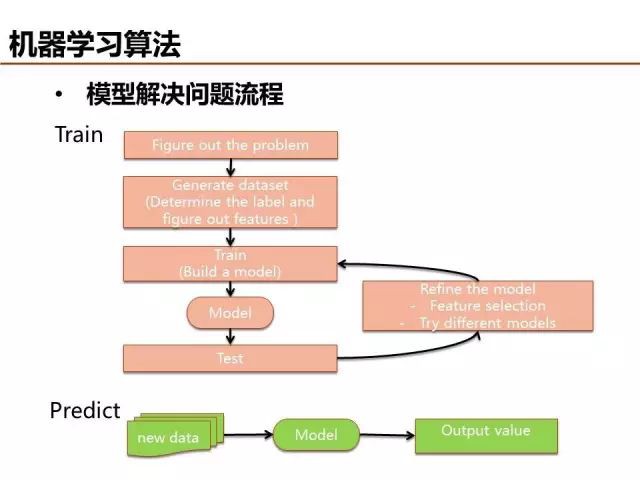

哲學要回答的基本問題是從哪裡來、我是誰、到哪裡去,尋找答案的過程或許可以借鑒機器學習的套路:組織資料->挖掘知識->預測未來。組織資料即為設計特徵,生成滿足特定格式要求的樣本,挖掘知識即建模,而預測未來就是對模型的應用。

特徵設計依賴於對業務場景的理解,可分為連續特徵、離散特徵和組合高階特徵。本篇重點是機器學習演演算法的介紹,可以分為監督學習和無監督學習兩大類。

無監督學習演演算法很多,最近幾年業界比較關註主題模型,LSA->PLSA->LDA為主題模型三個發展階段的典型演演算法,它們主要是建模假設條件上存在差異。LSA假設檔案只有一個主題,PLSA假設各個主題的機率分佈不變(theta都是固定的),LDA假設每個檔案和詞的主題機率是可變的。

LDA演演算法本質可以藉助上帝擲骰子幫助理解,詳細內容可參加Rickjin寫的《LDA資料八卦》文章,淺顯易懂,順便也科普了很多數學知識,非常推薦。

監督學習可分為分類和回歸,感知器是最簡單的線性分類器,現在實際應用比較少,但它是神經網路、深度學習的基本單元。

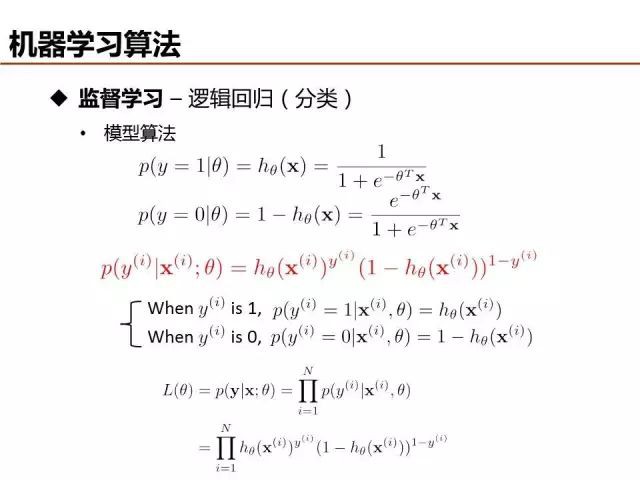

線性函式擬合資料並基於閾值分類時,很容易受噪聲樣本的幹擾,影響分類的準確性。邏輯回歸(Logistic Regression)利用sigmoid函式將模型輸出約束在0到1之間,能夠有效弱化噪聲資料的負面影響,被廣泛應用於網際網路廣告點選率預估。

邏輯回歸模型引數可以透過最大似然求解,首先定義標的函式L(theta),然後log處理將標的函式的乘法邏輯轉化為求和邏輯(最大化似然機率 -> 最小化損失函式),最後採用梯度下降求解。

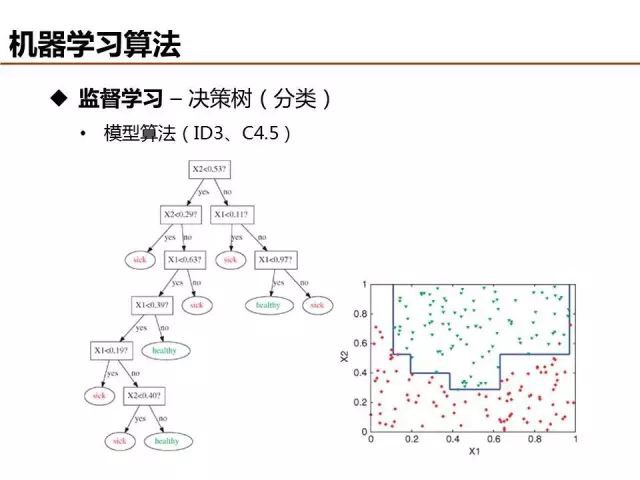

相比於線性分類去,決策樹等非線性分類器具有更強的分類能力,ID3和C4.5是典型的決策樹演演算法,建模流程基本相似,兩者主要在增益函式(標的函式)的定義不同。

線性回歸和線性分類在表達形式上是類似的,本質區別是分類的標的函式是離散值,而回歸的標的函式是連續值。標的函式的不同導致回歸通常基於最小二乘定義標的函式,當然,在觀測誤差滿足高斯分佈的假設情況下,最小二乘和最大似然可以等價。

當梯度下降求解模型引數時,可以採用Batch樣式或者Stochastic樣式,通常而言,Batch樣式準確性更高,Stochastic樣式複雜度更低。

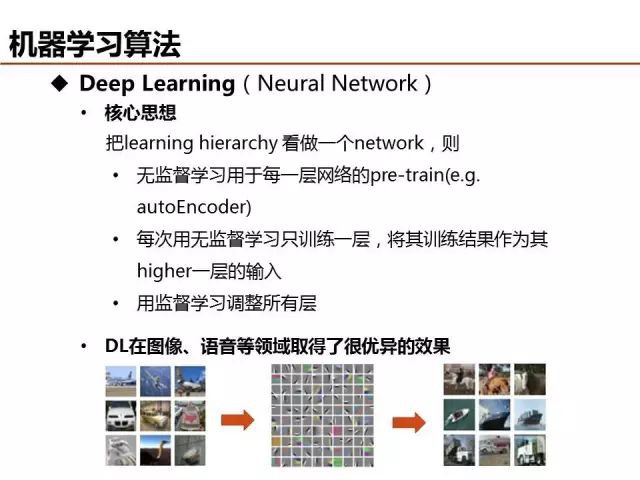

上文已經提到,感知器雖然是最簡單的線性分類器,但是可以視為深度學習的基本單元,模型引數可以由自動編碼(Auto Encoder)等方法求解。

深度學習的優勢之一可以理解為特徵抽象,從底層特徵學習獲得高階特徵,描述更為複雜的資訊結構。例如,從畫素層特徵學習抽象出描述紋理結構的邊緣輪廓特徵,更進一步學習獲得表徵物體區域性的更高階特徵。

俗話說三個臭皮匠賽過諸葛亮,無論是線性分類還是深度學習,都是單個模型演演算法單打獨鬥,有沒有一種集百家之長的方法,將模型處理資料的精度更進一步提升呢?當然,Model Ensembel就是解決這個問題。Bagging為方法之一,對於給定資料處理任務,採用不同模型/引數/特徵訓練多組模型引數,最後採用投票或者加權平均的方式輸出最終結果。

Boosting為Model Ensemble的另外一種方法,其思想為模型每次迭代時透過調整錯誤樣本的損失權重提升對資料樣本整體的處理精度,典型演演算法包括AdaBoost、GBDT等。

不同的資料任務場景,可以選擇不同的Model Ensemble方法,對於深度學習,可以對隱層節點採用DropOut的方法實現類似的效果。

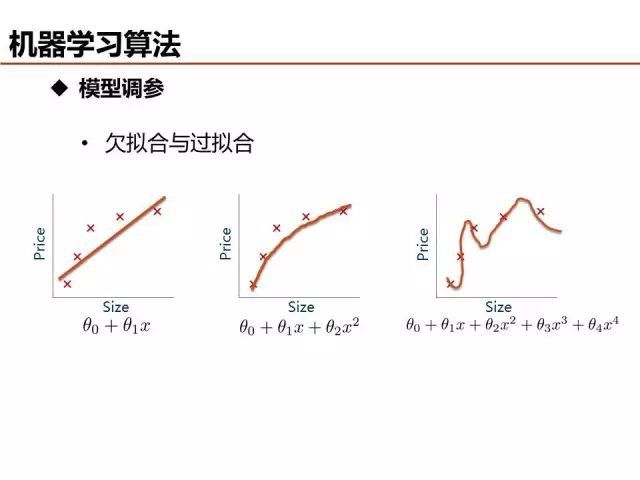

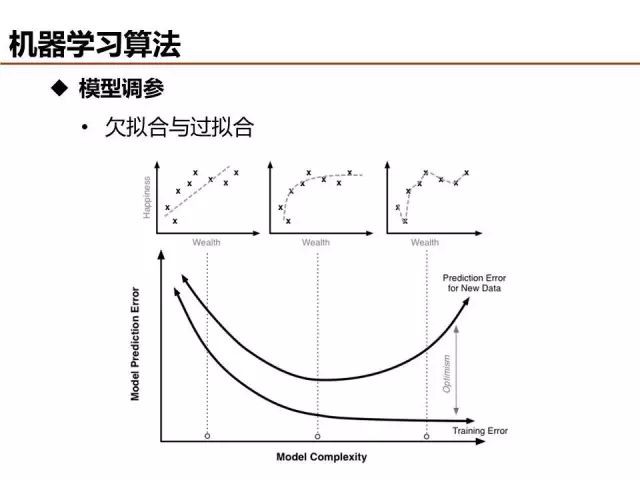

介紹了這麼多機器學習基礎演演算法,說一說評價模型優劣的基本準則。欠擬合和過擬合是經常出現的兩種情況,簡單的判定方法是比較訓練誤差和測試誤差的關係,當欠擬合時,可以設計更多特徵來提升模型訓練精度,當過擬合時,可以最佳化特徵量降低模型複雜度來提升模型測試精度。

特徵量是模型複雜度的直觀反映,模型訓練之前設定輸入的特徵量是一種方法,另外一種比較常用的方法是在模型訓練過程中,將特徵引數的正則約束項引入標的函式/損失函式,基於訓練過程篩選優質特徵。

模型調優是一個細緻活,最終還是需要能夠對實際場景給出可靠的預測結果,解決實際問題。期待學以致用!

親愛的讀者朋友們,您們有什麼想法,請點選【寫留言】按鈕,寫下您的留言。

資料人網(http://shujuren.org)誠邀各位資料人來平臺分享和傳播優質資料知識。

公眾號推薦:

好又樂書屋,分享有益處,有趣味的內容,傳播正能量。

閱讀原文,更多精彩!

分享是收穫,傳播是價值!

知識星球

知識星球